-

论文标题:Natural Language Actor-Critic: SCALABLE OFF-POLICY LEARNING IN LANGUAGE SPACE -

论文链接:https://arxiv.org/pdf/2512.04601

TL;DR

本文介绍了一种名为 Natural Language Actor-Critic (NLAC) 的新型强化学习算法,旨在解决大型语言模型(LLM)Agent 在长程任务中训练不稳定和样本效率低下的问题。与传统的依赖标量奖励的 Actor-Critic 方法不同,NLAC 引入了一个 自然语言评论家 (Natural Language Critic),它不仅评估动作的优劣,还通过预测未来和生成自然语言解释来指导策略改进。

该方法的核心贡献在于:

-

语言贝尔曼备份 (Language Bellman Backup):提出了一种在文本空间进行价值评估更新的机制,支持异策 (Off-policy) 学习,提高了数据效率。 -

自我修正策略提升:利用评论家生成的自然语言反馈,通过辅助的“修正策略”来生成更优动作,并将其蒸馏回主策略,避免了在组合动作空间中进行随机探索的困难。 -

理论保证:证明了该方法学习到的语言表示与后继特征 (Successor Features) 的联系,并证明了策略迭代的收敛性。

实验表明,在数学推理、策略对话和工具使用任务中,NLAC 在样本效率和最终性能上均优于 PPO、GRPO 和现有的语言强化学习方法(如 NLRL)。

1. 引言

随着大型语言模型(LLM)能力的提升,研究重心逐渐从单纯的问答(QA)转移到了能够执行多步操作、使用工具并与环境交互的 LLM Agent。这些任务通常具有以下特征:

-

长程交互 (Long-horizon) :需要多轮对话或多步推理才能完成目标。 -

稀疏奖励 (Sparse Rewards) :往往只有在任务完成时才能获得最终的成败信号,中间步骤缺乏明确反馈。 -

巨大的动作空间:动作是自然语言序列,空间大小随词表和长度指数级增长。

1.1 现有方法的局限性

目前主流的 LLM Agent 训练方法主要分为两类:

-

监督微调 (SFT) :依赖专家演示数据。但在复杂Agent任务中,获取高质量的长程交互数据成本高昂。 -

强化学习 (RL) :使用 PPO (Proximal Policy Optimization) 或 GRPO (Group Relative Policy Optimization) 等算法。

然而,将传统 RL 直接应用于 LLM Agent 存在显著问题:

-

样本效率低:PPO 等算法通常是同策 (On-policy) 的,需要策略在每一轮训练中重新采样大量轨迹,这对于推理成本高昂的 LLM 来说是巨大的负担。 -

标量奖励信号微弱:仅凭一个标量(如 0 或 1)很难指导模型在一个包含数千个 token 的长轨迹中进行具体的信用分配 (Credit Assignment)。模型难以区分哪些特定步骤是错误的。 -

探索困难:在自然语言空间中,依赖随机扰动(如增加 temperature)来探索更优动作的效率极低。模型很难通过随机尝试“碰巧”生成一个语义上更优的复杂指令。

1.2 自然语言作为价值载体

人类在学习复杂任务时,通常依赖定性的语言反馈(例如:“这一步做错了,因为你没有先查询数据库”)而不是分数值(“这一步得 0.3 分”)。基于此直觉,本文提出了 NLAC。

与输出标量价值 的传统 Critic 不同,NLAC 的 Critic 输出自然语言 。这个语言 Critic 不仅预测未来可能发生的情况,还基于此给出动作是否最优的判断及修正建议。这种富含语义的信号可以直接指导 Actor 进行策略改进,而无需盲目探索。

2. 预备知识与问题定义

在深入方法之前,我们将 LLM Agent 任务形式化为马尔可夫决策过程 (MDP)。

-

状态空间 :包含任务描述、历史对话、环境观察的 token 序列。 -

动作空间 :LLM 生成的 token 序列(如思维链或工具调用指令)。 -

环境动态 :环境根据动作返回新的观察(如 API 返回结果或用户回复)。 -

奖励函数 :通常是任务结束时的稀疏信号。

2.1 ReAct Prompting

Agent 通常采用 ReAct 模式,即动作 包含两个部分:

-

思维 (Thought) :推理过程,不影响环境状态。 -

环境动作 (Env Action) :实际执行的操作,触发状态转移。

2.2 传统 Actor-Critic

目标是最大化期望折扣回报 。

传统方法学习一个 Q 函数 ,并通过贝尔曼备份 (Bellman Backup) 进行更新:

NLAC 的核心思想是将这一过程从标量空间迁移到语言空间。

3. Natural Language Actor-Critic (NLAC) 方法论

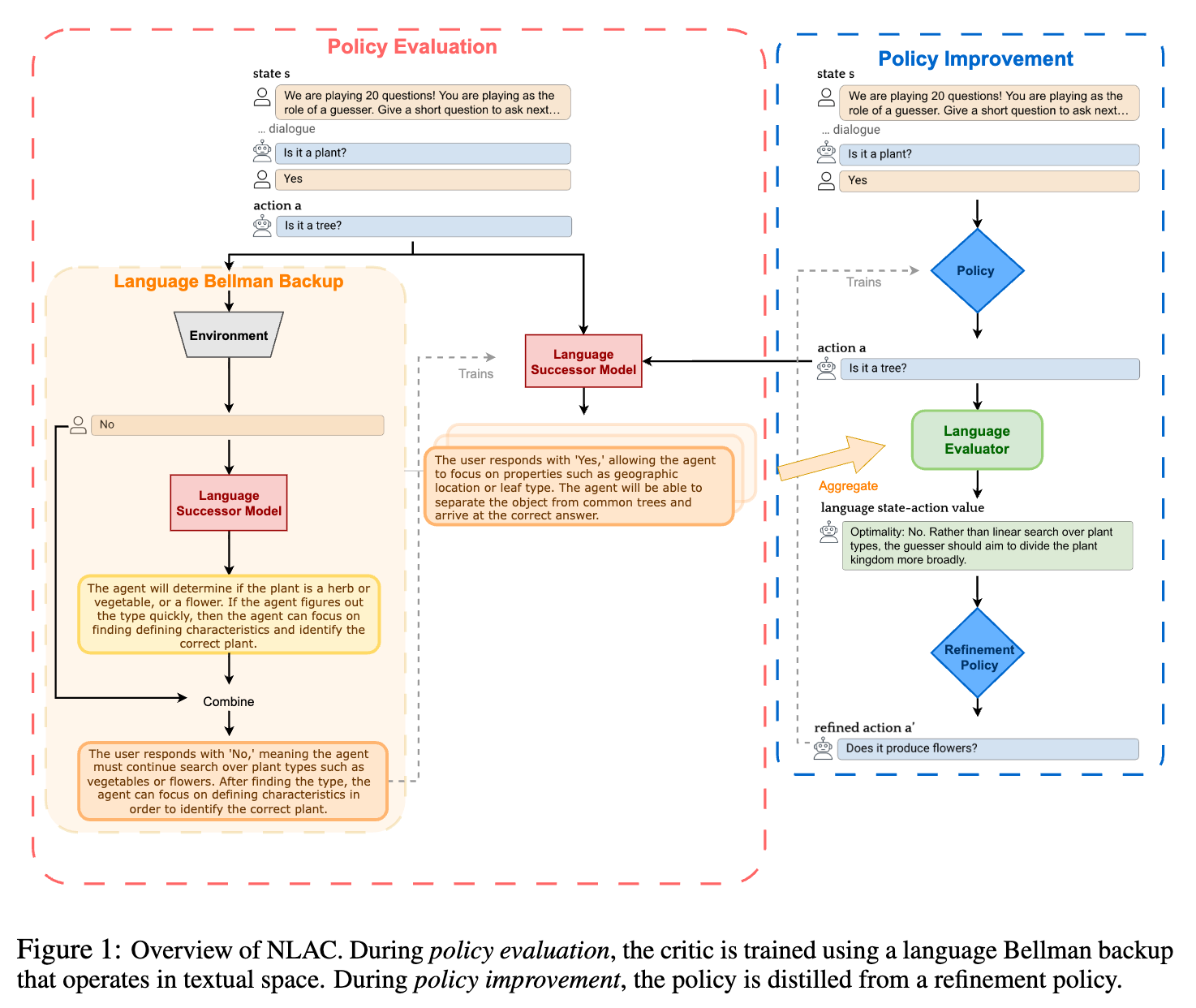

NLAC 遵循标准的 Actor-Critic 范式,包含策略评估 (Policy Evaluation) 和 策略提升 (Policy Improvement) 两个阶段,但在实现上完全依赖 LLM 的生成能力。

3.1 策略评估:构建自然语言评论家

我们需要一个 Critic,它能针对当前状态 和动作 生成一段文本评估。为了让这段评估具有预测性(不仅仅是事后诸葛亮),评论家必须具备预测未来的能力。

3.1.1 语言后继模型 (Language Successor Model)

定义 为语言后继模型。给定 ,它的目标是概率性地生成对未来轨迹 和最终奖励 的文本描述。

这与强化学习中的 Successor Features (SF) 概念密切相关。SF 预测的是未来状态特征的累积期望,而这里的 预测的是未来事件的自然语言摘要。

3.1.2 语言贝尔曼备份 (Language Bellman Backup)

这是 NLAC 最具创新性的部分。传统的 Bellman 备份是数值加权。在语言空间,我们定义 语言贝尔曼备份算子 。

对于状态 和动作 , 构建目标分布的过程如下:

-

采样真实环境的下一步状态 和奖励 。 -

利用当前的 生成从 开始的未来描述 (即 Bootstrapping)。 -

使用一个聚合函数 (通过 Prompt 实现),将即时信息 与未来描述 融合成一个新的描述 。

数学形式上,目标描述 的分布由下式给出:

其中 ,。

训练目标:

我们通过最小化 生成分布与 构造的目标分布之间的差异(如 KL 散度)来训练 Critic:

关键优势:由于使用了 Bootstrapping(利用 预测 之后的未来),该方法不需要完整的蒙特卡洛轨迹,仅需单步转移 即可训练,因此支持 异策 (Off-policy) 学习。这使得 NLAC 可以重用历史数据,大幅提升样本效率。

3.1.3 语言评估器 (Language Evaluator)

为了将预测转化为具体的“好坏”评价,定义评估器 。它接收状态、动作以及 生成的多个可能未来描述 ,输出一段综合性的批评 。

这段批评包含:

-

对动作最优性的判断(Yes/No)。 -

基于预测未来的解释(例如:“这个动作会导致后续搜索空间过大...”)。

3.2 策略提升:自我修正与蒸馏

在获得自然语言批评 后,如何更新策略 ?传统的 在语言空间不可行,因为无法枚举所有可能的句子。

NLAC 利用 LLM 的上下文学习(In-Context Learning)能力,引入一个 修正策略 (Refinement Policy) 。

3.2.1 修正过程

修正策略 接收当前状态 、原始动作 以及 Critic 生成的批评 作为输入,生成一个改进后的动作 :

直觉是:Critic 指出了错误原因,LLM 根据这个原因重新生成动作,往往能得到比随机探索更好的结果。

3.2.2 策略更新目标

我们将修正后的动作 视为“目标动作”,通过监督学习(蒸馏)的方式更新主策略 。

简单来说,就是让主策略 学习直接生成修正策略 在看过 Critic 建议后生成的那个好动作。

4. 理论分析

为了证明 NLAC 的有效性,论文建立其与 后继特征 (Successor Features, SF) 的理论联系。

4.1 假设

-

线性奖励假设:存在状态特征 和权重 ,使得 。 -

表示解码假设:Critic 的语言输出 实际上是对潜在表示 的解码,且语言贝尔曼备份在潜在空间中对应于标准的 SF 贝尔曼备份:

4.2 主要定理

定理 5.1:在上述假设下,策略评估收敛时,自然语言 Critic 的潜在表示收敛于真实的后继特征。这意味着存在一个单调映射 ,使得 。即:语言 Critic 的优劣排序与真实 Q 值一致。

定理 5.2:通过迭代应用语言贝尔曼备份进行评估,并使用修正策略进行提升,算法最终收敛至最优策略 。

这一理论分析非常重要,它将看似经验主义的“语言反馈”建立在了坚实的强化学习理论基础之上,证明了在语言空间进行 Value Iteration 的数学合理性。

5. 算法实现细节

为了便于研究员复现,这里详细拆解 NLAC 的实现细节。虽然逻辑上分为 Critic、Successor Model 等多个组件,但在实践中,所有组件都由同一个 LLM(参数为 )通过不同的 Prompt 来实现。

5.1 训练流程 (Algorithm 1)

-

初始化: 和目标网络 。 -

采样:使用当前策略 与环境交互,将轨迹 存入经验回放池 。由于是异策算法, 可以包含旧策略的数据。 -

优先经验回放:根据 Critic 的 Loss 对样本进行加权采样,重点训练那些 Critic 预测不准或策略表现不佳的样本。 -

参数更新: -

Critic 更新 () :最小化语言贝尔曼备份的 KL 散度。

这里,目标分布由目标网络 生成以保持稳定。 -

Actor 更新 () :最大化生成修正动作 的对数似然。

其中 是由修正 Prompt 引导模型基于 生成的。

-

5.2 Prompt 设计

Prompt 是 NLAC 的“超参数”。

-

预测 Prompt () : -

输入:当前历史。 -

指令:“预测接下来会发生什么,直到任务成功或失败。保持简洁。”

-

-

评估 Prompt () : -

输入:历史 + 动作 + 预测的未来。 -

指令:“基于预测的未来,评估上一步动作是否最优。如果是 No,解释原因并简述如何改进。”

-

-

修正 Prompt () : -

输入:历史 + 动作 + 评估。 -

指令:“参考评估意见,重新生成一个修正后的动作。”

-

5.3 关键技术点:思维链 (CoT) 的修正

这是一个容易被忽视但至关重要的细节。

当使用推理模型(如 QwQ 或 GPT-4-Turbo)作为基础模型时,其输出包含 CoT。

-

问题:在构造 Target 时(Bellman Backup),未来的描述包含了 Ground Truth(例如环境的真实反馈)。如果我们直接让 Critic 学习生成这个 Target,Critic 可能会学会依赖这些它本不该知道的信息(泄露)。 -

解决方案:在附录 B.2 中,作者提到了一种 "Corrected Chain-of-Thought" 技术。在构建训练目标时,会使用一个后处理步骤,重写 Target 中的 CoT,去除对未来真实结果的显式引用,将其改为推测性的语气(例如,将“用户回答了Yes”改为“如果用户回答Yes,那么...”),从而防止信息泄露。

6. 实验设置与结果分析

实验旨在回答三个问题:

-

NLAC 是否比现有的 RL 微调方法更有效? -

自然语言 Critic 是否比标量 Critic 更好? -

异策(Off-policy)训练是否比同策(On-policy)更具样本效率?

6.1 实验基准 (Baselines)

-

Prompting: ReAct (GPT-4) -

SFT: RFT (Rejection Fine-Tuning) -

RL (Scalar): PPO, GRPO -

RL (Language): NLRL (Natural Language Reinforcement Learning, Feng et al., 2025) -

Ablation: SAC (Soft Actor-Critic, 但 Critic 输出标量)

6.2 任务与模型

-

模型:Qwen2.5-7B-Instruct 和 QwQ-32B(推理模型)。 -

任务: -

MATH500-Hard:数学推理(单步任务,主要测试 Reward 预测)。 -

20 Questions (20Q) :策略对话游戏(长程、部分可观测)。 -

-bench:模拟客服,涉及数据库操作和工具调用(复杂环境动态)。

-

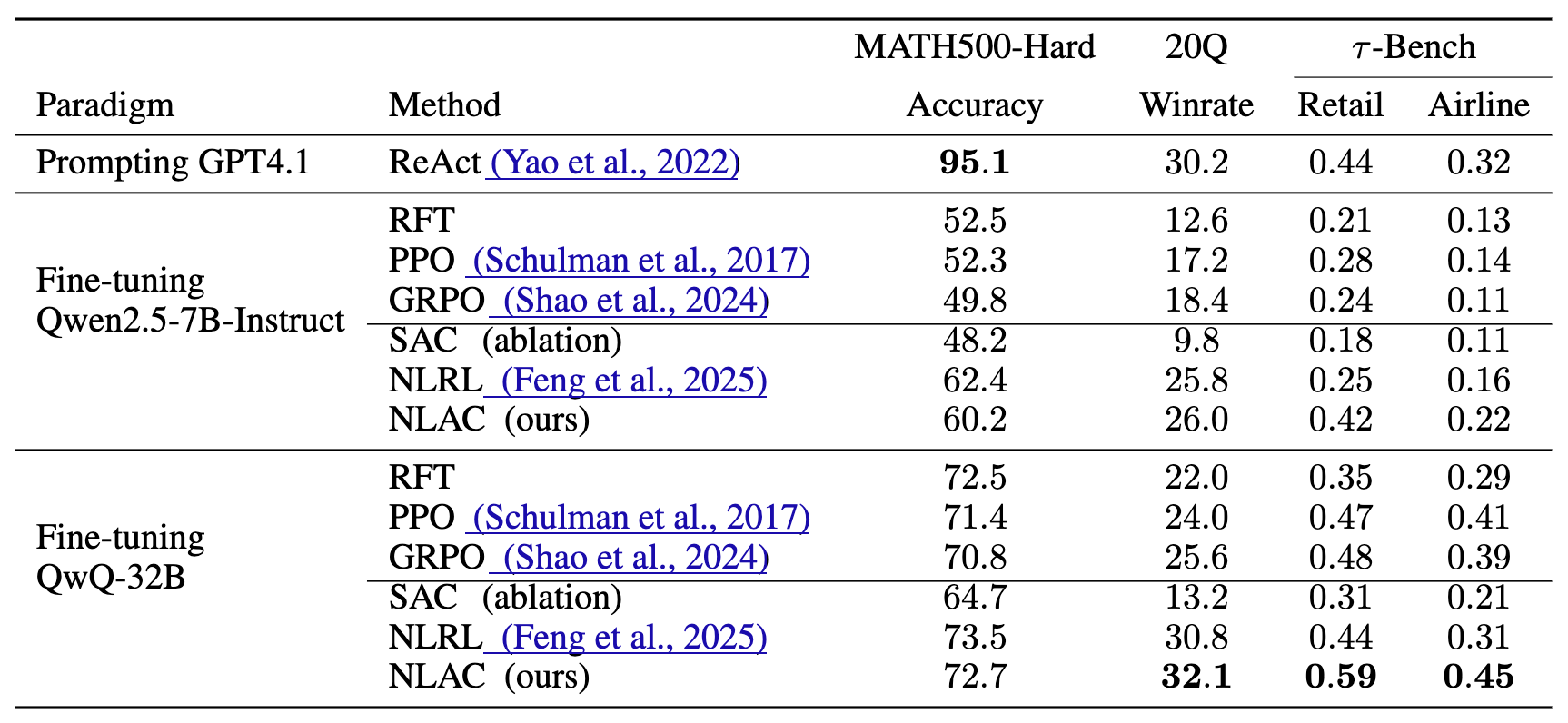

6.3 主要结果

1. 综合性能优越:

NLAC 在所有任务上均取得了最佳或接近最佳的性能。特别是在 20Q 和 -bench 这种长程交互任务中,优势尤为明显。例如在 QwQ-32B 上,NLAC 在 -bench Retail 场景下的成功率达到 0.59,远超 GRPO 的 0.48 和 NLRL 的 0.44。

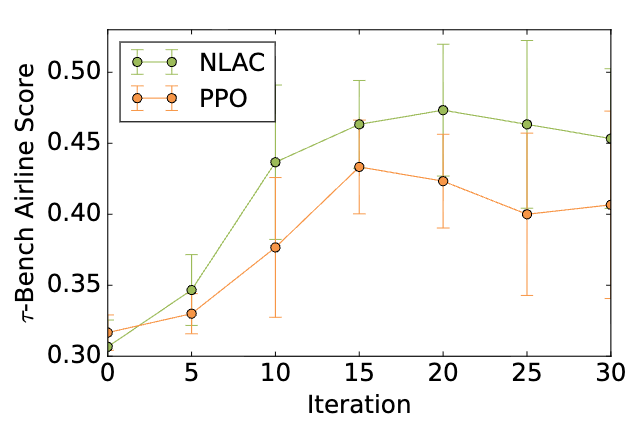

2. 样本效率 (Sample Efficiency) :

学习曲线显示,NLAC 收敛所需的样本量远少于 PPO。这归功于 Off-policy 的特性,可以反复利用 Replay Buffer 中的数据,而 PPO 必须丢弃旧数据。

3. 对比 NLRL:

NLRL 是之前最先进的语言 RL 方法。然而,NLRL 依赖于在 Context 中枚举所有可能的动作和状态转移来计算价值。这在动作空间巨大或环境复杂的任务(如 -bench)中变得不可行。NLAC 通过将未来压缩为语言描述(Successor Model)并进行 Bellman Backup,避免了昂贵的枚举,因此在复杂任务上表现更好。

4. 对比 SAC (Ablation) :

将 NLAC 的 Critic 替换为输出标量值的网络(即标准 SAC),性能大幅下降。这直接证明了 语言 Critic > 标量 Critic。原因在于,标量 Critic 只能告诉 Actor “好”或“坏”,Actor 只能靠随机尝试来改进;而语言 Critic 提供了“如何改进”的信息,指导 Actor 针对性地修正。

6.4 案例分析

在 20 Questions 游戏中,Base Agent 经常会陷入线性搜索的误区(例如,已经知道是“非红色水果”,却还在问颜色)。

-

NLAC Critic:能够敏锐地指出:“Bot 依然在纠结颜色,但这已经是次优策略。应该转而询问大小或味道。” -

Refinement:基于此批评,修正后的 Policy 立即转向了更有区分度的问题。

相比之下,标量 Critic 给出的低分无法包含“应该问味道”这样的语义信息。

7. 讨论与局限性

7.1 灾难性遗忘 (Catastrophic Forgetting)

由于是在特定任务数据上进行 RL 训练,模型可能会丧失通用的指令遵循能力。作者在附录 B.6 中讨论了这一点。虽然可以通过 KL 散度约束(类似 PPO)来缓解,但在实验中发现,即使不加约束,在达到性能峰值前停止训练即可。对于生产环境,混入通用 SFT 数据可能是必要的。

7.2 计算开销

虽然 NLAC 样本效率高(与之交互的环境步数少),但训练时的计算开销较大。

-

Critic 推理:每个样本需要生成未来预测。 -

Actor 推理:需要生成修正动作。

这意味着训练阶段的 GPU 时间可能比简单的 PPO 更长,但这被极高的数据效率所抵消(数据采集往往是瓶颈)。

7.3 与 PRM (Process Reward Models) 的关系

NLAC 的 Critic 可以被视为一种 生成式的 PRM。传统 PRM 输出每一步的分数,而 NLAC Critic 输出每一步的评价。这表明未来 PRM 的发展方向可能不仅仅是打分,而是提供自然语言反馈。

8. 总结与展望

NLAC 提出了一种在语言空间进行异策强化学习的有效框架。它成功地将 Actor-Critic 算法的核心要素(价值评估、贝尔曼更新、策略提升)映射到了 LLM 的文本生成范式中。

核心洞察:

-

Values as Text:对于 LLM Agent,价值函数不应只是一个数字,而应该是对未来的描述和评价。 -

Evaluation as Prediction:好的评价源于对未来的准确预测(Successor Model)。 -

Improvement as Refinement:策略提升不应靠随机探索,而应靠基于评价的自我修正。

这项工作为解决 LLM Agent 训练中的“长程”、“稀疏奖励”和“探索难”问题提供了新的解题思路,也为未来将更复杂的 RL 算法(如基于模型的 RL)引入语言空间奠定了基础。

可视化图解:

更多细节请阅读原论文。

往期文章: