没错,就在刚刚,DeepSeek 又在十一假期前搞事情了,推出了实验性模型 DeepSeek-V3.2-Exp 并将技术论文《DeepSeek-V3.2-Exp: Boosting Long-Context Efficiency with DeepSeek Sparse Attention》一并放出。

-

论文标题:DeepSeek-V3.2-Exp: Boosting Long-Context Efficiency with DeepSeek Sparse Attention -

论文链接:https://github.com/deepseek-ai/DeepSeek-V3.2-Exp/blob/main/DeepSeek_V3_2.pdf

论文中提出了 DeepSeek 稀疏注意力(DeepSeek Sparse Attention, DSA)机制,DeepSeek-V3.2-Exp 基于此实现。该工作并非从零开始构建一个全新的模型,而是选择了一条更具实践意义的路径:在强大的稠密注意力模型 DeepSeek-V3.1-Terminus 的基础上,通过持续训练(Continued Training)的方式,将模型平滑地迁移到稀疏注意力架构上。这种方法旨在探索一种能够继承现有强模型能力,同时赋予其长上下文效率优势的技术路线。

下面我们将深入探讨 DSA 的架构设计,特别是其“闪电索引器”(Lightning Indexer)和细粒度 Token 选择机制;分析其如何通过两阶段的持续预训练和精细的后训练流程,实现从稠密到稀疏的平稳过渡。

1. DSA 架构解析

DeepSeek-V3.2-Exp 的核心架构革新在于引入了 DeepSeek 稀疏注意力(DSA)。与完全重新设计模型不同,研究者选择在 DeepSeek-V3.1-Terminus 的基础上进行最小化的架构修改,即用 DSA 替代原有的标准全注意力(Full Attention)机制。这种策略的优势在于能够最大程度地复用和继承 V3.1 模型的强大基础能力。

DSA 的原型设计主要由两个相互协作的核心组件构成:闪电索引器(Lightning Indexer) 和 细粒度 Token 选择机制(Fine-grained Token Selection Mechanism)。这两个组件共同实现了“先粗后精”的注意力计算范式:首先通过一个轻量级的索引器快速筛选出与当前查询 Token 最相关的候选 Token,然后仅在这部分稀疏的候选集上执行高精度的注意力计算。

1.1 闪电索引器(Lightning Indexer)

闪电索引器的核心任务是为每一个查询 Token(query token) 高效地计算其与所有在它之前的上下文 Token () 之间的相关性得分,这个得分被称为索引分(index score)。该分数直接决定了后续哪些 Token 的键值对(Key-Value entries)将被选中参与核心的注意力计算。其计算公式如下:

我们可以对这个公式的构成进行详细拆解:

-

和 分别代表在模型某一隐藏层中,位置 的查询 Token 和位置 的上下文 Token 的表示向量。 -

是从查询 Token 派生出的查询向量。 -

是从上下文 Token 派生出的键向量。 -

表示索引器的头数(number of indexer heads)。值得注意的是,论文强调 的数量很少,这是其计算效率高的关键之一。 -

是一个权重标量,同样从查询 Token 派生而来。这个权重可以被理解为一种动态的、由当前查询内容决定的“头重要性”度量,允许模型为不同头的匹配结果分配不同的权重。 -

(Rectified Linear Unit) 被选为激活函数。论文指出,选择 ReLU 的主要考量是其计算上的高吞吐量(throughput)。与 Softmax 等需要全局归一化的函数相比,ReLU 仅需进行一次简单的阈值操作,计算成本低廉。

闪电索引器的设计体现了对计算效率的极致追求。首先,它的头数 较少,减少了并行计算的规模。其次,它派生出的查询/键向量维度 也可以被设计得远小于主模型的隐藏层维度 。再者,论文特别提到,该模块可以被实现为 FP8 精度,进一步降低了计算量和内存占用。尽管其理论计算复杂度仍然是 (需要计算每个查询与所有历史 Token 的得分),但由于其计算的“轻量级”特性(低头数、低精度、简单激活函数),其实际计算开销远低于主注意力模块中的矩阵乘法。

1.2 细粒度 Token 选择与注意力计算

在闪电索引器为当前查询 Token 计算出与所有历史 Token 的索引分 之后,细粒度 Token 选择机制便开始工作。它的任务非常直接:从所有历史 Token 中,挑选出索引分最高的 Top-k 个 Token。

这个过程可以形式化地描述为:首先确定一个集合 ,其中 表示 与所有历史 Token 的索引分向量。然后,模型仅检索这个集合 中索引 对应的键值对条目 。这里的 通常代表了 ,即主注意力模块中的 Key 和 Value 向量。

最后,模型的注意力输出 通过在当前查询 和这个稀疏选择出的键值对集合 之间应用标准的注意力机制来计算得出。其公式如下:

通过这一机制,DSA 成功地将核心注意力计算的复杂度从 降低到了 ,其中 是预设的、远小于 的一个常数。这种动态的、基于内容分数的选择机制,相比于固定的稀疏模式,提供了更大的灵活性,使得模型能够根据具体的上下文内容来决定关注哪些信息。

1.3 DSA 在 MLA 架构下的实例化

理论设计需要落脚于具体的模型架构。论文指出,为了能够从 DeepSeek-V3.1-Terminus 进行持续训练,DSA 的具体实现是基于 MLA(Multi-Head Attention)架构的。更进一步,为了追求计算效率,特别是在现代硬件(如 GPU)上实现高性能,研究者选择在 MLA 的 MQA(Multi-Query Attention)模式下实例化 DSA。

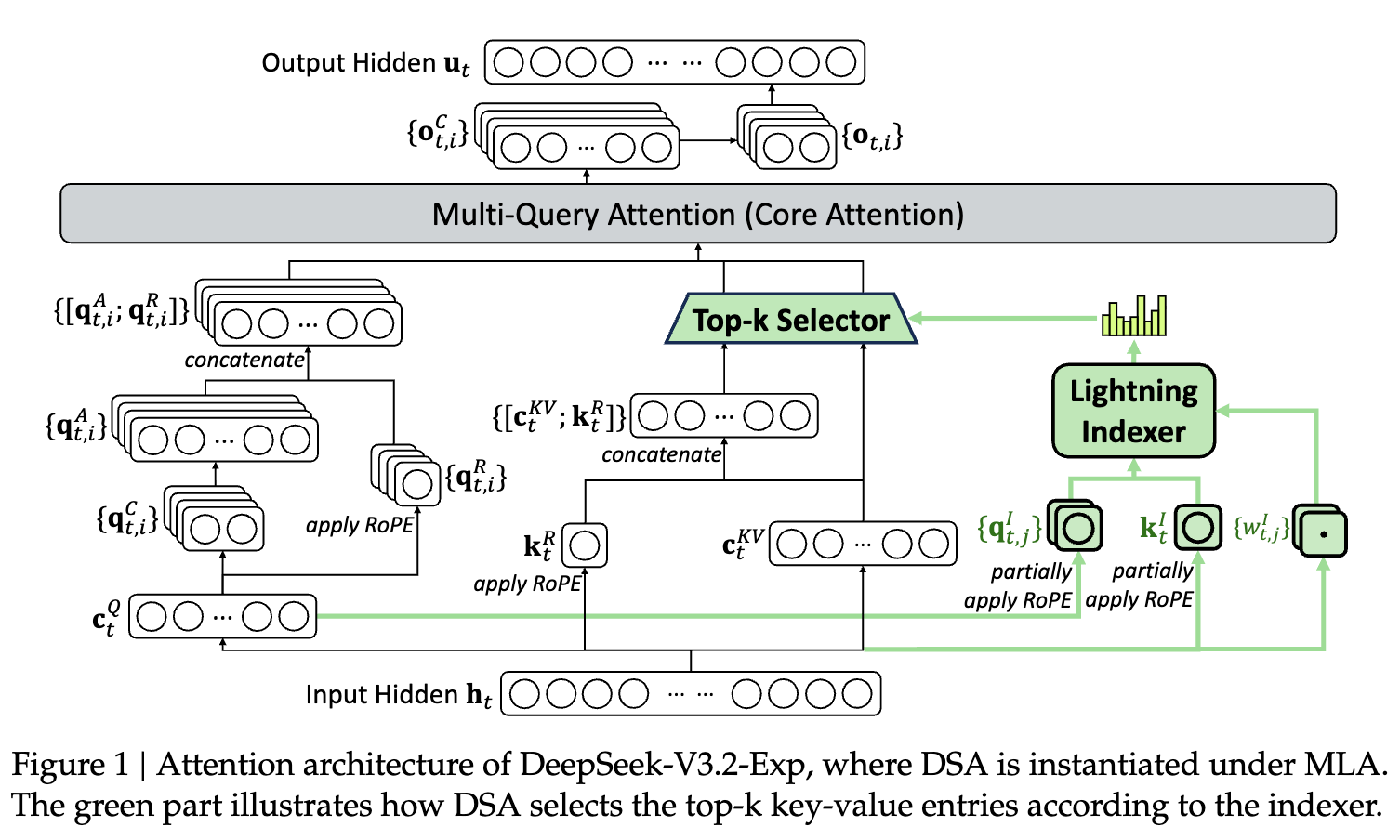

上图清晰地展示了 DSA 在 MQA 模式下的数据流:

-

输入:输入隐状态 进入模块。 -

闪电索引器路径(绿色部分): -

被投影生成索引器所需的查询向量 和头权重 。 -

上下文 Token 则被投影生成索引器的键向量 。 -

通过索引器计算得到分数 。

-

-

主注意力路径: -

被投影生成主注意力模块的查询头 。 -

上下文 Token 被投影生成主注意力模块的键值对 ,即 。

-

-

Top-k 选择:闪电索引器的输出分数被送入 Top-k 选择器,该选择器根据分数从 中筛选出 Top-k 个键值对。 -

核心注意力计算:筛选出的键值对与主查询头 一起进入多查询注意力(Multi-Query Attention)模块,计算最终的输出 。

选择 MQA 模式是一个关键的工程决策。在 MQA 中,所有的查询头共享同一组键(Key)和值(Value)向量。这极大地减少了 KV 缓存(KV Cache)的大小,降低了推理过程中的内存带宽压力,这对于长上下文场景尤为重要。论文引用了相关研究(Yuan et al., 2025; Shazeer, 2019)指出,在核函数(kernel)层面,为了达到高计算效率,每个键值对条目必须在多个查询之间共享。因此,基于 MQA 来实现 DSA 是一种兼顾了模型结构继承性与硬件计算效率的务实选择。

2. 训练策略

将一个已经预训练好的、基于稠密注意力的模型(DeepSeek-V3.1-Terminus)改造为稀疏注意力架构,面临的核心挑战是如何让模型“学会”使用新的稀疏机制,同时不丢失其原有的知识和能力。直接用稀疏注意力从头开始训练一个新模型成本高昂,而直接切换到稀疏模式进行微调则可能导致模型性能的剧烈下降。

DeepSeek-V3.2-Exp 采用了一套精心设计的、分阶段的训练策略,旨在实现从稠密到稀疏的平滑过渡。整个训练流程可以分为两个主要部分:持续预训练(Continued Pre-Training) 和 后训练(Post-Training)。

2.1 持续预训练

持续预训练的目标是让模型的核心参数适应 DSA 架构。这个过程又被细分为两个阶段:密集注意力热身阶段和稀疏训练阶段。值得注意的是,在整个持续预训练过程中,所使用的训练数据分布与 DeepSeek-V3.1-Terminus 用于扩展 128K 上下文的数据完全对齐,以确保数据上的一致性。

2.1.1 密集注意力热身阶段 (Dense Warm-up Stage)

这个阶段的核心目标只有一个:初始化闪电索引器。此时,模型的主体部分,包括主注意力模块,仍然保持标准的稠密注意力模式。研究者冻结了除闪电索引器之外的所有模型参数。

训练的目标是让闪电索引器学会预测主注意力模块的注意力分布。换言之,闪电索引器要学习如何给那些在主注意力模块中获得高分数的 Token 也打上高分。这个过程可以被看作是一种知识蒸馏,其中主注意力模块是“教师”,闪电索引器是“学生”。

具体的对齐方法如下:

-

对于第 个查询 Token,首先获取其在主注意力模块中所有注意力头的注意力分数。 -

将这些分数在所有注意力头上进行求和,得到一个聚合的注意力分数向量。 -

对这个聚合分数向量沿序列维度进行 L1 归一化,从而得到一个目标概率分布 。 -

训练的目标是最小化闪电索引器输出的分布(经过 Softmax 归一化后)与这个目标分布 之间的 KL 散度(Kullback-Leibler Divergence)。

训练索引器的损失函数 定义为:

其中 是闪电索引器为查询 计算出的与所有历史 Token 的原始分数。

这个热身阶段的训练细节是:

-

学习率: -

训练步数:1000 步 -

每步包含的序列数:16 条 -

序列长度:128K Tokens -

总计训练 Token 数:

这是一个短暂而高效的训练阶段,其目的就是快速让闪电索引器具备初步的、可靠的 Token 筛选能力。

2.1.2 稀疏训练阶段 (Sparse Training Stage)

在闪电索引器完成热身之后,训练进入核心的稀疏训练阶段。在这个阶段,模型正式引入细粒度 Token 选择机制,整个模型(包括主干参数和索引器)都将进行优化,以完全适应 DSA 的稀疏工作模式。

这个阶段的训练目标是双重的:

-

对于主模型:继续进行标准的语言建模任务,即优化其语言建模损失(Language Modeling Loss)。这是模型学习世界知识和语言规律的主要信号来源。 -

对于闪电索引器:继续将其输出与主注意力的分布对齐。但与热身阶段不同的是,此时的对齐只考虑被 Top-k 机制选中的 Token 集合 。

因此,索引器的损失函数被修改为:

这里的 和 分别表示目标分布和索引器分数在被选中的 Token 子集 上的部分。这种设计使得索引器的优化目标更加聚焦于如何精确地对最重要的候选 Token 进行排序。

论文中一个值得注意的技术细节是,研究者在计算图中将索引器的输入与主模型的计算图分离开(detach)。这意味着,主模型的梯度不会通过索引器传播。索引器的优化完全由其自身的损失函数 驱动,而主模型的优化则完全由语言建模损失驱动。这种分离的优化策略可能有助于稳定训练过程,避免两个不同目标的梯度相互干扰。

此阶段的训练细节是:

-

学习率: -

选中的键值对 Token 数量(k 值):2048 -

训练步数:15000 步 -

每步包含的序列数:480 条 -

序列长度:128K Tokens -

总计训练 Token 数:

这是一个规模宏大的训练阶段,消耗了大量的计算资源。通过这个阶段,模型不仅适应了稀疏注意力的计算流程,而且其内部参数也针对这种新的信息流模式进行了深度调整。

2.2 后训练 (Post-Training)

在完成持续预训练之后,模型获得了在稀疏注意力模式下进行语言建模的能力,但还需要经过后训练来对齐人类偏好、提升在特定任务(如代码、数学、推理)上的表现。

为了能够严格评估引入 DSA 带来的影响,研究者为 DeepSeek-V3.2-Exp 设计了与 DeepSeek-V3.1-Terminus 完全相同的后训练流程、算法和数据。这确保了两个模型在最终性能上的差异可以最大程度地归因于注意力架构的不同。后训练流程主要包括专家蒸馏和混合强化学习训练。

2.2.1 专家蒸馏 (Specialist Distillation)

这是一种提升模型在特定领域专业能力的有效方法。

-

训练专家模型:首先,从预训练好的 DeepSeek-V3.2 基础检查点(base checkpoint)出发,为每个特定领域(如数学、编程竞赛、逻辑推理、代码智能体、搜索智能体等)分别微调出一个专家模型。 -

生成高质量数据:这些专家模型被用来为各自的领域生成大量高质量的训练数据。这些数据包含了长链式思维(long chain-of-thought reasoning)和直接回答(direct response)两种模式。 -

蒸馏到主模型:最后,将所有专家模型生成的领域数据汇集起来,用于训练最终的模型。实验证明,通过这种方式训练出的模型,其性能可以接近于各个领域的专家模型,并且后续的 RL 训练可以进一步弥合性能差距。

2.2.2 混合强化学习训练 (Mixed RL Training)

为了更好地与人类的指令和偏好对齐,模型接受了基于强化学习的训练。

-

算法:采用了 GRPO(Group Relative Policy Optimization)算法,这是 DeepSeek-AI 自研的一种 RL 算法。 -

混合训练阶段:与之前 DeepSeek 模型采用的多阶段 RL 训练不同,此次训练将推理、智能体和人类对齐这三个方面的训练合并到了一个 RL 阶段中。论文指出,这种方法能够有效地平衡模型在不同领域的能力,同时避免了多阶段训练中常见的灾难性遗忘(catastrophic forgetting)问题。

通过这样一套完整的训练流程,DeepSeek-V3.2-Exp 最终得以成型,它既继承了 V3.1 的强大基础,又具备了 DSA 带来的高效率特性。

3. 实验评估与分析

对一个新模型的评估需要从两个维度展开:一是模型的能力是否有所下降,二是在效率上是否取得了预期的提升。论文对 DeepSeek-V3.2-Exp 进行了详尽的评估,并与它的前身 DeepSeek-V3.1-Terminus 进行了直接对比。

3.1 模型能力评估

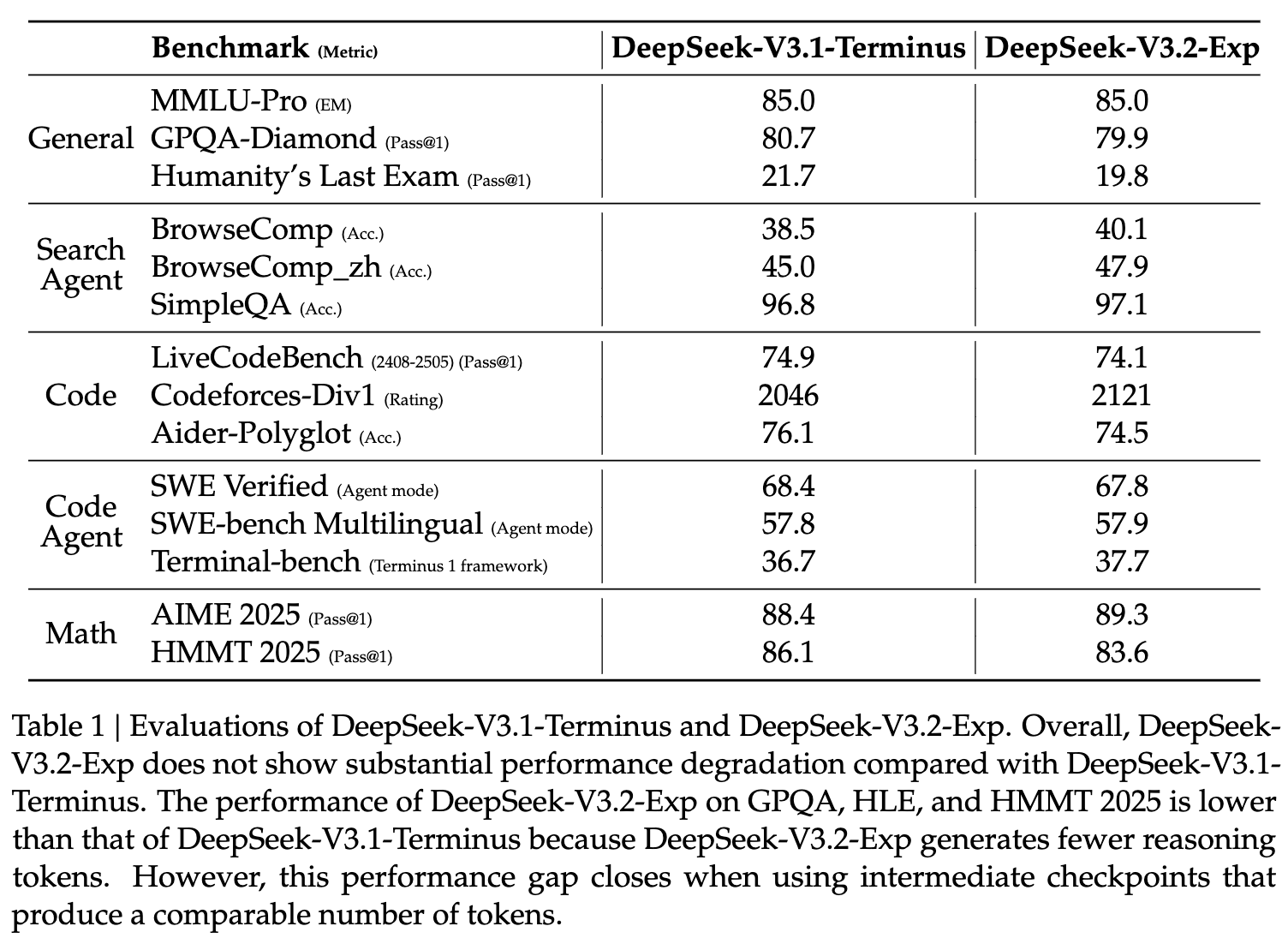

研究者在一系列涵盖通用、搜索、代码、智能体和数学等多个维度的基准测试上对两个模型进行了评估。

从表格中的数据可以看出,总体上,DeepSeek-V3.2-Exp 与 DeepSeek-V3.1-Terminus 的性能表现基本持平,没有出现因为引入稀疏注意力而导致的大幅度性能下降。

-

在 MMLU-Pro 这样的通用知识评估上,两者得分同为 85.0。 -

在 BrowseComp(英文及中文)和 SimpleQA 等搜索与问答任务上,V3.2-Exp 甚至取得了微弱的优势。 -

在 Codeforces-Div1 编程能力评估上,V3.2-Exp 的评分(2121)高于 V3.1(2046)。 -

在 AIME 2025 数学竞赛问题上,V3.2-Exp 的 Pass@1 分数也略高于 V3.1。

然而,在 GPQA-Diamond、Humanity's Last Exam (HLE) 和 HMMT 2025 这三个测试上,V3.2-Exp 的表现略低于 V3.1-Terminus。论文对此进行了解释:他们发现 V3.2-Exp 在生成推理时倾向于产生更少的推理 Token。这种“言简意赅”的特性可能会在一些需要详尽推理步骤的评测中导致失分。但论文同时指出,如果使用一个产生相似数量推理 Token 的中间检查点(intermediate checkpoint)进行测试,这种性能差距会随之消失。这表明性能的微小差异可能更多地与模型的生成策略有关,而非核心能力的损失。

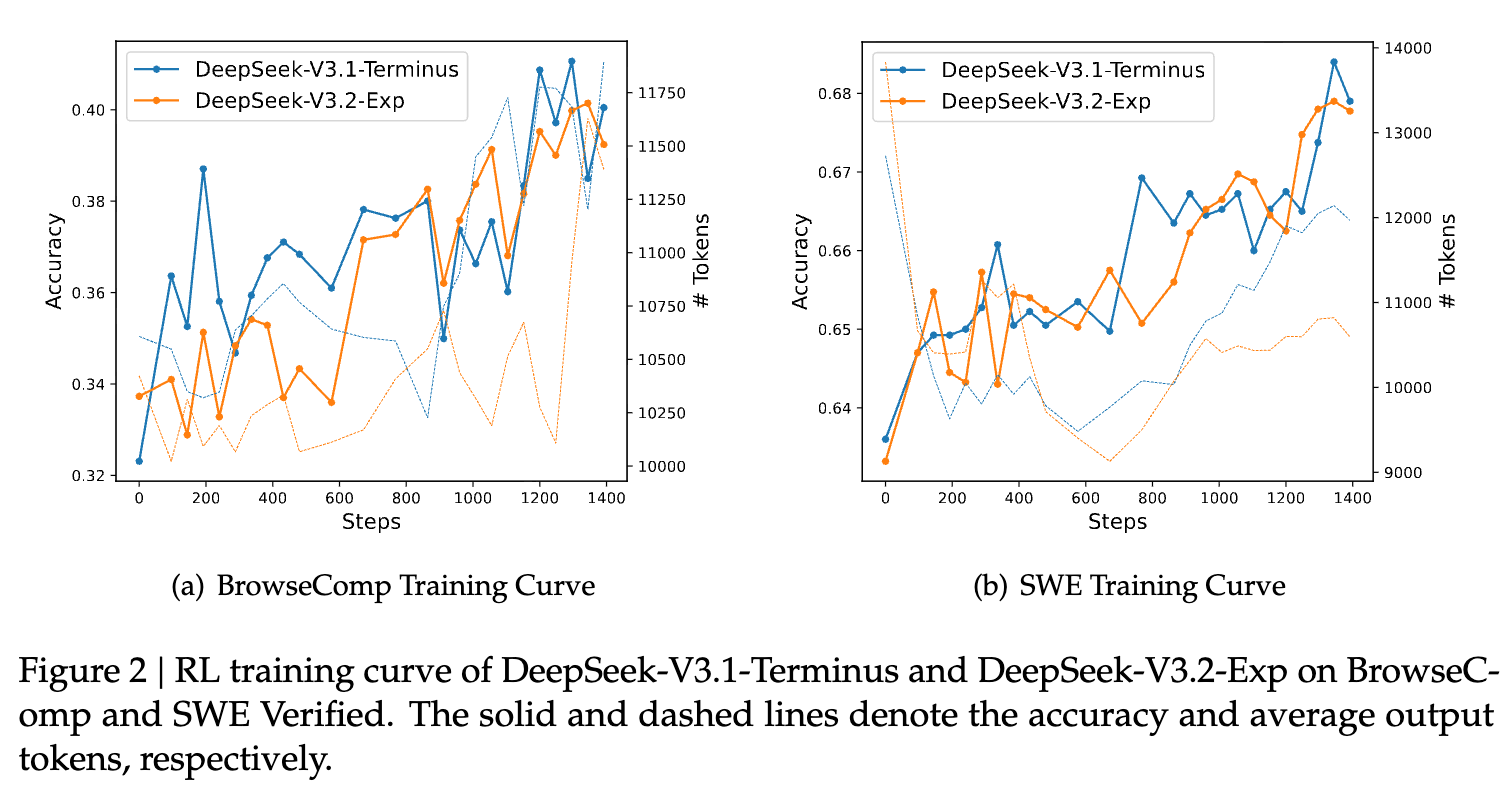

为了进一步验证 DSA 在训练过程中的稳定性,论文还展示了两个模型在 RL 训练过程中,在 BrowseComp 和 SWE Verified 两个任务上的性能变化曲线。

从图中可以看到,无论是 V3.1-Terminus 还是 V3.2-Exp,其在两个任务上的准确率(实线)都随着训练步数的增加而稳步提升。两条曲线的走势高度重合,这有力地证明了 DSA 架构具有良好的训练稳定性,并不会因为引入稀疏性而导致训练过程变得脆弱或难以收敛。

3.2 推理成本分析

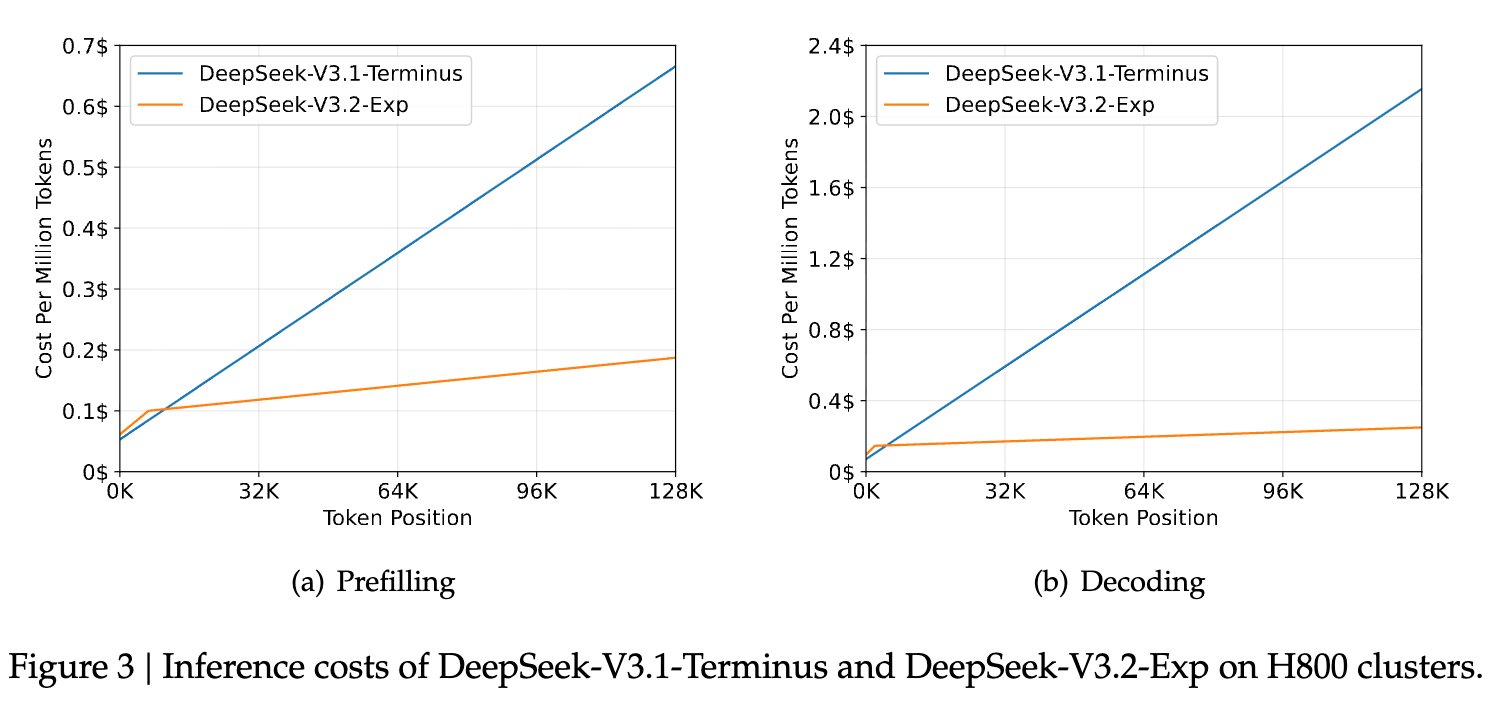

评估的另一个关键维度是推理成本,这也是引入 DSA 的初衷。理论上,DSA 将核心注意力的复杂度从 降至 。尽管闪电索引器本身仍有 的复杂度,但其极低的计算常数使得总体计算量显著减少。

论文通过在 H800 GPU 集群上部署的实际服务进行基准测试,给出了两个模型在不同上下文长度下的推理成本对比。成本以处理每百万 Token 所需的美元计价(基于 2 美元/GPU 小时的租赁价格)。

上图清晰地展示了 DSA 带来的效率提升:

-

图(a) Prefilling 阶段:Prefilling 是指处理用户输入的初始长文本的过程。对于 DeepSeek-V3.1-Terminus(蓝色曲线),其成本随着 Token 位置的增加大致呈线性增长,这符合稠密注意力机制的特点。而 DeepSeek-V3.2-Exp(橙色曲线)的成本增长则缓慢得多,在处理 128K 的长上下文时,其成本远低于 V3.1。这表明 DSA 在处理长输入时具有巨大的成本优势。 -

图(b) Decoding 阶段:Decoding 是指模型逐个生成回复 Token 的过程。在这个阶段,模型需要将新生成的 Token 与全部的上下文进行注意力计算。同样地,V3.2-Exp 的解码成本也显著低于 V3.1,并且随着上下文长度的增加,这种优势愈发明显。

这些基于真实部署环境的测试数据,为 DSA 在长上下文场景下实现端到端显著加速和成本节约提供了有力的实证支持。

4. 总结

论文通过引入 DeepSeek 稀疏注意力(DSA)机制,成功地在保持高性能的同时,显著提升了大型语言模型在长上下文场景下的训练和推理效率。

这项工作的主要贡献可以总结为以下几点:

-

提出了一种有效的稀疏注意力架构(DSA):通过结合一个轻量级的“闪电索引器”和一个细粒度的 Top-k Token 选择机制,DSA 实现了一种灵活且高效的动态稀疏注意力模式。这种“先粗筛,后精算”的范式,在理论和实践上都被证明是可行的。 -

展示了一条从稠密到稀疏的平滑迁移路径:该研究并非另起炉灶,而是基于强大的稠密模型 DeepSeek-V3.1-Terminus,通过精心设计的持续预训练(热身阶段+稀疏训练阶段)和后训练策略,成功地将模型迁移至稀疏架构。这为如何利用现有的大量优质稠密模型资产,赋予其长上下文处理效率,提供了一条具有很高实践价值的技术路线。 -

提供了坚实的实验证据:通过在众多基准测试上的全面评估,论文证明了 DeepSeek-V3.2-Exp 在性能上与 V3.1-Terminus 基本持平,打消了关于稀疏化可能导致性能大幅下降的顾虑。同时,基于 H800 集群的实际部署成本分析,直观地量化了 DSA 在 Prefilling 和 Decoding 阶段带来的显著成本节约。

当然,该工作也指出了未来的方向。论文在结尾提到,尽管内部评估结果令人鼓舞,但团队仍在积极寻求在更广泛的真实世界场景中进行大规模测试,以发掘当前稀疏注意力架构可能存在的潜在局限性。

往期文章: