-

论文标题:Does Reinforcement Learning Really Incentivize Reasoning Capacity in LLMs Beyond the Base Model? -

论文链接:https://arxiv.org/pdf/2504.13837

TL;DR

今天和大家分享一篇重磅之作 ——NeurIPS 2025 唯一满分论文《Does Reinforcement Learning Really Incentivize Reasoning Capacity in LLMs Beyond the Base Model?》。这篇由清华、上交团队完成的研究,其实早在今年 4 月就已发布,核心结论如今已成为行业共识。但能拿下顶会唯一满分,还斩获 ICML 2025 AI4Math Workshop 最佳论文奖并入选大会口头报告,足以见得它在研究深度、实验设计上的过人之处,其中不少亮点值得我们学习。

近期也有业内人士针对该论文观点提出不同看法,认为《RL Grokking Receipe: How Does RL Unlock and Transfer New Algorithms in LLMs?》(https://www.mlpod.com/1209.html)通过改变奖励方式,让强化学习探索到了模型能力之外的区域,先以大范围奖励拓宽激活边界,再择优寻找正确答案,这种思路具有可行性。

该论文作者也回应称,其论文主要针对当时的 RLVR 范式(为大语言模型推理设置 0/1 奖励),在论文中就提出通过发展密集奖励、探索等技术可逐步解决相关问题,《RL Grokking Receipe》正是密集奖励的一种形式,目前的难题在于针对通用问题仍很难设置密集奖励(RL Grokking作者也说明不一定总能出现 “grokking” 现象)。

这篇论文对大型语言模型(LLM)中广泛应用的“带可验证奖励的强化学习”(Reinforcement Learning with Verifiable Rewards, RLVR)技术提出了一个批判性的审视。尽管 RLVR 在提升模型于数学、编程等推理任务上的表现取得了显著成功,并被普遍认为能够帮助模型自我改进、学习超越其基础模型(Base Model)的新推理能力,但该研究得出了一个截然不同的结论。

通过引入 pass@k(在 k 次采样中至少有一次成功即视为解决)这一评估指标,并在大 k 值下系统性地探测模型的推理能力边界,作者发现:

-

RLVR 并不创造新的推理能力,而是优化已有能力的采样效率。在低

k值(例如k=1)时,经过 RLVR 训练的模型表现优于基础模型;但随着k值的增大,基础模型的性能会反超 RLVR 模型。这表明基础模型本身就拥有更广泛的潜在解题能力(reasoning coverage),而 RLVR 只是让模型更“高效地”找到那些正确的解题路径。 -

RLVR 训练后,模型的推理能力边界甚至会收缩。实验表明,对于某些基础模型能够解决的问题,RLVR 模型反而失去了解决能力。这意味着 RLVR 在放大“正确”路径概率的同时,也抑制了其他潜在的、可能正确的探索路径,导致模型整体的解题范围变窄。

-

RLVR 模型所使用的推理路径,在基础模型中业已存在。通过对模型生成内容的困惑度(Perplexity)进行分析,作者发现 RLVR 模型生成的正确解题路径在基础模型看来具有很低的困惑度,这说明这些路径本就处于基础模型的采样分布之内,并非 RLVR 过程中新发现的。

-

知识蒸馏(Distillation)与 RLVR 有本质区别。与 RLVR 不同,知识蒸馏能够从一个更强大的教师模型那里学习到新的推理模式,从而真正地扩展学生模型的推理能力边界,使其超越原始基础模型。

-

当前主流的 RLVR 算法表现相近,且远未达到理论上限。作者将基础模型的

pass@k(k 很大时)视为性能的“上界”,并定义了一个“采样效率差距”(Sampling Efficiency Gap)指标。研究发现,包括 PPO、GRPO 在内的多种流行 RL 算法在该指标上表现类似,并且离这个上界还有很大距离。

总而言之,这篇论文的核心论点是:当前形态的 RLVR 并未真正激励 LLM 产生超越其基础模型的全新推理能力。它的作用更像是一个“滤波器”或“放大器”,优化了模型从其固有能力库中提取正确答案的效率,但这个能力库的边界是由基础模型预先决定的。这为我们重新思考强化学习在 LLM 中的作用,以及如何设计能够真正促进能力涌现的新范式,提供了重要的视角和证据。

1. 引言

近年来,以 OpenAI-o1、DeepSeek-R1 和 Kimi-1.5 等为代表的、以推理为中心的 LLM 取得了长足的进步,尤其是在处理数学、编程等复杂逻辑任务上。推动这一进步的关键技术之一,便是“带可验证奖励的强化学习”(Reinforcement Learning with Verifiable Rewards, RLVR)。与依赖人类标注的传统指令微调不同,RLVR 利用自动化的方式(如数学题的最终答案验证、代码的单元测试)为模型的输出提供奖励信号,从而进行强化学习优化。

这个框架因其简洁、可扩展和高效而备受关注。在传统的强化学习领域,例如 Atari 游戏和围棋(Go),智能体通过与环境的互动和自我探索,能够发现全新的策略,甚至达到超越人类的水平。受此启发,许多作者相信,RLVR 同样能让 LLM 实现持续的自我完善,自主发展出新颖的推理模式,从而突破其基础模型(base model)的能力上限。RLVR 因此被视为一条通往更强大通用智能的有前途的路径。

然而,尽管经验上 RLVR 带来了显著的性能提升(通常在 pass@1 指标上衡量),但其背后的机制是否真的如我们所愿,仍然缺乏深入的审视。这引出了一个根本性的问题:

当前的 RLVR 技术,究竟是真的让 LLM 学会了新的推理能力,还是仅仅让它更熟练地运用了基础模型中已经存在的知识?

为了回答这个问题,我们需要一种能够精确评估模型“潜在能力边界”而非“平均表现”的方法。传统的评估指标,如贪心解码(greedy decoding)或核心采样(nucleus sampling)的平均得分,反映的是模型在有限尝试下的典型行为。这可能会低估一个模型的真实潜力——一个模型或许在几次尝试内失败了,但只要给予足够多的采样机会,它可能最终能够解决问题。

为此,本论文的作者借鉴并扩展了代码生成领域常用的 pass@k 指标。pass@k 的核心思想是:对一个问题进行 k 次采样,只要其中有一次采样得到了正确的结果,就认为模型“有能力”解决这个问题。通过考察 pass@k 在不同 k 值(特别是很大的 k 值,如 256 或 1024)下的表现,我们可以更准确地描绘出模型的推理能力覆盖范围。如果 RLVR 真的能带来超越基础模型的能力,那么在足够大的 k 值下,RLVR 模型的 pass@k 应该能够解决一些基础模型无论如何都解决不了的问题,从而在 pass@k 曲线上展现出更高的上限。

基于这一评估框架,论文对多个 LLM 家族(如 Qwen2.5, LLaMA-3.1)、不同模型尺寸和多种 RLVR 算法进行了系统性的实验,并将 RLVR 训练后的模型与其对应的基础模型进行了直接比较。实验结果揭示了一系列出乎意料的发现,为我们理解 RLVR 的真实作用提供了全新的、更为审慎的视角。

2. 核心发现:RLVR 模型的推理边界并未超越基础模型

论文的核心论点建立在一系列跨越不同任务、模型和算法的扎实实验之上。这些实验共同指向一个结论:RLVR 训练后的模型,其推理能力的边界,并没有超越,甚至在某些情况下还窄于其对应的基础模型。

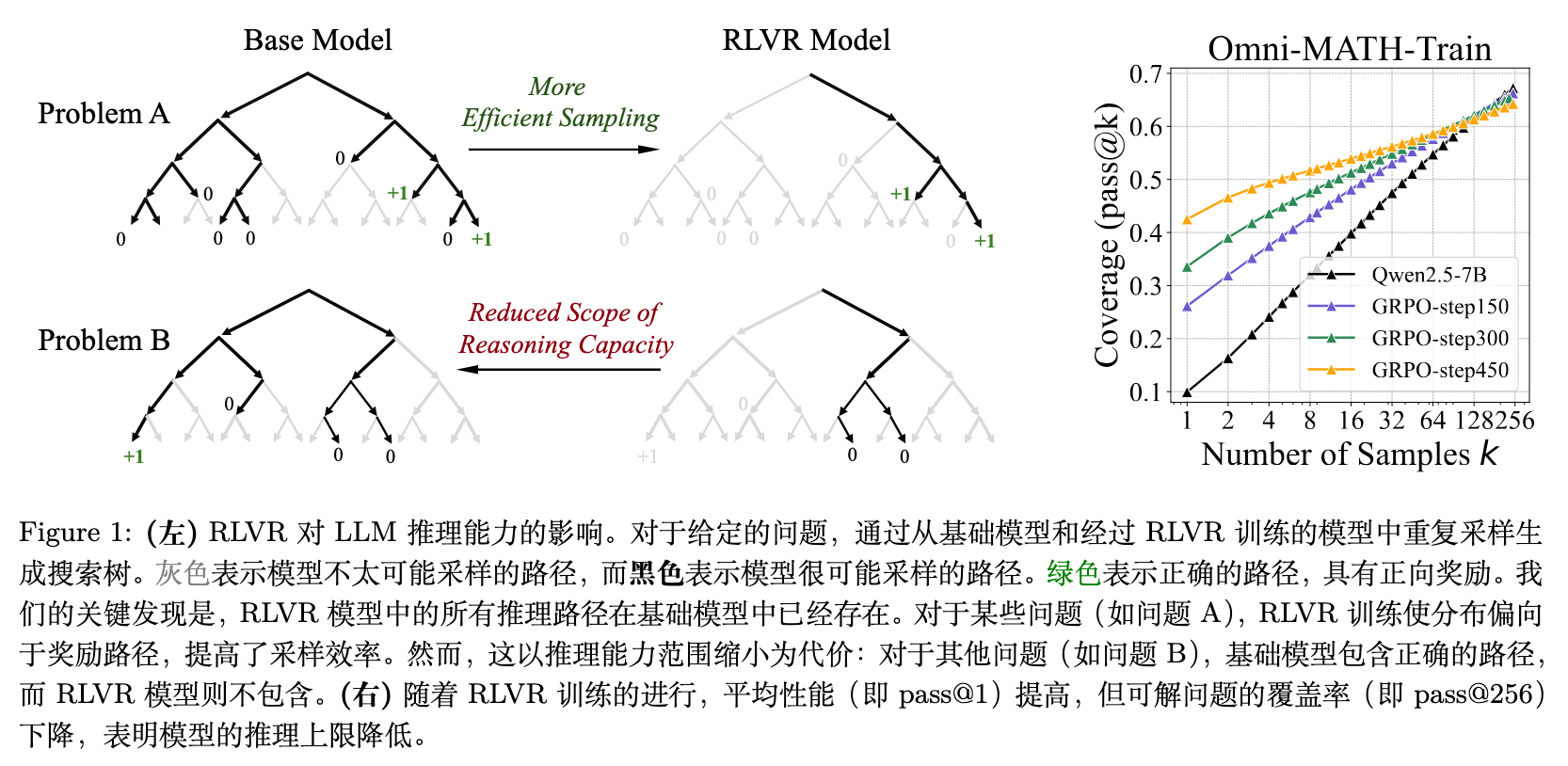

上图直观地展示了论文的核心观点。对于问题 A,基础模型(Base Model)的采样空间中包含了正确的推理路径,但这些路径可能概率较低,采样效率不高。RLVR 模型通过训练,提高了正确路径的采样概率,实现了更高效的采样(More Efficient Sampling)。然而,对于问题 B,基础模型中原本存在正确的解法,但经过 RLVR 训练后,模型的推理能力范围收缩(Reduced Scope of Reasoning Capacity),反而失去了解决该问题的能力。右侧的 pass@k 曲线图更具体地显示了这一趋势:随着训练的进行(GRPO-step150 到 step450),模型的平均性能(pass@1)在提升,但其能力覆盖范围(pass@256)却在下降。

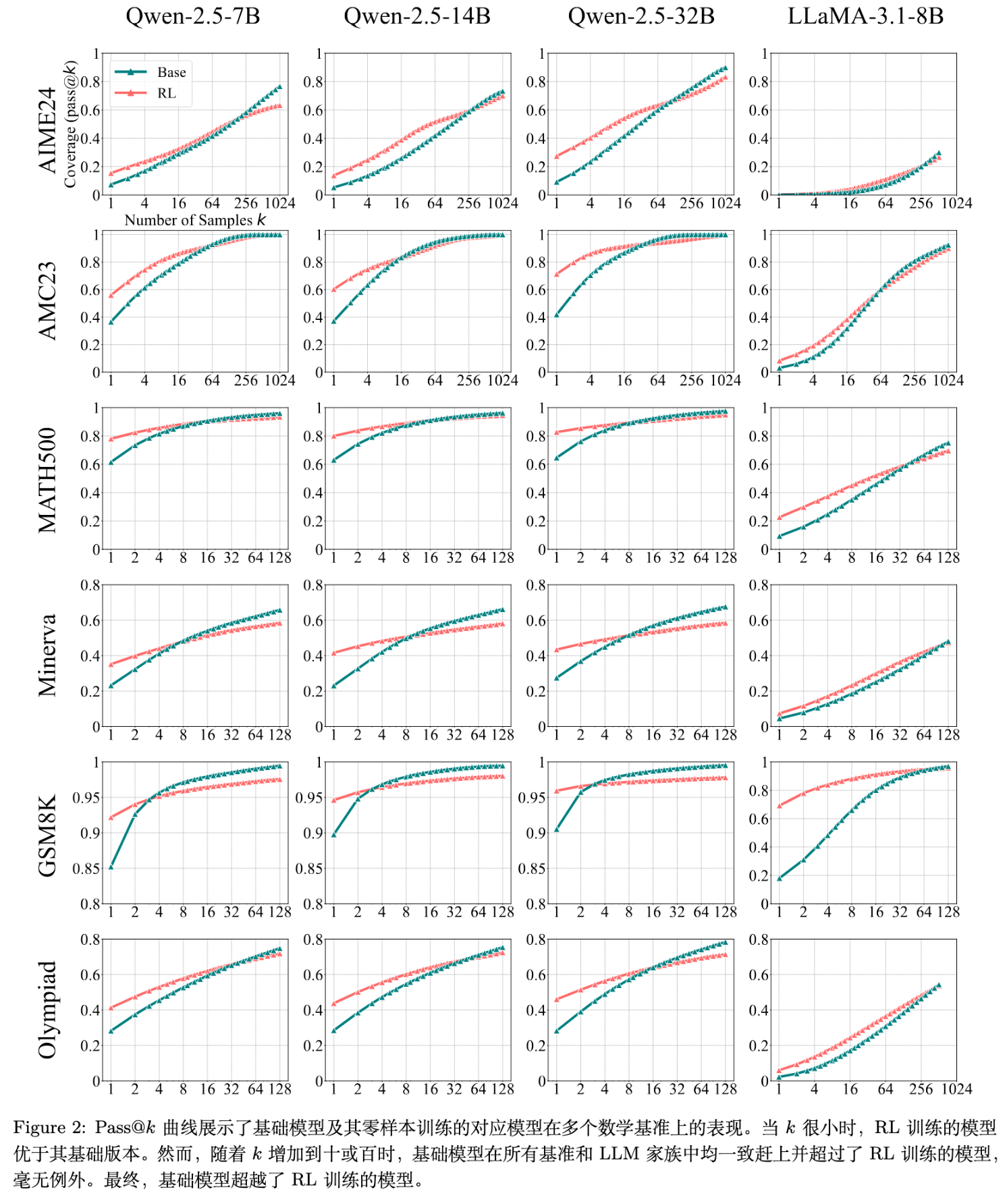

2.1 pass@k 曲线的反转

实验中最引人注目的发现来自于对 pass@k 曲线的分析。作者在多个数学基准测试(如 AIME24, MATH500, Minerva, Olympiad)上,对比了不同尺寸的 Qwen2.5 和 LLaMA-3.1-8B 基础模型及其经过 RLVR(使用 SimpleRLZoo 框架的 GRPO 算法)训练后的版本。

从图中可以清晰地观察到一个一致的模式:

-

当 k很小时(例如k=1):红色的 RL 模型曲线位于蓝色的基础模型曲线之上。这符合我们的普遍认知,即 RLVR 提升了模型的平均性能。pass@1相当于评估模型在一次尝试下的准确率,RL 模型的表现更好。 -

当 k增大时:蓝色的基础模型曲线以一个更陡峭的斜率持续上升,并最终在k值达到几十或几百时,与 RL 模型的曲线相交,并反超后者。

这个反转现象传递了一个关键信息:基础模型能够解决的问题集合,实际上比 RLVR 模型更广。 以 Minerva 基准测试中的 32B 模型为例,当 k=128 时,基础模型的 pass@128 比 RL 模型高出约 9%。这意味着,在验证集中,有 9% 的问题是基础模型可以通过大量采样解决,而 RL 模型却几乎无法解决的。

RLVR 带来的“性能提升”更像是一种“效率提升”。它让模型对于那些“本来就会”的问题,能够更快、更稳定地给出正确答案。但这种优化的代价是牺牲了多样性和探索性,导致模型解决问题的“广度”变窄了。

2.2 在代码生成和视觉推理任务中的一致性

为了验证这一发现的普适性,作者还将分析扩展到了代码生成和视觉推理领域。

-

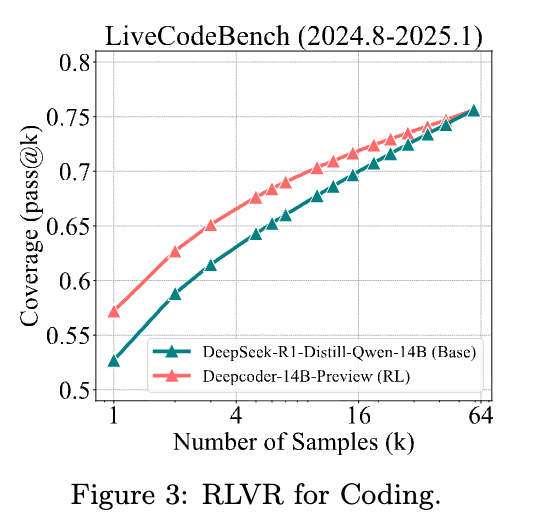

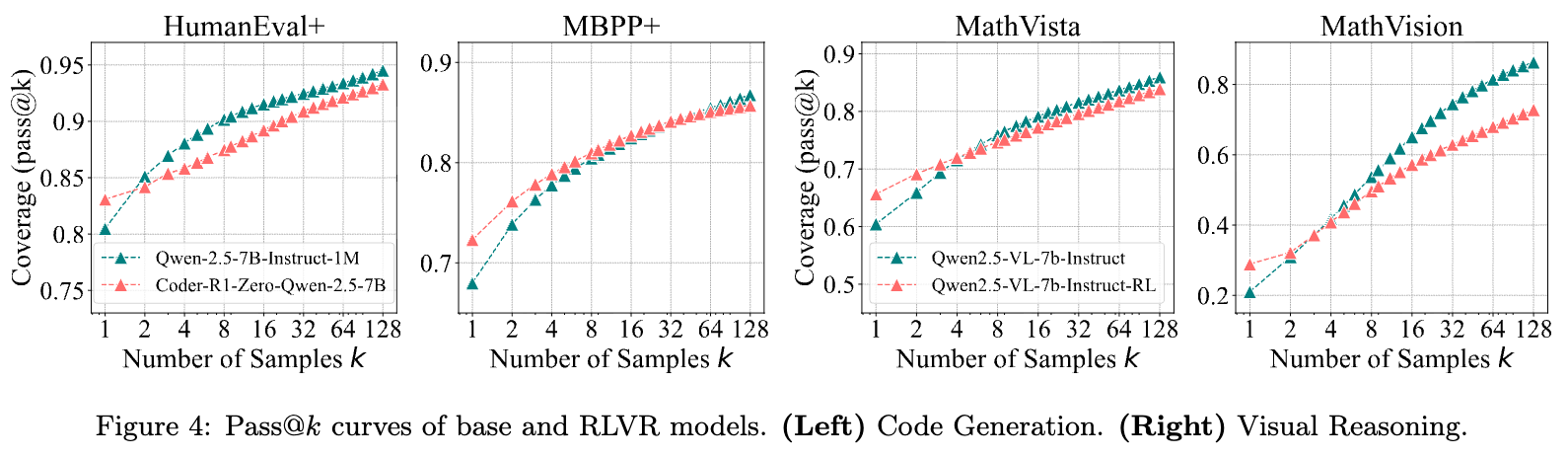

代码生成:作者评估了 CodeR1-Zero-Qwen2.5-7B 模型在 LiveCodeBench、HumanEval+ 和 MBPP+ 上的表现。与数学任务类似,

pass@k在代码生成任务中是一个可靠的指标,因为通过单元测试可以准确判断代码的正确性,几乎不存在“猜对”的可能。

实验结果(如图 3 和图 4 左侧)再次复现了数学任务中的趋势。无论是 CodeR1 还是更强大的 DeepCoder-14B,其

pass@k曲线都在k值增大后被对应的基础模型(或微调前的模型)所超越。这表明 RLVR 在代码领域的作用机制与在数学领域高度一致。 -

视觉推理:作者使用 EasyR1 框架在一个视觉数学任务(Geometry3K)上训练了 Qwen2.5-VL-7B 模型,并在 MathVista 和 MathVision 数据集上进行评估。如图 4 右侧所示,视觉推理任务的结果同样呈现出

pass@k曲线的反转现象。这进一步说明,RLVR 对推理能力边界的影响是跨模态的。

综上所述,横跨数学、代码、视觉三大推理领域的实验证据共同表明,当前 RLVR 方法并不能扩展模型的推理能力边界。相反,它通过优化采样分布,在提升“平均表现”的同时,压缩了模型的潜在能力空间。

3. 为何 RLVR 未能带来新的推理能力?

为了解释上述实验现象,论文从多个角度进行了深入的分析,旨在揭示 RLVR 训练的内在作用机制。

3.1 推理路径

RLVR 模型的推理能力是否真的受限于基础模型?作者通过一系列分析,证实了这一点。

-

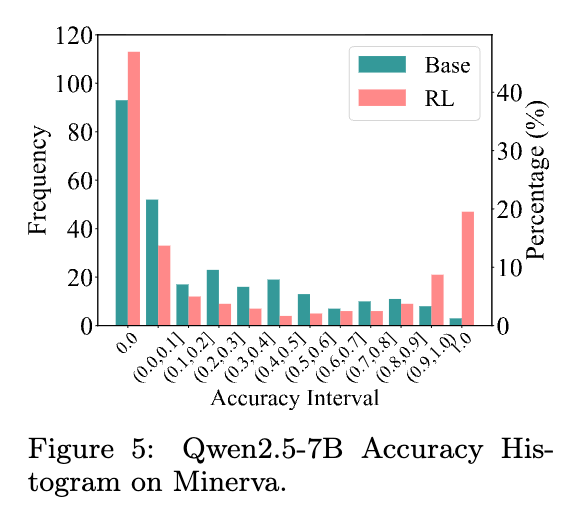

准确率分布分析:通过分析模型在数据集上各个问题上的准确率(通过多次采样计算)分布,作者发现 RLVR 训练显著改变了这种分布。

如图所示,与基础模型(Base)相比,RLVR 模型(RL)在高准确率区间(如 0.9-1.0)的频率显著增加,而在低准确率区间的频率降低。这解释了为什么 RL 模型的

pass@1更高。然而,一个值得注意的细节是,在准确率为 0 的位置,RL 模型的频率也增加了。这意味着,经过 RLVR 训练后,有更多的问题变成了“完全无法解决”的问题。RLVR 的作用像是将概率分布“锐化”了:将原本低概率能做对的题,变得高概率做对;但也将一些更低概率做对的题,直接变成了零概率。这正是导致其推理覆盖范围收缩的直接原因。 -

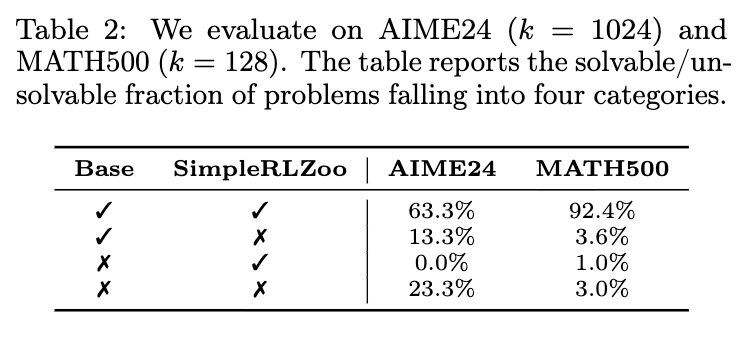

可解问题集合覆盖分析:为了更直观地验证上述猜想,作者直接比较了基础模型和 RL 模型能够解决的问题集合。

AIME24 和 MATH500 上的可解问题覆盖分析 上表将问题分为四类:(1) 两者都能解 (✓, ✓);(2) 只有基础模型能解 (✓, ✗);(3) 只有 RL 模型能解 (✗, ✓);(4) 两者都不能解 (✗, ✗)。数据显示,在 AIME24 上,有 13.3% 的问题属于“只有基础模型能解”的类型,而属于“只有 RL 模型能解”的比例是 0.0%。在 MATH500 上,这一比例分别为 3.6% 和 1.0%。这清晰地表明,RL 模型能解决的问题集合,几乎是基础模型能解决的问题集合的一个子集。RLVR 很少能让模型学会解决一个全新的问题。

-

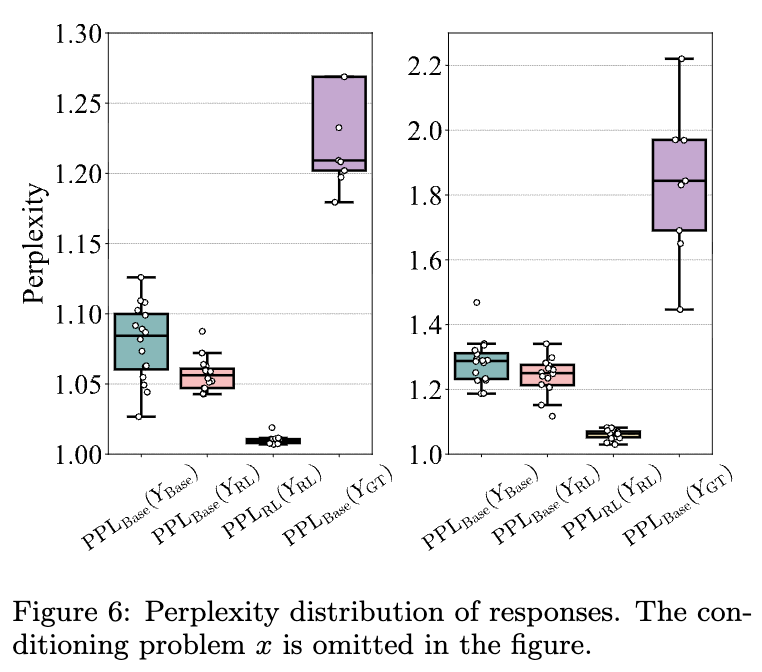

困惑度(Perplexity)分析:这个发现引出了一个更深层次的问题:RL 模型所使用的那些正确的推理路径,是否是训练中新产生的?还是说它们原本就存在于基础模型的“知识库”中?为了回答这个问题,作者引入了困惑度分析。困惑度可以衡量一个模型对于一个给定文本序列的“惊讶”程度。如果模型 A 对模型 B 生成的文本感到不惊讶(即困惑度低),则说明 B 生成的文本很符合 A 的语言模式。

作者让基础模型(

Base)、RL 模型(RL)以及更强大的 OpenAI-o1(GT,作为高质量参考)分别生成一系列解题答案(分别记为Y_base,Y_RL,Y_GT)。然后,他们计算了基础模型对这些不同来源答案的困惑度,即PPL_Base(Y_RL),PPL_Base(Y_base),PPL_Base(Y_GT)。

不同响应的困惑度分布 结果显示,

PPL_Base(Y_RL)的分布与PPL_Base(Y_base)分布中较低的部分高度重合。这意味着,RL 模型生成的答案,在基础模型看来,是非常“自然”、非常“合理”的,是基础模型自己本来就倾向于生成的那些回答。进一步的分析还发现,随着 RL 训练的进行,PPL_Base(Y_RL)还在持续下降。这个证据链条最终指向了一个结论:RLVR 并没有在广阔的语言空间中探索出新的、有效的推理路径。它所做的,是在基础模型已有的、庞大的采样空间中,识别出那些能够通往正确答案的路径,然后通过强化学习,极大地提高了这些路径被采样到的概率。整个过程是一场“存量博弈”,而非“增量创造”。

3.2 RLVR 与蒸馏的区别

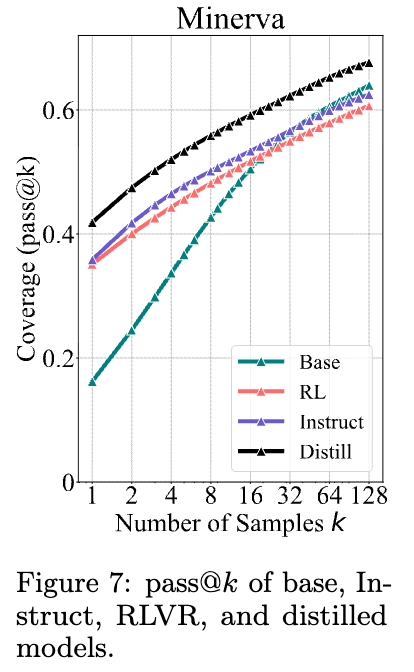

为了凸显 RLVR 的局限性,论文引入了另一个常见的提升模型能力的技术——知识蒸馏——作为对比。在蒸馏中,一个较小的学生模型通过学习一个更强大的教师模型的输出来进行训练。

作者使用了一个通过蒸馏 DeepSeek-R1(教师)得到的模型 DeepSeek-R1-Distill-Qwen-7B(学生),并将其与基础模型 Qwen2.5-Math-7B 以及在该基础上进行 RLVR 训练的模型进行了比较。

如图 7 所示,蒸馏模型(Distill)的 pass@k 曲线在所有 k 值下都显著高于基础模型(Base)和 RLVR 模型(RL)。这表明,与 RLVR 不同,蒸馏能够真正地从教师模型那里学到新的知识和推理模式,从而突破了原始基础模型的能力边界。 这从侧面印证了 RLVR 的能力受限于其“先验”(即基础模型),而蒸馏则通过引入一个更优的“先验”(教师模型)来实现了能力的扩展。

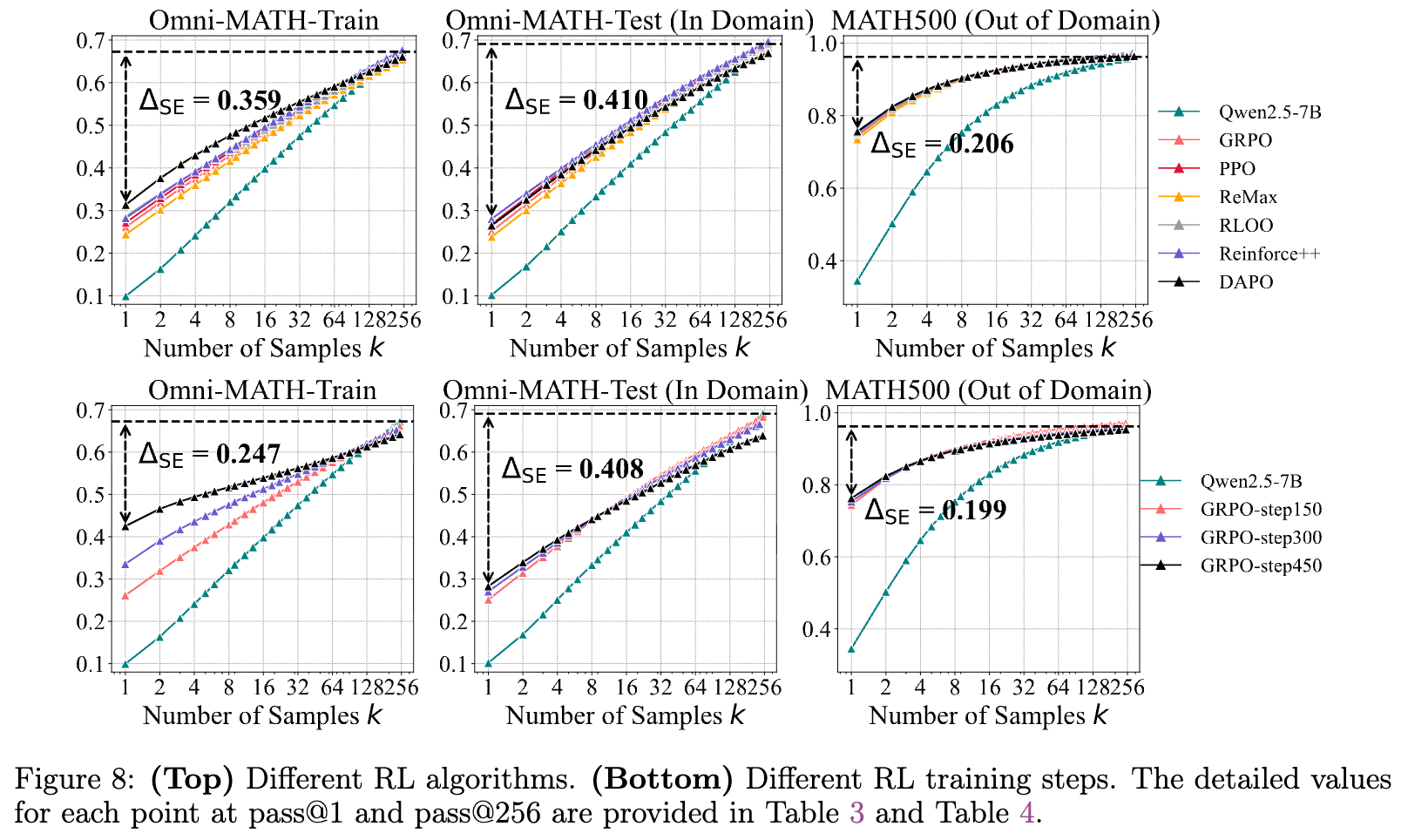

3.3 不同 RL 算法的殊途同归

既然 RLVR 的主要作用是提升采样效率,那么不同的 RL 算法在提升效率方面表现如何?它们是否已经做到了极致?

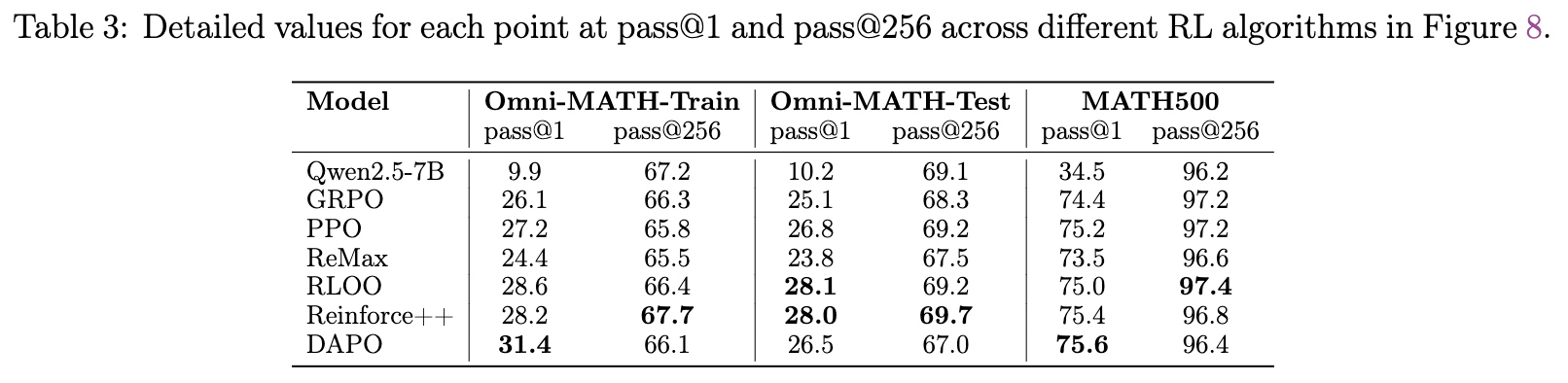

为了公平地比较不同算法,作者在一个统一的框架(VeRL)下重新实现了多种流行的 RL 算法,包括 PPO, GRPO, Reinforce++, RLOO, ReMax 和 DAPO。他们定义了一个新的评估指标——采样效率差距(Sampling Efficiency Gap, ∆SE):

这个指标衡量了 RL 模型的单次采样性能(pass@1)与基础模型的潜力上限(用 pass@256 近似)之间的差距。∆SE 越小,说明 RL 算法在挖掘和利用基础模型潜力方面的效率越高。

实验结果(如图 8 上半部分)显示:

-

不同的 RL 算法在 pass@1和pass@256上的表现略有差异,但总体趋势非常相似。 -

它们的 ∆SE值也相差无几,例如在 Omni-MATH 的在领域测试集上,∆SE值都稳定在 40 多个百分点。

这表明,当前主流的 RLVR 算法在提升采样效率方面,能力水平相当,并且都远未达到理想状态。基础模型中仍有巨大的潜力(pass@256 远高于 pass@1)未被有效利用。这或许暗示了,仅仅在现有算法上进行微调可能收效甚微,我们需要全新的 RL 范式来更有效地缩小这一差距。

此外,作者还分析了训练步数的影响(如图 8 下半部分)。随着训练的进行,pass@1 持续提升,但 pass@256 却在持续下降,这再次验证了 RLVR 训练会窄化推理边界。

4. 讨论

论文的发现引发了一个深刻的问题:为什么在传统领域大放异彩的强化学习,在应用于 LLM 推理时,会表现出如此的局限性?论文的作者在讨论部分给出了两个关键的解释。

4.1 传统 RL 与 LLM RLVR 的根本差异

-

动作空间的维度灾难:传统 RL 环境(如围棋)的动作空间虽然大,但仍然是离散且有限的。而 LLM 的动作空间是整个词汇表在每个时间步的组合,这是一个指数级增长的、极其庞大和稀疏的空间。传统的 RL 算法并非为应对如此浩瀚的动作空间而设计。如果从零开始训练,智能体几乎不可能通过随机探索获得任何有效的正向奖励。

-

预训练先验(Pretrained Prior)的引入:正因为从零开始探索不可行,LLM 的 RLVR 必须从一个已经经过大规模预训练的基础模型开始。这个基础模型提供了一个强大的“先验”,极大地约束了模型的行为,使其生成的大部分内容都是有意义的、符合语法和逻辑的文本。这个先验使得探索过程变得可行,模型能够相对容易地采样到可以获得奖励的序列。

4.2 预训练先验是一把“双刃剑”

这个为 RLVR 提供了起点的预训练先验,也正是其能力的“天花板”。

-

探索的困境:由于采样过程被基础模型的先验所引导,模型很难跳出这个先验去探索全新的、迥异的推理模式。任何偏离先验太远的采样,大概率会生成无意义的、混乱的文本,从而获得负奖励。

-

策略梯度算法的本质:目前主流的 RLVR 算法(如 PPO)都属于策略梯度(Policy Gradient)类。这类算法的目标函数本质上是最大化获得正奖励的序列的对数似然,同时最小化获得负奖励的序列的对数似然。在一个由强大先验主导的探索空间里,这意味着算法会不断强化那些“在先验内部”且“能得到奖励”的路径,同时抑制所有其他路径。

因此,RLVR 的训练过程,不可避免地变成了一个在基础模型划定的圈子内进行优化的过程。它会不断地“提纯”和“固化”基础模型中已有的成功模式,但却缺乏有效的机制去发现圈子之外的全新世界。从这个角度看,RLVR 训练就像是在一座巨大的宝山(基础模型)中,学习如何更高效地找到已知的宝藏,而不是去发现新的矿脉。

4.3 未来的方向

这一发现并不意味着 RLVR 毫无价值。对于追求在特定任务上获得更高“平均性能”的实际应用来说,RLVR 仍然是一种有效的技术。

未来的研究可能需要从以下几个方面寻求突破:

-

更高效的探索策略:如何在 LLM 庞大的动作空间中进行有效的探索,是打破先验束缚的关键。这可能需要借鉴更前沿的探索算法,或者设计全新的、针对语言特性的探索机制。 -

多轮交互范式:当前的 RLVR 框架大多是“单轮”的:模型生成一个完整的解题过程,然后得到一个最终的奖励。这种模式缺乏中间反馈和修正的机会。一个更像人类学习过程的多轮、交互式的 RL 代理范式,或许能让模型在与环境(例如,一个代码编译器、一个数学符号系统)的持续互动中获得更丰富的经验,从而学习到新的知识。这也就是论文作者所引述的,一个正在开启的“经验的时代”(era of experience)。

5. 总结

这篇论文通过系统、严谨的实验和深入的分析,对当前流行的 RLVR 技术提出了一个重要的修正性观点。

对于广大的大模型作者而言,这篇论文的核心启示在于:

-

重新评估 RLVR 的作用:我们应该将 RLVR 主要看作一种提升采样效率和稳定性的优化技术,而不是一种获取新知识和新能力的学习机制。在评估 RLVR 模型的性能时,除了

pass@1,也应该关注pass@k在更大k值下的表现,以全面了解其对模型能力边界的影响。 -

重新认识基础模型的价值:这篇论文揭示了基础模型本身所蕴含的巨大潜力。基础模型不是一个需要被 RL “超越”的起点,而是一个有待被充分挖掘的、蕴含着广泛推理能力的“知识库”。未来的工作重点之一,或许应该是如何设计出比当前 RLVR 更有效的方法,来解锁和利用这些深藏在基础模型中的潜能。

-

对“自我提升”保持审慎:RLVR 常被与“模型自我提升”或“持续学习”等概念联系在一起。这篇论文的研究结果提醒我们,在当前的框架下,这种“自我提升”可能是有边界的,其边界就是基础模型本身。要实现真正的、无边界的自我演进,可能需要对现有的强化学习范式进行更根本性的革新。

总而言之,这项工作并没有否定 RLVR 的工程价值,但它深刻地揭示了其在“激励新能力”方面的科学局限性。它鼓励我们从对现有技术的乐观应用,转向对其背后机制的审慎思考。

往期文章: