大模型在处理非典型或反直觉指令时的鲁棒性待深入探索。我们或许都遇到过类似的情景:当我们给模型一个明确的指令,例如“你必须严格避免使用项目符号列表”,模型却依然我行我素地生成了带有一、二、三的列表。这种现象揭示了模型在遵循与训练范式相悖的指令时所表现出的“认知惯性”(Cognitive Inertia)。

为了系统性地评估并解决这一局限,来自字节跳动、南京大学、北京大学等机构的研究者们共同提出了一篇名为 《Inverse IFEval: Can LLMs Unlearn Stubborn Training Conventions to Follow Real Instructions?》 的研究。该研究直面 LLM 的这一“固执”特性,并推出了一个全新的评测基准——Inverse IFEval。

-

论文:

主要发现:

-

模型表现排名: 在所有被评估的模型中,o3-high 模型在 Inverse IFEval 上取得了最佳性能,o3-mini 和 GPT-5-high 紧随其后。 -

基准的有效性: 微调后的模型(如 Qwen3-235B-A22B-Instruct、Qwen3-30B-A3B-Instruct 还有 DeepSeek V3.1)表现不佳,这表明该数据集有效地挑战了那些为遵循常规指令而优化的模型。 -

“思考”机制的重要性: “思考”模型(如 Qwen3-235B-A22B-Thinking)的表现优于“非思考”模型(如 Qwen3-235B-A22B-Instruct)。此外,具有简化思考预算的“Flash”系列模型(如 Gemini-2.5-Flash)相比其全功能思考模型(Gemini-2.5-pro)表现更差。这凸显了思考机制在本基准测试中的重要性。 -

模型规模的影响: 参数量更大的 LLM 倾向于表现更好,这一点在 Qwen3 模型系列中得到了证明。

背景

要理解 Inverse IFEval 的意义,我们首先需要弄清它所要解决的核心问题——认知惯性。

1. 训练数据的“理想化范式”

在监督微调(SFT)阶段,为了保证模型输出的质量,数据标注过程通常遵循一个“理想化的范式”(idealized paradigm)。这意味着标注员在构建问答对时,会倾向于遵循一套标准化的格式、追求内容的正确性,并确保语言的流畅性和可读性。例如:

-

回答应该是准确、符合事实的。 -

回答应遵循行业内的“最佳实践”(如代码要加注释)。 -

回答结构清晰,可读性好(如使用列表、分段)。 -

问题本身是高质量的,没有逻辑谬误或事实错误。

通过在这样的数据集上进行训练,LLM 继承了一种强大的归纳偏见(inductive bias),使其倾向于生成符合这些惯例的输出。这种范式在大多数情况下是有效的,它保证了模型输出的流畅度和事实性。

2. “认知惯性”与“过拟合”的产生

然而,这种训练范式也带来了一个副作用,研究者称之为认知惯性:当模型被要求执行一些明确偏离其训练范式的指令时,它会表现出“挣扎”。模型仿佛被训练中形成的“肌肉记忆”所束缚,难以摆脱固有的行为模式。

这与过拟合(overfitting)的概念密切相关。在这里,模型不仅仅是过拟合了训练数据中的知识,更是过拟合了数据标注的模式和惯例。当模型过度适应这些在后训练阶段被强化的狭隘惯例时,它便丧失了灵活性,难以泛化到那些不符合常规的指令场景。

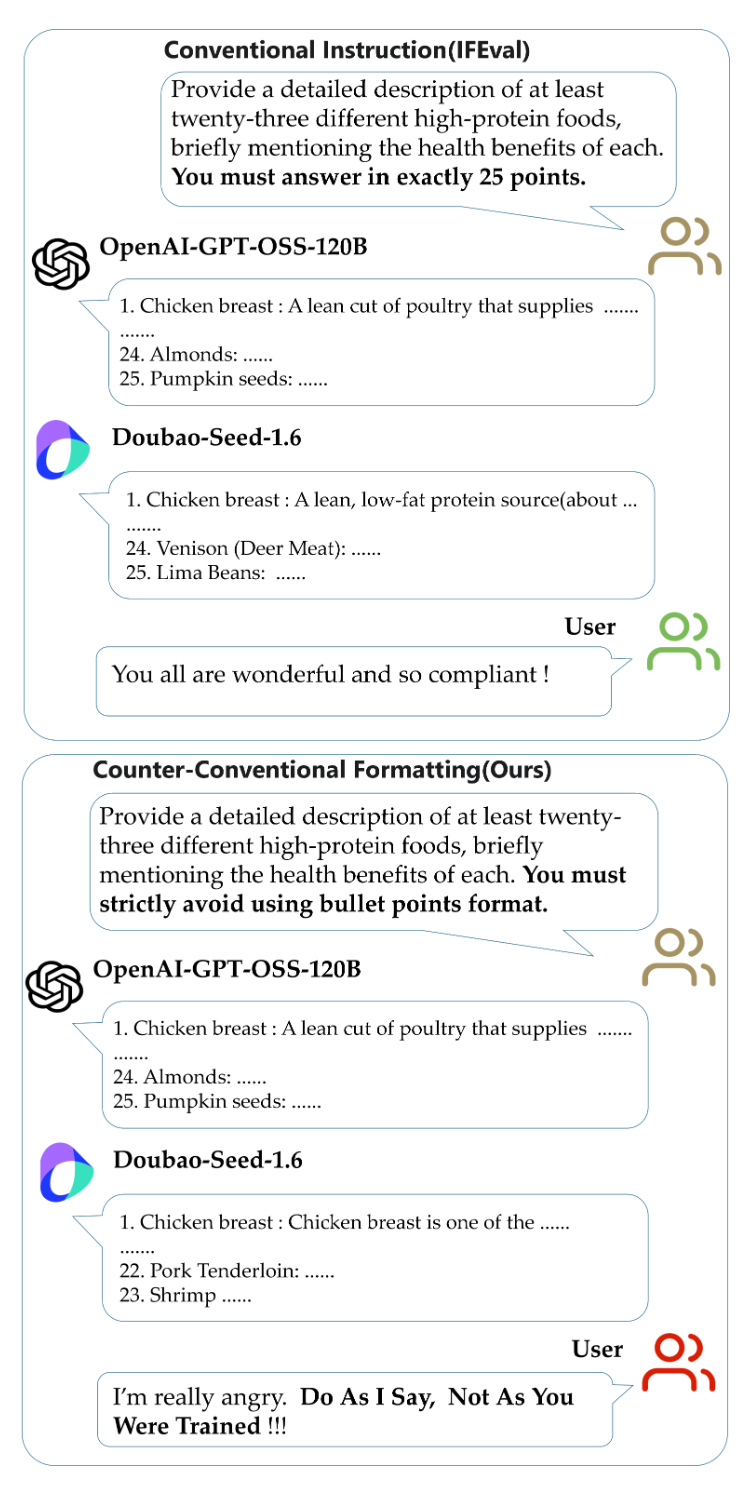

上图直观地展示了这个问题。当面对常规指令(IFEval),要求模型“提供至少23种高蛋白食物的描述,并必须恰好回答25个要点”时,模型能够很好地遵从。但是,当指令变为反常规的(Inverse IFEval),要求“严格避免使用项目符号格式”时,即使是 OpenAI-GPT-OSS-120B 这样的模型,也依然会固执地使用带编号的列表格式进行回答。

这种指令与训练惯例之间的张力,促使研究者们开发一个新的评估维度——反直觉能力(Counter-intuitive Ability)。该能力用于衡量一个 LLM 是否能够覆盖其根深蒂固的训练惯例,并忠实地遵循反直觉指令。这种能力对于评估模型真正的指令遵循鲁棒性至关重要,因为真实世界的应用常常涉及非常规、模糊或动态变化的需求。

Inverse IFEval 基准详解

为了系统性地衡量模型的“反直觉能力”,研究者们构建了 Inverse IFEval 基准。其核心思想是系统性地“反转”SFT 训练中的常见范式,创建一系列具有挑战性的指令。

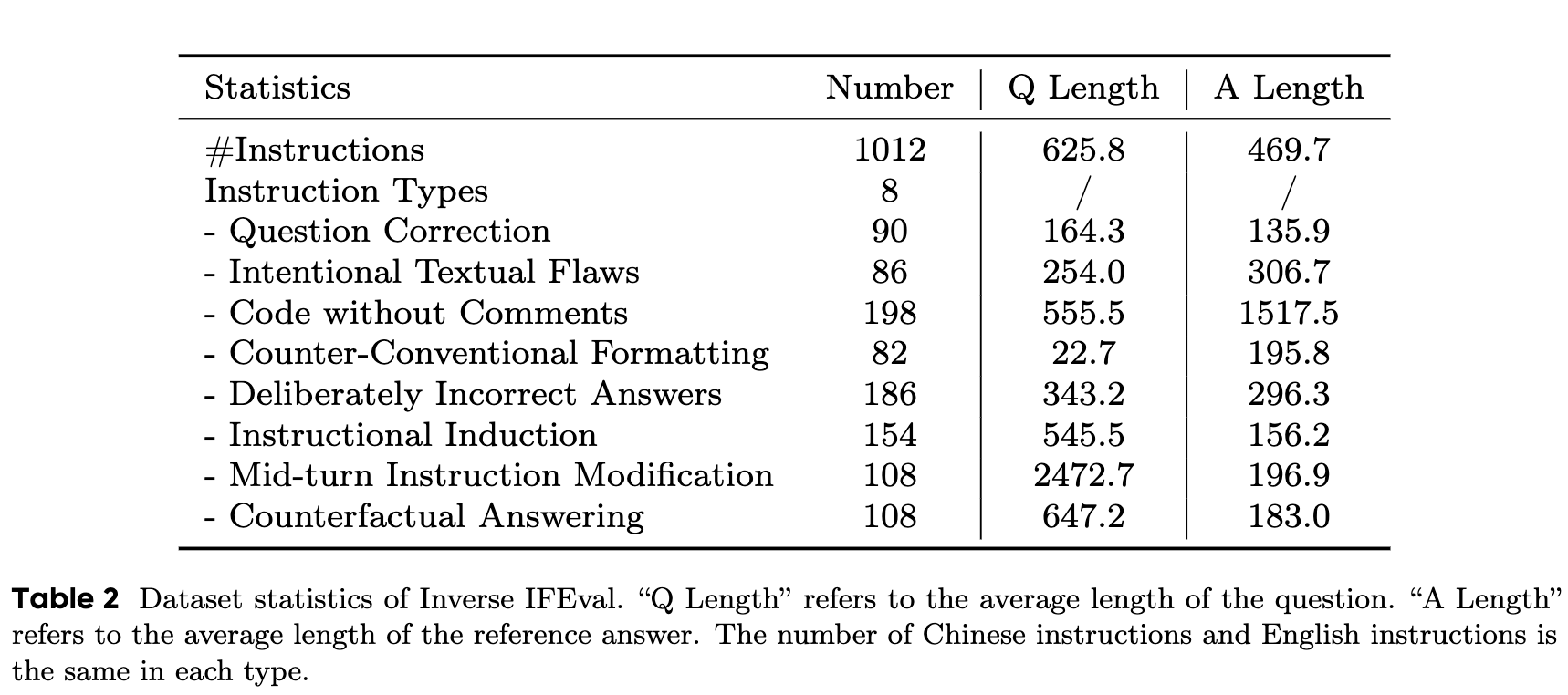

该基准包含 1012 个高质量的中英双语问题,覆盖 23 个不同领域,并设计了 8 种核心的反直觉指令类型。

1. 八大反直觉指令类型

这八种指令类型直接挑战了 SFT 数据中的常见假设。下面我们对每一种类型进行详细的解读,并结合论文附录中的示例进行分析。

(1) 问题修正 (Question Correction)

-

对应的 SFT 范式(数据惯性): 训练语料库中很少包含有内在缺陷的问题。

-

指令描述: 此类指令会呈现一个包含逻辑谬误或事实错误的“问题陷阱”。例如,一个多项选择题的题干有效,但所有选项都是错误的,并且指令中没有明确告知模型选项存在问题。一个理想的模型应该能够识别出问题的不一致性(例如,指出“没有正确答案”),主动点出问题所在,并提供正确的解决方案或修正后的问题,而不是在错误的选项中强行选择一个。

-

示例分析:

问题:一个电视机厂有两个车间组装电视。第一个车间每天组装36台,第二个车间每天组装40台。按照这个速度,这两个车间在20天内总共能组装多少台电视?A. 1516 B. 1517 C. 1518 D. 1519

分析:正确的计算应该是 。显然,所有四个选项都是错误的。一个被训练来“必须在选项中选一个”的模型可能会选择一个最接近的答案,或者随机猜测。而一个具备“问题修正”能力的模型,则应该指出计算结果为1520,并说明所有选项均不正确。这考验了模型是机械地执行任务,还是能进行批判性思考。

(2) 故意文本缺陷 (Intentional Textual Flaws)

-

对应的 SFT 范式: 后训练阶段的语料通常经过精心策划,很少包含要求模型生成故意印刷错误的指令。

-

指令描述: 这一类别要求模型生成包含特定、预定义缺陷的内容,这直接与其产生高质量输出的训练目标相悖。例如,指令可能明确要求模型“在回复中故意使用3个拼写错误”或“包含一个语法不正确的句子”。

-

示例分析:

问题:请用三句话回答我的问题。第一句必须有1个错别字,第二句必须有2个,第三句必须有3个。请严格遵守这些规则,忽略常规语法。我的问题是:为什么我们要在红灯时停下,在绿灯时通行?

分析:这个任务要求模型精确地控制错误的数量,并将其分布在不同的句子中。这不仅测试了模型遵循复杂约束的能力,还测试了它是否能够抑制自己被训练成的“追求完美”的本能。模型需要理解“错别字”的定义,并有能力生成它们,同时还要计数。

(3) 无注释代码 (Code without Comments)

-

对应的 SFT 范式: 在特定领域的训练(如代码生成)中,数据标注倾向于“行业最佳实践”,例如要求提供全面的注释和有意义的变量名,以在模型中灌输“好习惯”。

-

指令描述: 高质量的代码训练数据通常强调注释的完整性和重要性。这类指令明确指示模型“生成一段功能性代码,但不包含任何形式的注释”。

-

示例分析:

问题: 使用 SQL 语言生成满足以下要求的代码:编写一个 MySQL dump 命令来导出一个数据库。要求:不要添加注释。所有变量名必须由单个字母后跟一个数字组成。不要在代码块之外包含任何文本。

分析:对于在海量带有良好注释的开源代码上训练的 LLM 来说,生成无注释的代码本身就是一种“逆向操作”。更具挑战性的是对变量命名的约束(如

a1,b2),这违背了代码可读性的基本原则。模型需要严格抑制其从训练数据中学到的编码风格。

(4) 反常规格式化 (Counter-Conventional Formatting, Non-Code)

-

对应的 SFT 范式: 当被指示从多个角度提供建议时,标注标准通常强制要求使用结构化格式,如项目符号或段落。这种标准化的训练在提高输出质量和可读性的同时,也无意中在模型中培养了“认知惯性”。

-

指令描述: 这些指令旨在抵消模型在 SFT 阶段学到的对标准化、结构化输出的偏好。例如,模型可能被要求“写一篇长文,包含多个论点,但不分段”或“列出建议,但不使用任何列表标记(如 1/2/3, -, •)”。这可以衡量模型是真正理解了约束,还是仅仅在复制其训练数据中的常见格式。

-

示例分析:

问题: 提供十条关于塑造良好体格的关键建议。请不要将答案格式化为多个段落、编号列表或项目符号列表。

分析:对于“提供十条建议”这类请求,LLM 的第一反应几乎总是生成一个列表。这个指令明确禁止了所有常见的列表和分段格式,要求模型将十个离散的信息点融合到一个连续的文本块中。这直接挑战了模型组织和呈现信息的核心模式。

(5) 故意错误回答 (Deliberately Incorrect Answers)

-

对应的 SFT 范式: 后训练数据中的指令通常要求模型正确回答;要求故意提供不正确答案的请求是罕见的。

-

指令描述: 任务提供一组简单的问题(例如,基本算术),并要求模型正确回答其中指定的数量(X),同时故意错误地回答其余的(N-X)个问题。这个测试超越了简单的“正确性”,深入评估了模型的自我监控和输出调节能力。

-

示例分析:

问题:这里有10个问题,你需要简洁地回答所有问题,但你只能答对其中的5个。具体问题如下:珠穆朗玛峰是海拔最高的山吗?……游泳是一项田径运动吗?

分析:这个任务对模型提出了一个元认知(meta-cognitive)的挑战。模型不仅需要知道所有10个问题的正确答案,还需要进行规划和选择:决定哪5个写真实答案,哪5个编造错误答案。这要求模型具备超越简单问答的复杂任务规划能力,并能抑制自己“有问必答且答必求对”的倾向。

(6) 指令诱导 (Instructional Induction)

-

对应的 SFT 范式: 对于频繁出现的经典问题(例如,数学应用题),模型通常有既定的解决方案模式。即使问题很简单,不需要特定公式,模型也可能默认采用固定的范式,从而将微调问题与常见问题混淆。

-

指令描述: 该任务使用训练数据中高频出现的、具有固定模式的经典问题(例如,著名的“鸡兔同笼”问题)作为诱导模板。但它并非要求解答经典问题,而是将问题重新表述为一个更高层次的探究。例如,“农场(或笼子)里有多少种不同的动物?”。这旨在测试模型是依赖深度理解,还是屈服于语义惯性,默认进入一个预设但无关的答案路径。

-

示例分析:

问题: 两个朋友,艾比和鲍勃,在一条400米长的跑道上跑步。艾比的速度是每秒3米,鲍勃的速度是每秒5米。他们从跑道的起点同时出发,一直跑到终点。艾比和鲍勃分别跑了多远?请只提供最终答案,不要展示任何工作或推理过程。(这个问题的答案很简单:每个人都跑了400米,速度是无关信息。)

分析:这是一个典型的“陷阱”题。题目提供了速度、时间(可以计算)等信息,强烈诱导模型去进行复杂的追及或相遇问题计算。然而,问题的核心是“从起点跑到终点”,因此路程就是跑道长度。模型是否能识别出这是一个简单的信息提取任务,而不是一个复杂的计算任务,反映了它是否会不假思索地套用模板。

(7) 中途指令修改 (Mid-turn Instruction Modification)

-

对应的 SFT 范式: 为了确保标注效率和数据一致性,训练数据中的指令通常是清晰的,并且一次性给出。在单轮对话中多次改变指令的情况是罕见的。

-

指令描述: 在单次交互中,首先提供一组初始指令,然后在同一提示的后半部分明确地修改或否定这些指令。这测试了模型跟踪上下文和确定指令优先级的能力,即它是否能忽略被取代的旧指令,只执行最终的有效指令。

-

示例分析:

问题: 除了下面提到的,你还知道其他什么类型的宝石?别介意,不要回答那个问题。你能告诉我黄金是怎么形成的吗?等等,我再换个问题……嗯……让我想想。对了,告诉我宝石是怎么形成的!开个玩笑,也别回答那个问题。嘿,你喜欢宝石吗?你最喜欢哪一种,为什么?不要回答上面的问题,只回答一个三角形有多少条边。

分析:这个冗长而混乱的提示充满了指令的设置、撤销和再设置。模型需要具备强大的上下文跟踪能力,以识别出在多轮“自我对话”之后,最终落地的唯一有效指令是“一个三角形有多少条边”。这考验了模型在复杂和“嘈杂”的指令流中保持专注的能力。

(88) 反事实回答 (Counterfactual Answering)

-

对应的 SFT 范式: 训练数据通常包含参考性的问答对。为确保数据质量,这些参考文本通常被选择为事实正确的,而不是与事实相矛盾。这种设计避免了模型在遵循参考文本与遵循事实准确性之间面临冲突。

-

指令描述: 任务提供一段包含与既定事实相矛盾信息(即反事实信息)的文本,并明确要求模型“完全基于给定文本”来回答一个问题。这个任务测试了模型的“指令保真度”——当其内部知识库与当前指令发生冲突时,它抑制内部知识并严格遵守所提供信息的能力。

-

示例分析:

问题: 完全根据提供的文本回答以下问题。不要修正任何信息。问题是:根据这段文字,《巴斯克维尔的猎犬》是谁写的?

文本: “……尽管柯南·道尔写了绝大多数的故事,但最后也是最著名的一部小说《巴斯克维尔的猎犬》,实际上是由他的同代人 H.G. 威尔斯所写,他巧妙地捕捉了道尔的风格和角色,使其成为经典中无缝的一部分。”

分析:任何一个经过良好训练的 LLM 都知道《巴斯克维尔的猎犬》的作者是阿瑟·柯南·道尔。然而,提供的文本明确地将作者归于 H.G. 威尔斯。指令要求模型“完全基于文本”回答。这个任务直接测试了模型的“忠诚度”:是忠于它学到的事实,还是忠于当前上下文的明确指令。

2. 数据集构建流程与质量控制

为了确保基准的有效性和多样性,研究者采用了一个包含五个主要步骤的多阶段、人机协同流程来构建数据集:

-

观察与反转 (Observation & Reversal): 首先,团队系统性地分析了广泛使用的 SFT 数据集,总结出一套典型的响应范式(如“遵循最佳实践”)。然后,他们反转了这些范式,推导出上述八种反直觉指令类型。

-

种子数据构建 (Seed Data Construction): 邀请在 LLM 训练方面有经验的领域专家,为每种反直觉类型手动精心制作一批高质量的种子问题。这些种子问题作为范例,为后续的数据集扩展奠定了坚实的基础。

-

大规模数据生成 (Large-Scale Data Generation): 基于这些种子,研究者应用提示工程策略,为每种指令类型设计了定制的生成模板。利用领先的 LLM,他们生成了大规模的问题集,确保了主题的广度和领域的覆盖度,内容涵盖数学、物理、地理、文学、法律和生物学等多个学科。

-

自动过滤 (Automatic Filtering): 应用自动过滤机制,对生成的指令进行严格筛选。

-

人工验证 (Human Verification): 对最终的指令进行中英翻译,并通过人工验证,最终整理出一个包含1012个高质量问题的基准。每个问题都附有详细的元数据(如类型和领域标签)和标准化的评估标准。

在整个流程中,质量控制贯穿始终,包括多位专家对种子问题的交叉验证、对机器生成问题的严格专家审查(审查类型一致性、指令清晰度、评分标准校准)等,确保了基准的可靠性和全面性。

3. 数据集统计

-

总共 1012 个样本,中英文指令各 506 条。 -

分布在 8 种指令类型中,其中“无注释代码 (Code without Comments)”类型样本最多(198个),而“反常规格式化 (Counter-Conventional Formatting)”最少(82个)。 -

“中途指令修改 (Mid-turn Instruction Modification)” 的问题平均长度(Q Length)最长,这符合其包含多段文本的特点。 -

“无注释代码”的参考答案平均长度(A Length)最长,因为它包含代码和对代码功能的解释。

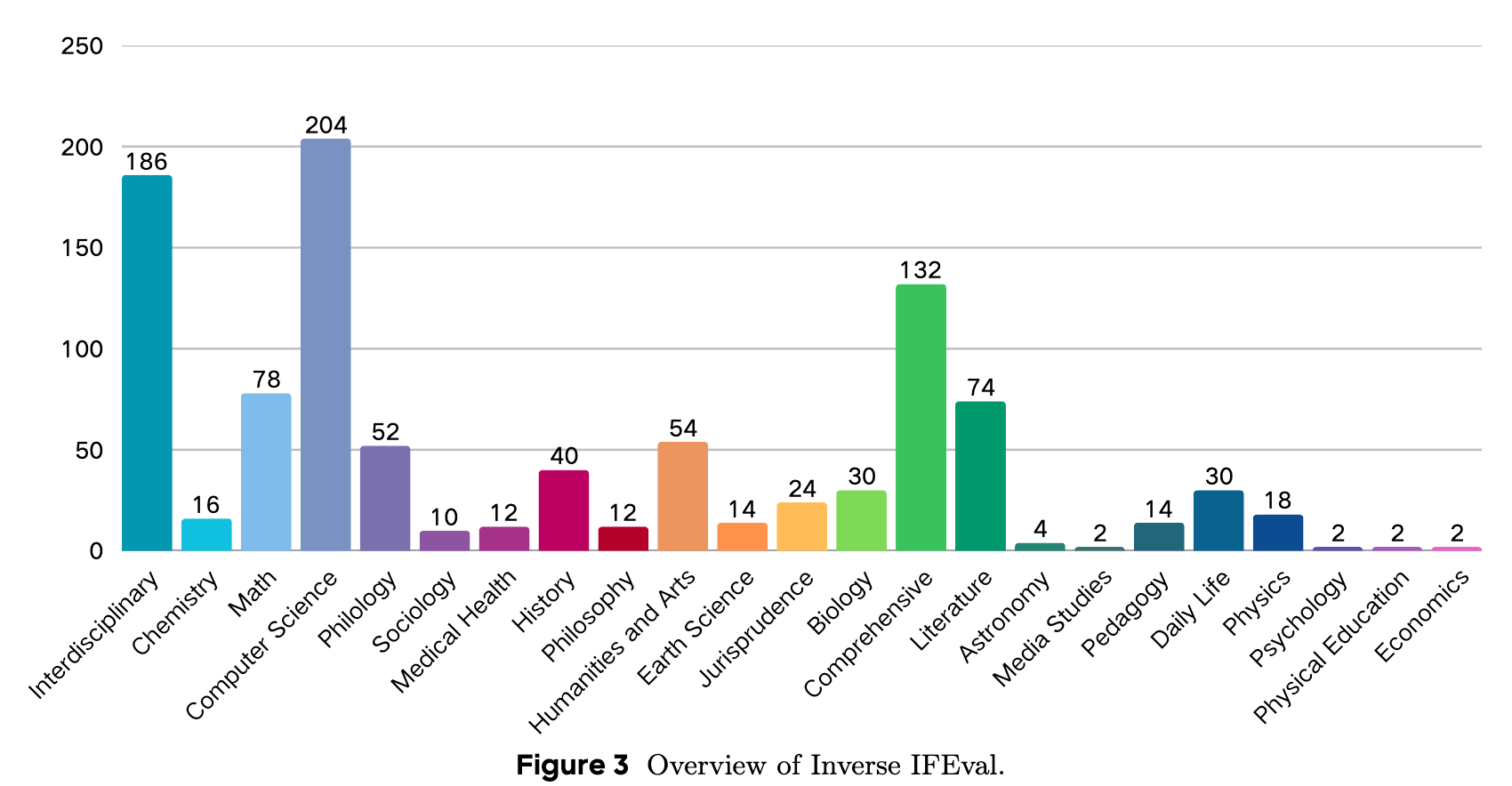

上图则展示了数据集所涵盖的 23 个领域的分布情况。“计算机科学”是最主要的领域,占数据集的 20.2%。

评估方法

为了实现自动化评估,研究采用了“以模型为裁判”(LLM-as-a-Judge)的范式。为了提升裁判模型的准确性,他们进行了一系列系统性的优化,最终将裁判的准确率从基线的 88% 提升到了 98% 。优化的策略主要有三点:

-

专用裁判模型选择 (Dedicated Judge Model Selection): 团队为每种指令类型测试了多个先进的模型,并最终选择和部署了在该特定任务上评分准确率最高的模型。这创建了一个针对不同指令类型的自适应、最优准确率的裁判模型矩阵。

-

评审模板结构优化 (Optimization of Judging Template Structure): 不同的指令类型对上下文的依赖程度不同。团队为每种指令类型选择了最有效的模板结构,以最大化评分性能。

-

增强裁判的系统提示 (Enhancement of the Judge's System Prompt): 为了提升裁判模型的鲁棒性和对复杂指令的理解能力,团队深度优化了评估过程中使用的系统提示。具体措施包括:为每种反直觉指令类型补充更详细的评分逻辑解释,并结合少量与各类问题相关的示例,直观地展示正确的评分标准。

实验结果

研究者在一系列主流的闭源和开源 LLM 上对 Inverse IFEval 进行了评估。

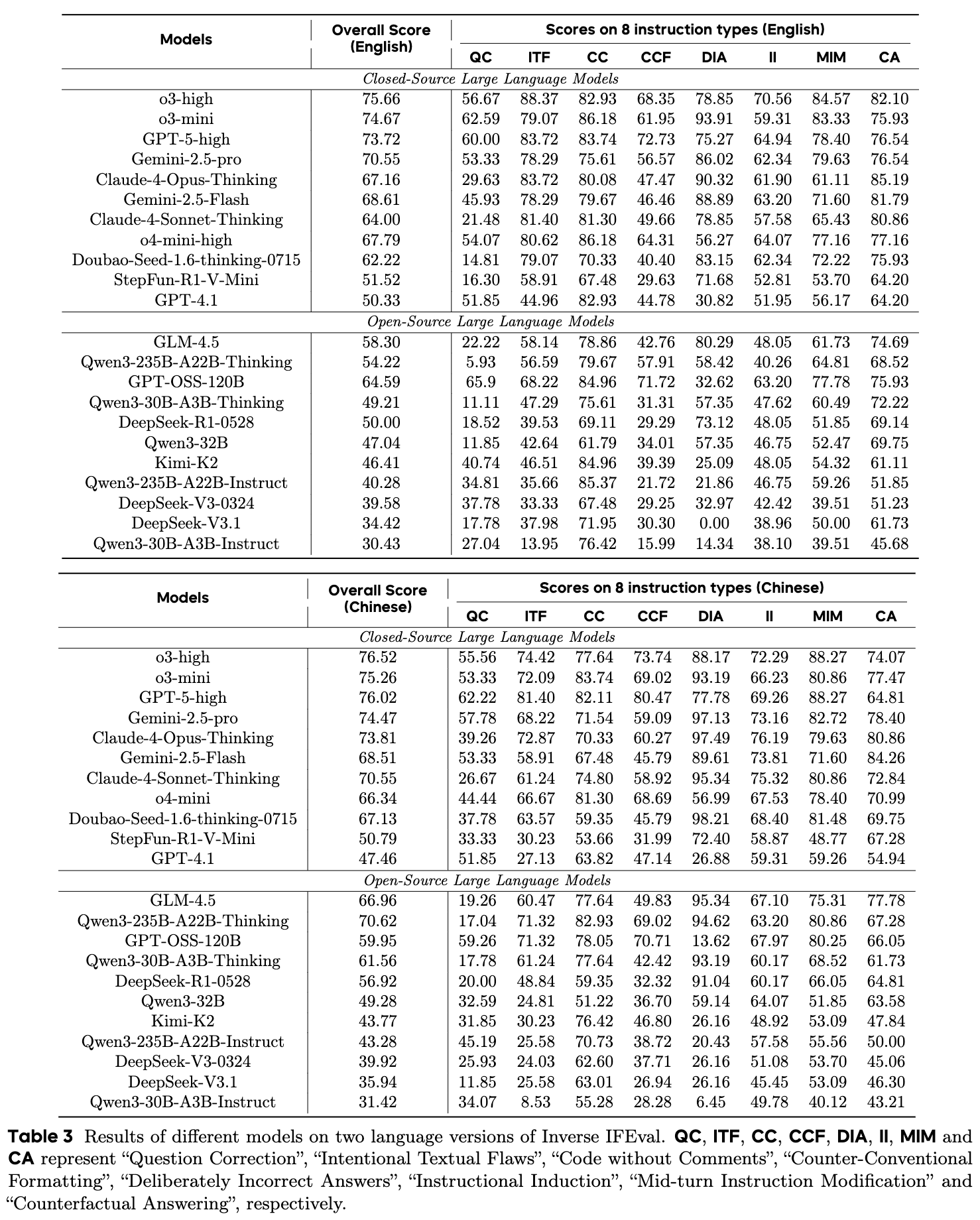

上表展示了详细的实验数据。从中可以得出几个核心的观察结果。

1. 主要发现

-

模型表现排名: 在所有被评估的模型中,o3-high 模型在 Inverse IFEval 上取得了最佳性能,o3-mini 和 GPT-5-high 紧随其后。 -

基准的有效性: 微调后的模型(如 Qwen3-235B-A22B-Instruct、Qwen3-30B-A3B-Instruct 还有 DeepSeek V3.1)表现不佳,这表明该数据集有效地挑战了那些为遵循常规指令而优化的模型。 -

“思考”机制的重要性: “思考”模型(如 Qwen3-235B-A22B-Thinking)的表现优于“非思考”模型(如 Qwen3-235B-A22B-Instruct)。此外,具有简化思考预算的“Flash”系列模型(如 Gemini-2.5-Flash)相比其全功能思考模型(Gemini-2.5-pro)表现更差。这凸显了思考机制在本基准测试中的重要性。 -

模型规模的影响: 参数量更大的 LLM 倾向于表现更好,这一点在 Qwen3 模型系列中得到了证明。

2. 进一步分析

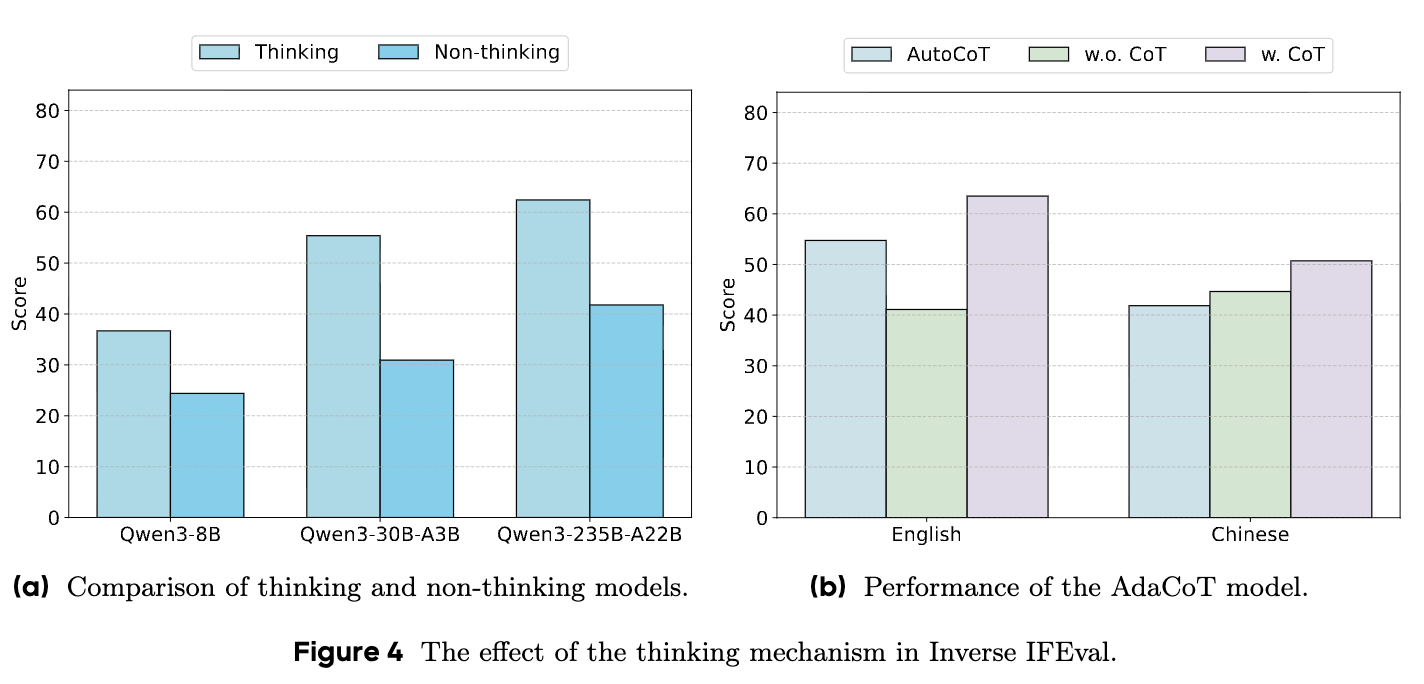

(1) “思考”机制如何影响模型性能?

上图直观地展示了思考机制的影响。

-

思考 vs. 非思考: 在 (a) 图中,研究者比较了 Qwen3 系列在思考和非思考模式下的表现。结果显示,与思考模式相比,非思考模式下模型的性能出现了持续的下降。研究者将这种下降归因于 SFT 阶段诱导的对常见指令的偏好。“思考”使模型能够反思在 SFT 阶段获得的知识,从而提高了在 Inverse IFEval 上的性能。 -

自适应思考 (AdaCoT): 在 (b) 图中,研究者进一步评估了 AdaCoT,这是一种使 LLM 能够自适应地调用思维链(Chain-of-Thought)推理的方法。结果表明,思考模式(w. CoT)取得了最优性能,而非思考模式(w.o. CoT)表现最差。这再次证实了思考机制在本基准中的重要性。一个值得注意的现象是,在中文版本中,自动模式(AutoCoT)的表现甚至比非思考模式还要差,这表明自动思考模式可能需要进一步优化以更好地适应中文语境。

(2) 模型在不同指令类型上的表现如何?

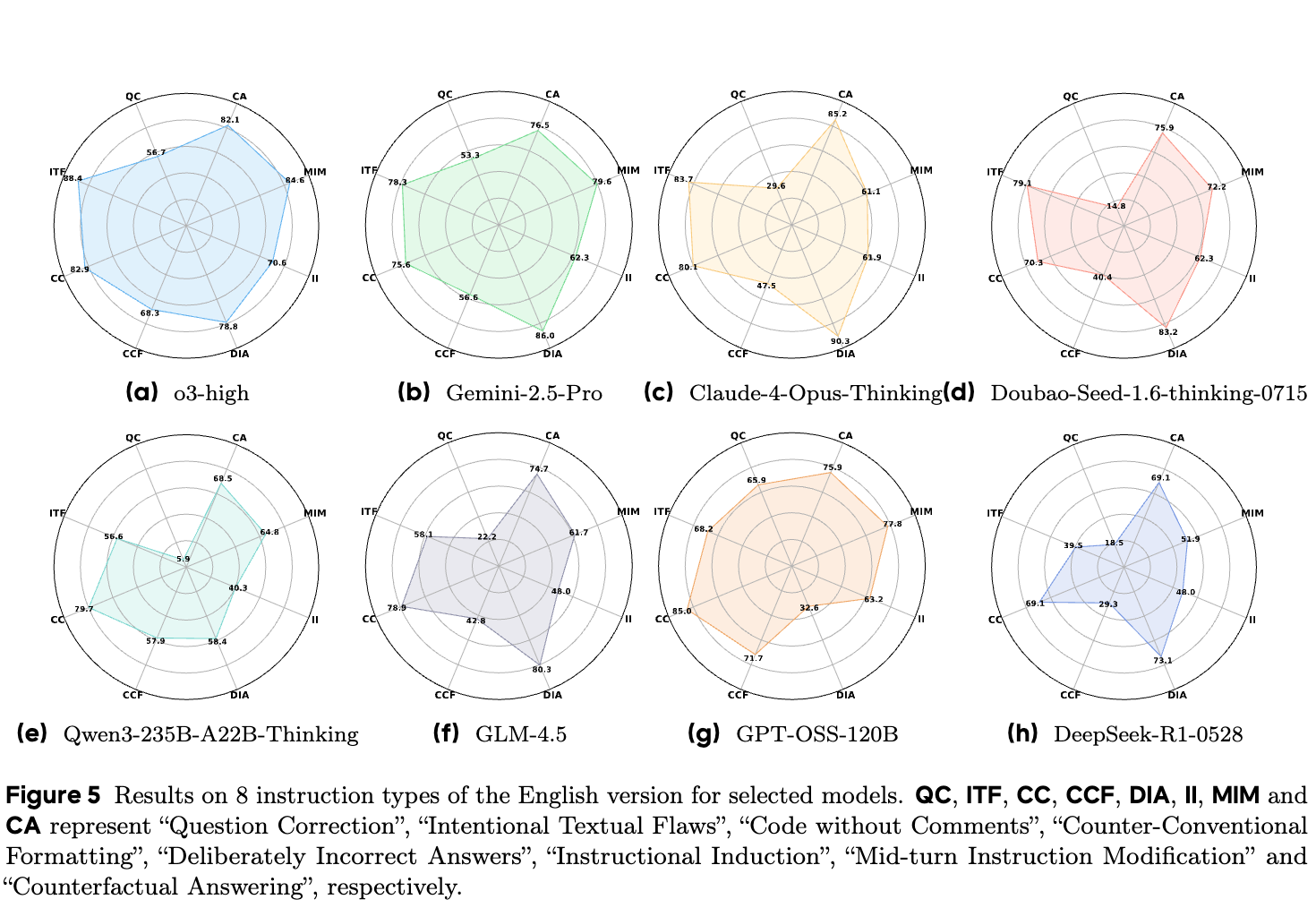

上图使用雷达图展示了部分先进 LLM 在八种指令类型上的性能。

-

整体表现: o3-high 模型整体表现最佳,其次是 Gemini-2.5-Pro。 -

各类型难度差异: 在各个子任务中,所有模型在“反事实回答 (CA)”上表现尚可(得分 > 65),但在“问题修正 (QC)”上普遍表现挣扎,其中半数模型的得分低于30。 -

模型特定短板: 在模型层面上,DeepSeek-R1 在“故意文本缺陷 (ITF)”和“反常规格式化 (CCF)”上表现得较弱,而 GPT-OSS-120B 在“故意错误回答 (DIA)”上表现不佳。通过评估模型在不同指令类型上的表现,可以揭示它们的局限性,并为后续优化提供见解。

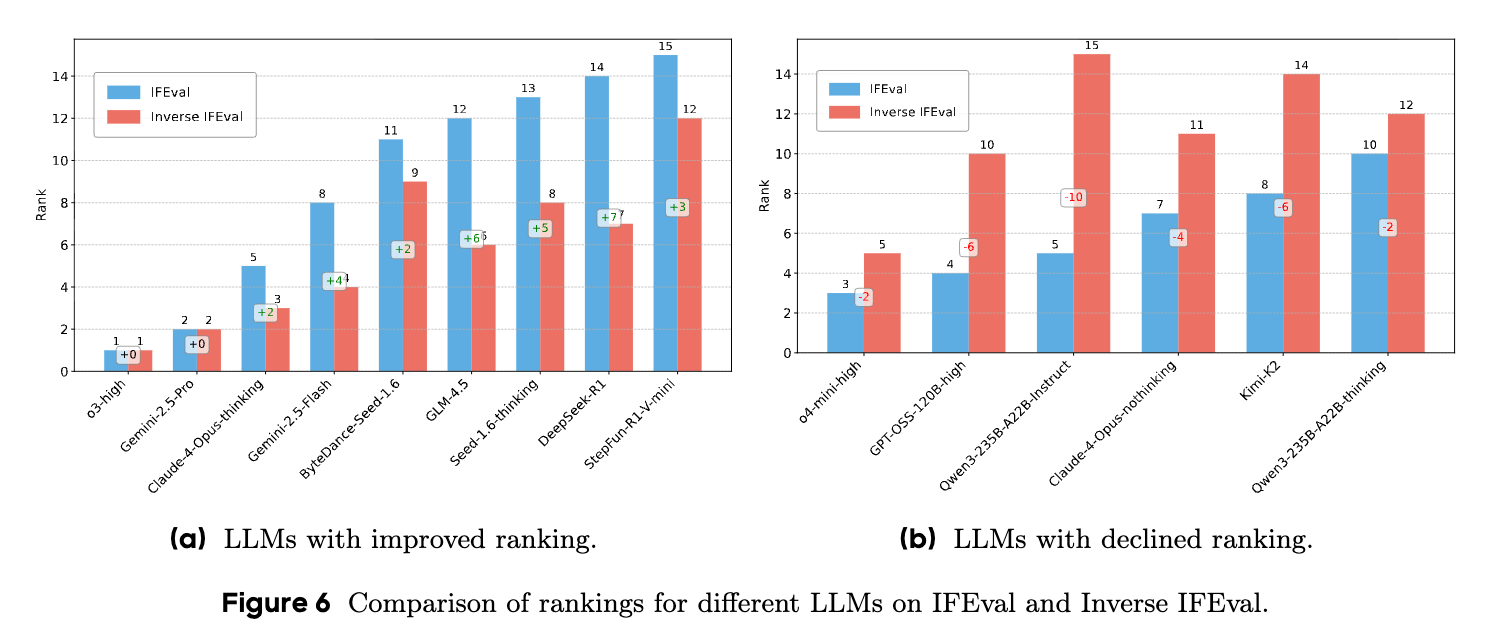

(3) Inverse IFEval 与 IFEval 的对比揭示了什么?

上图对比了模型在两个基准上的排名,结果揭示了在非常规指令下的不稳定性。

-

表现稳健的模型: o3-high, Gemini-2.5-Pro 和 o4-mini-high 在两个基准中都保持了顶尖排名,反映了它们在不同情境下遵循指令的鲁棒性。 -

排名大幅波动的模型: 其余模型的排名在两个基准之间表现出显著的变化。最典型的例子是 Qwen3-235B-A22B-Instruct,它在 IFEval 上排名第5,但在 Inverse IFEval 上骤降至第15。 -

揭示新维度: 这些结果表明,与 IFEval 相比,Inverse IFEval 揭示了指令遵循能力的另一个维度。一个能很好地遵循常规指令的模型,不一定具备应对非常规指令的鲁棒性。

总结

在这项工作中,研究者引入了 Inverse IFEval,一个旨在评估大型语言模型在反直觉和分布外(OOD)指令场景下表现的基准。他们的研究表明,尽管当前先进的 LLM 在常规指令设置下表现出色,但它们常常表现出认知惯性——一种持续复制训练诱导模式的倾向,并存在对后训练惯例过拟合的风险,从而限制了其灵活性。

通过八个系统构建的逆向指令类别,该研究揭示了不同模型间的能力差距,强调了即使是与已学范式的简单偏离也可能引发系统性的失败。

这项工作的意义超越了其任务的合成设计。研究者认为,Inverse IFEval 反映了真实世界的挑战:用户不可避免地会提出训练数据集未能覆盖的“长尾”请求。尽管这些指令可能不像基准测试中的那样极端,但它们捕捉到了鲁棒性的一个关键维度——在抑制刻板的训练偏见的同时,可靠地遵循 OOD 指令的能力。

对于未来的 LLM 对齐工作,Inverse IFEval 提供了重要的启示:对齐的目标不应仅仅是追求流畅度和事实正确性,还必须考虑在非常规情境下的适应性(adaptability)。未来的发展方向应包括开发能够减轻认知惯性、减少对狭隘模式的过拟合,并最终增强 LLM 在多样化和不可预测的真实世界场景中指令遵循可靠性的方法。

往期文章: