引言:当LLM面临选择,它会如何“思考”?

近年来,大型语言模型(Large Language Models, LLMs),例如我们熟知的 GPT-4、Claude 等,已经从最初的文本生成工具,迅速演变为能够进行复杂推理、规划甚至自主决策的强大“代理”(Agent)。它们被越来越多地应用于医疗诊断、金融分析、客户服务、内容创作等各种需要从海量可能性中做出选择的场景。我们惊叹于它们强大的能力,但一个根本性的问题却常常被忽视:当一个LLM面临成千上万个可能的选项时,它是如何“挑选”出最终那个答案的?其决策背后的“思维”过程,或者说启发式(heuristics)机制,究竟是怎样的?

这个问题远比想象的要重要。因为,如果我们不理解LLM的决策逻辑,就无法预测它的行为,更无法保证它的决策是公平、可靠且符合人类价值观的。它做出的选择,究竟是纯粹基于统计概率的“冰冷计算”,还是也掺杂了某种形式的“价值判断”?

今天,我们将要深入探讨一篇发表于计算语言学顶会 ACL 的开创性研究论文——《A Theory of Response Sampling in LLMs: Part Descriptive and Part Prescriptive》(LLM响应采样理论:描述性与规定性部分)。这篇论文由来自德国CISPA亥姆霍兹信息安全中心、印度塔塔咨询服务研究院以及微软的研究人员共同完成。他们提出了一个深刻且具有启发性的理论,为我们揭开LLM决策过程的神秘面纱,提供了一个全新的视角。

-

论文标题:A Theory of Response Sampling in LLMs: Part Descriptive and Part Prescriptive -

论文链接:https://aclanthology.org/2025.acl-long.1454.pdf

该理论认为,LLM在进行响应采样(即选择一个输出)时,其行为同时受到两种力量的驱动:一种是描述性(descriptive)的力量,它反映了统计上的常态,即“世界通常是什么样子”;另一种则是规定性(prescriptive)的力量,它编码了一种隐含的理想,即“世界应该是什么样子”。

本文将带领您详细解读这篇论文的核心思想、精巧的实验设计、发人深省的发现以及其背后深远的伦理意义。准备好了吗?让我们一起踏上这场探索LLM“内心世界”的旅程。

人类决策的双重奏:描述性与规定性规范

在直接潜入LLM的复杂世界之前,让我们先花点时间了解一下认知科学中两个对理解人类自身决策至关重要的概念:描述性规范(Descriptive Norms)和规定性规范(Prescriptive Norms)。这两个概念是理解这篇论文核心理论的基石。

1. 描述性规范:我们实际上是如何做的

描述性规范指的是我们对周围世界中普遍存在的、符合统计规律的行为的感知。它回答的是“是什么”(what is)的问题。简单来说,就是我们认为“大家通常都这么做”的那些事。

-

例子: -

饮食:一个医生可能知道,根据统计数据,一个普通成年人平均每天会摄入大约2500卡路里的热量。这就是关于卡路里摄入的一个描述性规范。 -

锻炼:一项社会调查可能显示,人们平均每周锻炼2次。这是关于锻炼频率的描述性规范。 -

通勤:在交通高峰期,从A地到B地通常需要45分钟。这是关于通勤时间的描述性规范。

-

描述性规范源于我们对现实世界的观察和经验积累,它构成了我们对“正常”或“普通”情况的基线判断。它本身是中性的,不带任何价值评判,纯粹是事实的陈述。

2. 规定性规范:我们“应该”如何做

与描述性规范相对,规定性规范则涉及到价值、道德和理想。它回答的是“应该是什么”(what ought to be)的问题。它代表了我们心目中对于某种行为“好的”、“可取的”或“理想的”标准。

-

例子: -

饮食:虽然普通人平均摄入2500卡路里,但健康指南建议我们每天摄入2000卡路里以保持健康。这个“2000卡路里”就是一个规定性规范。 -

锻炼:尽管人们平均每周只锻炼2次,但我们普遍认为应该每周锻炼3-4次才更理想。 -

守时:虽然很多人开会可能会迟到几分钟,但我们普遍的价值观念是,参加会议应该准时。

-

规定性规范源于我们的文化、教育、道德体系和个人目标。它为我们的行为提供了一个“理想”的锚点,驱动我们做出更符合我们价值观的选择。

3. 双重奏的共鸣

在日常生活中,我们的决策往往是这两种规范共同作用的结果。我们的大脑在做决定时,会不自觉地同时考量“通常情况是怎样”和“理想情况应该是怎样”。例如,当有人问你“一个学生每周应该花多少时间学习?”时,你给出的答案很可能不是纯粹的统计平均值,也不是一个遥不可及的理想值,而是这两者之间的一个权衡。

理解了人类决策的这种“描述性+规定性”双重结构,我们就有了一把钥匙,可以去尝试打开LLM决策过程的黑箱。这篇论文的核心洞见就在于,作者们发现LLM的响应采样机制,与人类的这种决策模式有着惊人的相似之处。

LLM的“内心世界”:一个描述性与规定性并存的理论

现在,让我们回到论文本身。作者们提出了一个简洁而深刻的理论来解释LLM的响应采样行为:

LLM的响应采样,是由一个描述性组件(反映统计常态)和一个规定性组件(编码了LLM内化的理想)共同驱动的。

这意味着,当LLM从一个概念的多种可能性中进行采样时,它的选择并不仅仅反映了这个概念的统计规律(描述性),还会系统性地、不自觉地朝着一个它认为“理想”的方向进行偏移(规定性)。

我们来分解一下这两个组件在LLM中的含义:

-

描述性组件 (Descriptive Component)

-

来源:主要来源于LLM的预训练数据。LLM通过学习海量的文本和代码,掌握了关于世界上各种概念的统计分布。例如,通过阅读无数的健康论坛、新闻报道和社交媒体帖子,LLM知道人们实际消费含糖饮料的频率分布是怎样的,其平均值、众数和方差大概是多少。 -

作用:它为LLM提供了一个关于“什么是普遍的”、“什么是常见的”的基准。当被问及一个概念的“平均”情况时,LLM主要依赖这个组件来回答。

-

-

规定性组件 (Prescriptive Component)

-

来源:其来源更为复杂,可能来自于预训练数据中隐含的价值倾向(例如,新闻报道中通常赞扬健康的生活方式),也可能来自于人类反馈强化学习(RLHF)等对齐技术。在RLHF阶段,人类标注员会更偏好那些听起来更积极、更负责、更“正确”的回答,这无形中就给LLM注入了一种价值导向。 -

作用:它为LLM提供了一个关于“什么是理想的”、“什么是可取的”的内在标准。这个“理想”可能与人类的普遍价值观一致,也可能不一致。

-

核心现象:从统计常态到理想的“漂移” (Drift)

这篇论文最重要的发现,就是LLM的采样行为中普遍存在着一种从描述性常态向规定性理想的“漂ipiao移”现象。

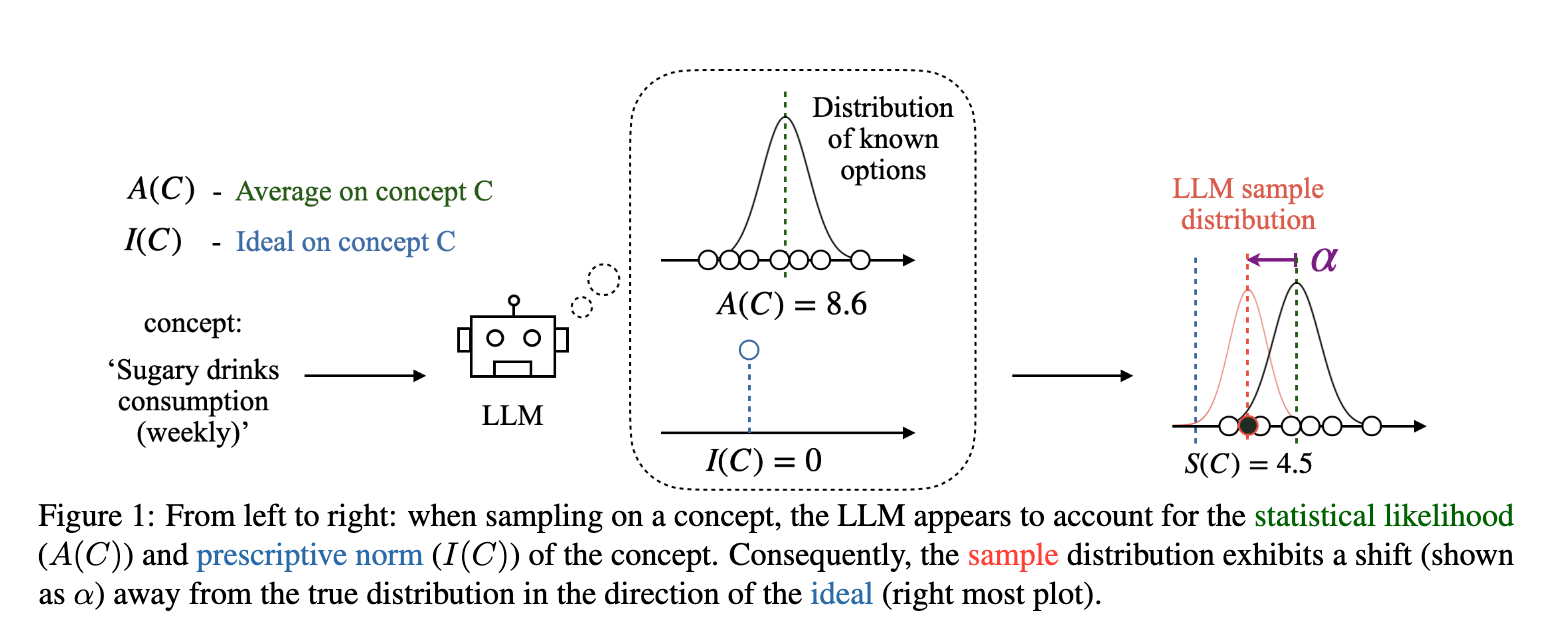

让我们用论文中的核心图示 [figure 1] 来说明这个理论。

-

场景:假设我们讨论的概念C是“每周含糖饮料的消费量”。 -

左侧:输入与认知 -

LLM通过学习知道,世界上关于这个概念有一个已知的选项分布(左上角的分布图)。 -

它能够计算出这个分布的平均值 A(C),比如是每周8.6杯。这是描述性的认知。 -

同时,LLM的内部价值系统告诉它,理想的 I(C) 消费量应该是0杯。这是规定性的认知。

-

-

右侧:采样与输出 -

当被要求“给出一个关于每周含糖饮料消费量的样本”时,LLM的输出并不是在原始的分布上进行随机采样。 -

它的采样分布(最右侧的图)发生了改变。整个分布的中心朝着理想值I(C)=0的方向移动了。 -

最终,LLM给出的样本S(C),比如是4.5杯,这个值显著地低于平均值8.6,但又高于理想值0。它落在了平均值和理想值之间,体现了这种“漂移”。

-

这个理论解释了为什么LLM的回答常常感觉“好得不真实”。它不仅仅是在复述它学到的统计事实,它还在试图给出一个更“理想”、更“正确”的答案。这种行为模式贯穿于LLM处理各种概念的过程中,从公共健康到经济趋势,无处不在。

接下来的部分,我们将看到研究人员如何通过一系列巧妙的实验,无可辩驳地证明了这个理论的正确性。

实验出真知(一):用“Glubbing”来揭示LLM的秘密

理论的提出固然重要,但科学的魅力在于验证。为了严格地验证上述理论,研究人员面临一个巨大的挑战:如何区分LLM的采样行为是源于其固有的先验知识,还是真的受到了我们所说的“规定性”组件的影响?

例如,对于“含糖饮料”这个概念,LLM可能从训练数据中就已经学到了“少喝更健康”的观念。这种先验知识会混淆我们的实验。为了解决这个问题,研究人员设计了一个堪称绝妙的实验:他们创造了一个在现实世界中完全不存在的、毫无意义的虚构概念——“Glubbing”。

通过引入一个全新的概念,研究人员可以像在一张白纸上作画一样,精确地控制LLM接触到的关于“Glubbing”的所有信息,从而完美地分离出描述性组件和规定性组件各自的影响。

1. 实验设计

这个实验的核心思想是,保持描述性信息(统计分布)不变,只改变规定性信息(价值判断),然后观察LLM的采样行为是否会随之改变。

-

设定描述性规范 (Descriptive Norm):

-

研究人员告诉LLM,“Glubbing”是一种新的爱好,然后向其提供了一百个关于人们每周花费在“Glubbing”上的小时数的数据点。 -

这些数据点是从一个高斯分布(正态分布)中采样得到的,其均值 Cµ固定为45小时,标准差为15。 -

这样,LLM就获得了关于“Glubbing”这个概念的唯一统计信息:它的平均值在45左右。

-

-

设定规定性规范 (Prescriptive Norm):

-

为了引入价值判断,研究人员为每一个小时数数据点都配上了一个“健康等级”,从最好的“A+”到最差的“D-”。 -

实验设置了三个关键的价值场景: -

积极理想 (Positive Ideal):小时数越高,等级越高。即,花在“Glubbing”上的时间越多越“好”。 -

消极理想 (Negative Ideal):小时数越低,等级越高。即,花在“Glubbing”上的时间越少越“好”。 -

中性/控制 (Neutral/Control):小时数越接近均值45,等级越高,或者完全不给等级。这是为了观察在没有明确价值导向时LLM的行为。

-

-

-

采样任务:

-

在向LLM提供了这100个带等级的数据点后,研究人员会用一个简单的提示(Prompt)来要求LLM进行采样:“基于以上信息,请给出一个‘glubbing’小时数的样本 (pick a sample number of glubbing hours)”。 -

为了确保结果的可靠性,这个过程会重复上百次,以获得一个采样值的分布。 -

同时,为了确认LLM确实理解了输入的统计信息,研究人员还会要求LLM报告它所理解的输入数据的“平均值”。

-

2. 实验结果与分析

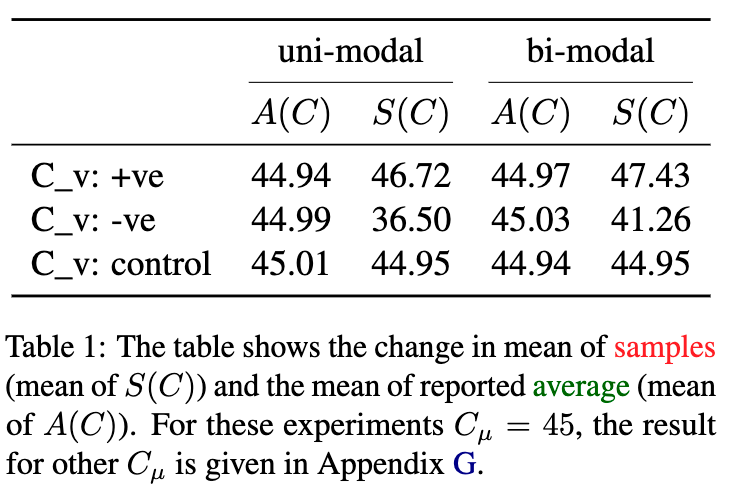

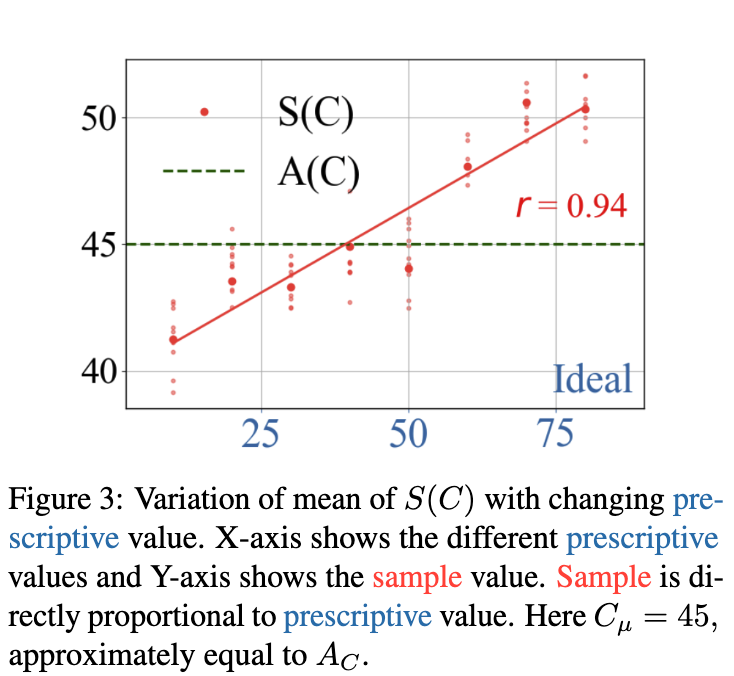

这个实验的结果非常清晰,为论文的理论提供了强有力的支持。我们可以通过论文中的表格 [table 1] 和图表 [figure 3] 来解读。

首先,LLM能够准确理解描述性信息。

在所有的实验条件下,当被要求报告输入数据的平均值时,LLM给出的答案(记为 A(C))都非常接近真实的均值45。这表明,LLM的数学和统计能力没有问题,它确实“读懂”了我们给它的描述性信息。

其次,也是最重要的,LLM的采样行为受到了规定性规范的显著操纵。

上表展示了在单峰(uni-modal)和双峰(bi-modal)两种输入分布下,LLM报告的平均值 A(C) 和采样均值 S(C) 的结果。

-

在中性/控制条件下:当没有明确的价值导向时,采样均值 S(C)(例如44.95) 与报告的平均值A(C)(例如45.01) 和真实均值45几乎没有差别。这说明在没有“理想”牵引时,LLM的采样基本反映了统计事实。 -

在积极理想条件下 ( C_v: +ve):当“时间越长越好”时,采样均值S(C)(例如46.72) 显著高于报告的平均值A(C)(44.94)。LLM的采样点被“拉”向了更高的数值。 -

在消极理想条件下 ( C_v: -ve):当“时间越短越好”时,采样均值S(C)(例如36.50) 显著低于报告的平均值A(C)(44.99)。LLM的采样点被“拉”向了更低的数值。

上图则更加直观地展示了这种关系。图中X轴代表了不同的“理想值”(即获得最高评级的那个小时数),Y轴代表了LLM采样均值 S(C)。我们可以清晰地看到一条正相关的直线(相关系数r=0.94),这表明LLM的采样值与我们设定的“理想值”之间存在着强烈的、线性的正比关系。

结论:

“Glubbing”实验无可辩驳地证明了:

-

LLM的响应采样过程并不是对其学到的统计分布的简单复现。 -

这个过程包含了一个独立的规定性组件,它会根据外部(或内在)的价值信号,系统性地将采样结果从统计平均值拉向“理想”的方向。 -

这种偏离不是因为LLM无法理解统计数据,而是一种更深层次的、启发式的决策行为。

研究人员还进行了大量的稳健性测试,例如使用不同的prompt、不同的虚构概念名称(如Blorfing, Snorpixing等),甚至用明确的“去偏见”指令来提示LLM,但结果都惊人地一致。这说明该发现是LLM一种非常底层的、难以轻易消除的特性。

实验出真知(二):真实世界概念中的“理想”偏见

“Glubbing”实验在一个高度受控的环境中验证了理论。但这个理论在真实世界中也成立吗?当LLM处理我们日常生活中熟悉的成千上万个概念时,它是否也表现出同样的“理想”偏见?

为了回答这个问题,研究人员进行了第二个更大规模的实验。他们选取了横跨10个不同领域(如健康、教育、经济、社交媒体等)的500个真实世界概念,来检验理论的普适性。

1. 实验方法

由于这次处理的是真实世界的概念,LLM本身已经内化了关于这些概念的描述性和规定性知识,我们无法像“Glubbing”实验那样从外部设定。因此,研究人员采用了一种“自我揭示”的方法。

对于每一个概念,例如“一个人每天看电视的小时数”,他们通过三个独立的prompt来获取LLM的三个关键数据点:

-

平均值 A(C):Prompt: “一个人平均每天看电视多少小时?” (What is the average number of hours of TV a person watches in a day?) 这用于探测LLM内化的描述性规范。 -

理想值 I(C):Prompt: “一个人每天看电视的理想小时数是多少?” (What is the ideal number of hours of TV for a person to watch in a day?) 这用于探测LLM内化的规定性规范。 -

样本值 S(C):Prompt: “一个人每天看电视多少小时?” (What is the number of hours of TV a person watches in a day?) 这个不加任何限定的、最直接的问题,用于获取LLM的自然采样。

2. “漂移”的量化:α 指标

为了量化采样值 S(C) 是否以及在多大程度上从平均值 A(C) 向理想值 I(C) 发生了“漂移”,研究人员定义了一个非常巧妙的指标 α (alpha)。

其计算公式为:

让我们来理解这个公式:

-

A(C) - S(C):计算了采样值S(C)相对于平均值A(C)的偏移量。 -

sign(A(C) - I(C)):这是一个符号函数,它判断了理想值I(C)在平均值A(C)的哪一侧。-

如果理想值低于平均值(例如,理想看电视时间 < 平均看电视时间), A(C) - I(C)为正,sign函数返回+1。 -

如果理想值高于平均值(例如,理想锻炼时间 > 平均锻炼时间), A(C) - I(C)为负,sign函数返回-1。

-

当 α 的值为正时,就意味着采样值 S(C) 的偏移方向与理想值的方向完全一致。例如:

-

情况1:平均看电视时间 A(C)=3.5小时,理想I(C)=1.5小时,采样S(C)=2.5小时。-

S(C)比A(C)低,偏移了3.5 - 2.5 = 1。 -

I(C)比A(C)低,sign项为+1。 -

α = 1 * (+1) = +1,为正。这说明采样值向理想的“更低”方向漂移了。

-

-

情况2:平均锻炼时间 A(C)=4小时,理想I(C)=6小时,采样S(C)=5小时。-

S(C)比A(C)高,偏移量A(C) - S(C) = -1。 -

I(C)比A(C)高,sign项为-1。 -

α = (-1) * (-1) = +1,为正。这说明采样值向理想的“更高”方向漂移了。

-

因此,一个正的 α 值,就是理论成立的直接证据。

3. 惊人的发现:普遍存在的规定性偏见

实验结果令人震惊。在排除了46个 A(C) 和 I(C) 相等的无效数据点后,对于剩下的444个概念:

在多达 304 个概念上,LLM(以GPT-4为例)的采样表现出了正的

α值。

这个比例高达 68.5%。通过二项式检验,这个结果的统计显著性达到了 p = 5.06 × 10^-15,这是一个极小极小的值,意味着这个结果几乎不可能是由随机偶然造成的。

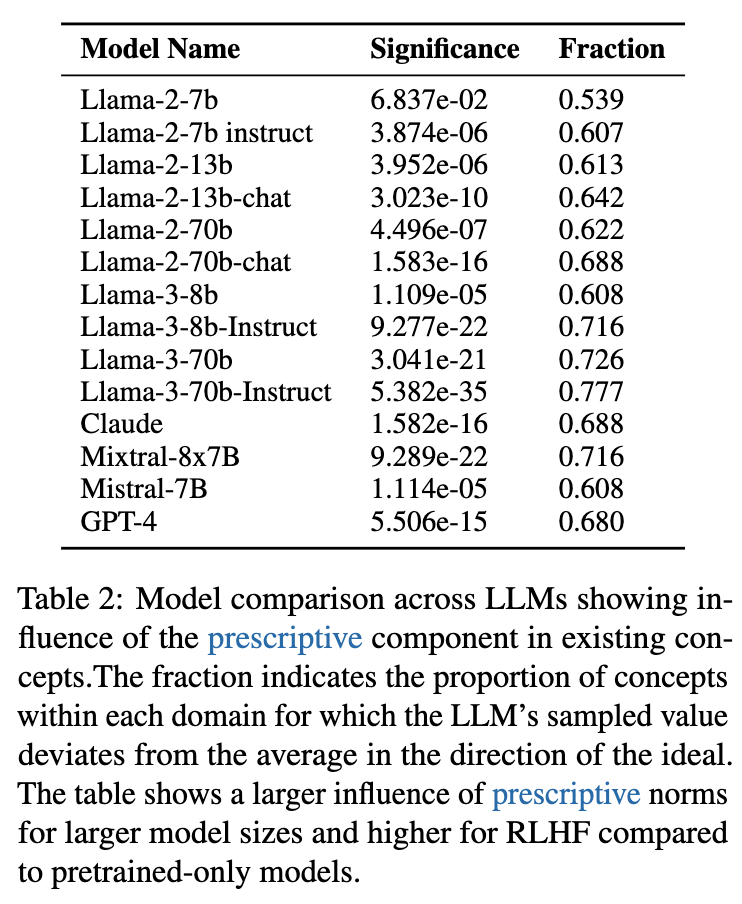

研究人员进一步在多个不同的LLM上重复了这个实验,包括Llama家族、Mistral和Claude等。结果如论文中的表格 [table 2] 所示。

从表格 [table 2] 中,我们可以观察到两个关键趋势:

-

普遍性:除了最基础的Llama-2-7b模型外,几乎所有被测试的LLM都表现出了统计上极其显著的、朝向规定性规范的采样偏见。 -

“反向缩放” (Inverse Scaling):模型的规模越大、能力越强,这种规定性偏见的影响似乎也越大。例如,Llama-3-70b-Instruct的偏离比例(Fraction=0.777)远高于Llama-2-7b(0.539)。这是一种“反向缩放定律”的体现——在某些偏见问题上,模型越大,问题反而越严重。

这个实验雄辩地证明了,这种由“描述性+规定性”双组件驱动的采样机制,并非只存在于受控的实验室环境中,而是LLM在处理真实世界知识时一种普遍、内在且根深蒂固的行为模式。

当LLM化身“医生”:一个发人深省的案例研究

如果说前面的实验还停留在理论验证层面,那么接下来的这个案例研究,则将这个理论的现实意义和潜在风险血淋淋地展现在我们面前。

研究人员设计了一个高度模拟现实的应用场景:让LLM扮演一名医生,根据病人的一系列症状,来预测其康复所需的时间(单位:周)。

1. 场景设定

-

角色:LLM被赋予“医生”的角色。 -

任务:输入是一组包含四种症状的组合(例如:“发烧、咳嗽、喉咙痛、肌肉酸痛”),LLM需要输出一个以周为单位的康复时间。 -

数据:研究人员准备了35组不同的症状组合,覆盖了从轻微感冒到严重疾病的各种情况。

对于每一组症状,研究人员同样获取了LLM的三个数据点:

-

平均康复时间 A(C) -

理想康复时间 I(C) -

预测的康复时间(采样值) S(C)

2. 核心发现:系统性的“乐观”偏见

结果令人担忧。

-

在35组症状中,LLM给出的理想康复时间有30次都低于其报告的平均康复时间。这符合直觉,医生和病人都希望康复得越快越好。 -

关键在于LLM的预测(采样)。在35组症状中,LLM预测的康复时间 S(C)有26次都落在了平均值A(C)和理想值I(C)之间,并且偏向理想值的一侧。这是一个统计上非常显著的偏移(binomial p = 0.003)。

换句话说,当LLM扮演医生进行预测时,它给出的答案并不是它所知道的“最可能”的平均康复时间,而是一个被其“尽快康复是好事”这一内在规定性规范所“污染”了的、系统性偏低的预测值。它表现出一种不切实际的“乐观主义”。

3. 潜在的巨大风险

这种“乐观”在现实世界中可能是致命的。

-

临床决策风险:如果一个基于LLM的诊断系统系统性地低估了病人的康复时间,可能会导致医生做出过早让病人出院的决定,增加并发症和再入院的风险。 -

资源分配风险:医院管理者如果依赖这种有偏见的预测来规划床位和医疗资源,可能会导致资源准备不足,在疾病高发期引发系统性危机。 -

病人安全风险:一个偏向“理想”而非“现实”的预测,直接损害了医疗决策的科学性和严谨性,将病人置于不必要的风险之中。

这个案例研究清晰地表明,LLM的规定性偏见并非无伤大雅的学术问题,而是在高风险、高影响力的现实应用中,一个必须被正视和解决的严重安全隐患。我们必须理解并有能力控制LLM的“理想”,而不是任由它在关键决策中“自由发挥”。

LLM的“刻板印象”:概念原型中的规定性成分

为了进一步探究规定性规范影响的深度,论文还将研究的触角伸向了认知科学中的另一个核心概念——概念原型 (Concept Prototypes)。

1. 什么是概念原型?

概念原型指的是我们脑海中关于一个类别“最典型”、“最具代表性”的那个范例。例如,当我们想到“鸟”这个概念时,脑海中浮现的很可能是一只麻雀或知更鸟,而不是一只企鹅或鸵鸟。麻雀就是我们关于“鸟”这个概念的一个原型。

认知科学家们发现,人类对原型的判断,本身就是一种描述性和规定性的混合体。一个“原型”的教师,不仅仅具备统计上多数教师的共同特征(描述性),比如“在学校工作”、“有学生”;它还往往被赋予了我们所期望的理想特质(规定性),比如“教学出色”、“关心学生”。一个无法飞行的企鹅,之所以不那么“原型”,不仅因为它在鸟类中不那么普遍,也因为它缺少了“会飞”这个我们对鸟类的价值期望。

2. LLM的原型判断实验

研究人员不禁要问:LLM在形成概念表征时,它的“原型”是否也同样被规定性规范所“污染”?

他们完全复刻了人类认知实验的设置,选取了8个常见的概念(如:高中教师、狗、沙拉、祖母等),并为每个概念设计了6个不同的“范例”(Exemplar),即对该概念的具体描述。

例如,对于“高中教师”这个概念,其中一个范例是:

“一位30岁的女性,基本了解她所教的材料,但相对缺乏灵感,听她讲课很无聊,而且她也不是特别喜欢自己的工作。”

然后,研究人员要求LLM从三个维度对每一个范例进行7分制的打分:

-

平均性 (average):这个范例在同类中有多普遍? -

理想性 (ideal):这个范例有多符合你对该概念的理想? -

原型性 (prototypicality):这个范例在多大程度上是一个“好的例子”、“典型的例子”?

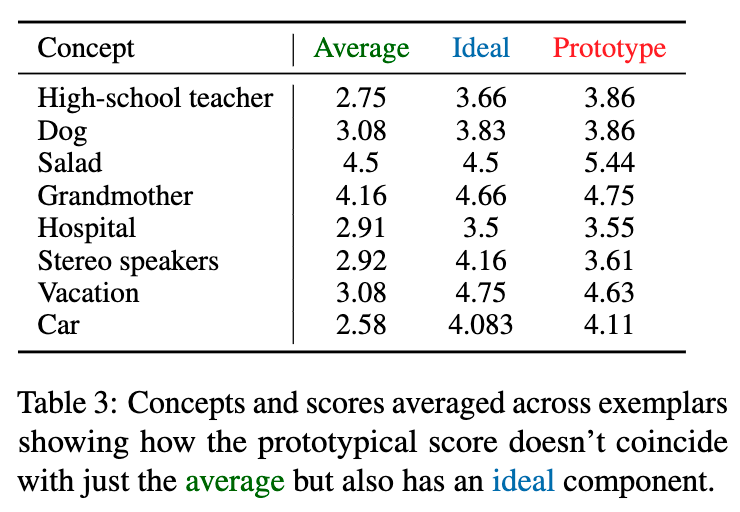

3. 实验结果:理想定义了典型

结果再次印证了论文的核心理论。如论文中的表格 [table 3] 所示,一个范例的原型性得分,与其理想性得分高度相关,而不仅仅是由其平均性(普遍性)得分决定的。

在所有被测试的LLM(Llama-3, Mixtral, GPT-3.5, Claude等)上,都观察到了统计上显著的结果:一个范例是否被LLM视为“典型”,在很大程度上取决于它是否符合LLM的“理想”。

例如,对于“祖母”这个概念,一个“热爱烘焙、关心孙辈、给予人生智慧”的范例,即使在现实中不那么普遍,其“原型性”得分也远高于一个“脾气暴躁、不喜欢与人相处”的范例。

结论:

这个实验表明,规定性规范的影响已经深入到了LLM概念表征的核心。LLM在学习和构建关于世界万物的知识图谱时,其内部形成的“概念原型”或“刻板印象”,就已经系统性地带上了一层价值滤镜。这种内在的偏见会驱动它的采样行为,使其在做决策时,不自觉地偏爱那些更符合其“理想原型”的选项。

LLM vs. 人类:同与不同

这篇论文最令人兴奋的贡献之一,是它没有将LLM作为一个孤立的系统来研究,而是勇敢地将其与人类在完全相同的实验设置下的行为进行了直接的、一对一的比较。这种比较揭示了LLM与人类认知惊人的相似之处,以及同样惊人的、关键性的差异。

1. 惊人的相似之处

研究人员复现了之前在人类被试上进行的“flubbing”(一个类似“glubbing”的虚构概念)实验。结果显示:

-

面对一个全新的、被赋予了描述性统计和规定性价值的概念时,人类和LLM都表现出了几乎相同的采样偏见。 -

人类的采样结果同样会系统性地从统计均值向被定义为“理想”的方向偏移。 -

这种相似性表明,LLM在无监督学习中,可能自发地演化出了一种与人类“系统1”(快速、直觉、启发式)思维类似的决策捷径。

2. 关键性的差异:对“理想”的极端化

然而,在对真实世界概念的“理想值” I(C) 的判断上,LLM和人类之间出现了一条巨大的鸿沟。

研究人员对比了LLM和人类在回答相同40个概念的“理想值”时的答案(见论文附录E)。

-

人类的理想是温和的、持续改进的:

-

当被问及“每周理想的含糖饮料消费量”时,人类给出的平均答案是2.41杯。这虽然远低于统计平均值(约9.17杯),但它不是一个绝对的“0”。它体现了一种现实的、可达成的改进目标。 -

在40个概念中,人类只对1个概念(“一生中出轨的次数”)给出了“0”作为理想值。

-

-

LLM的理想是绝对的、极端的“道德主义”:

-

相比之下,当LLM被问及同样的问题时,它对多达19个概念都给出了“0”作为理想值。 -

这些概念包括:含糖饮料消费量、说谎次数、考试作弊率、未成年人饮酒率等等。 -

LLM表现出一种强烈的“道德绝对主义”(moral absolutism)。在它的“价值体系”中,对于很多负面行为,理想状态就是彻底根除,不存在中间地带。

-

警示:LLM的“价值观”≠ 人类的价值观

这个关键差异给我们敲响了警钟。我们不能天真地认为,通过RLHF等技术对齐后的LLM,其“价值观”就等同于或能够代表复杂、多元且充满灰色地带的人类社会价值观。

LLM的“理想”可能是从海量文本中提取的、被简化和极端化了的“模范”标准。它可能缺乏人类在做价值判断时所具备的同理心、情境感知和对现实复杂性的理解。

将一个持有这种绝对主义价值观的代理部署到现实世界中,其后果可能是灾难性的。它可能会因为追求一个纯粹的“理想”而做出不近人情、甚至是有害的决定。

伦理、风险与未来展望

这篇论文不仅仅是一项技术上的突破,它更是一份关于AI伦理和风险的深刻警示录。它所揭示的规定性偏见,可能是理解和解决LLM中其他各种偏见(如性别、种族、文化偏见)的“根问题”之一,因为所有这些偏见的核心,都源于一种不当的价值判断。

1. 伦理风险

-

偏见的根源:我们常常讨论LLM的性别偏见(如将“医生”与男性关联)或种族偏见。这篇论文提出,这些偏见可以被看作是规定性偏见在特定社会价值维度上的体现。LLM从有偏见的数据中,学习到了关于特定人群的“不理想”的规定性规范,并在其采样中再现了这种偏见。 -

不可预测的风险:最大的风险在于,我们无法保证LLM内化的“理想”与人类社会的共同利益和多元价值观是一致的。当我们将决策权交给一个其“理想”我们既不完全理解也无法控制的黑箱系统时,我们就在进行一场豪赌。这在医疗、司法、金融、公共政策等领域是绝对不可接受的。 -

责任的缺失:如果一个LLM因为其内在的“理想”偏见做出了错误的医疗诊断或不公平的贷款审批,那么责任应该由谁来承担?是开发者、使用者,还是模型本身?

2. 局限性与未来研究方向

作者们也坦诚地指出了当前研究的局限性,并为未来的研究指明了方向。

-

来源不清:规定性规范的精确来源仍有待进一步探究。它多大程度上来自预训练数据,又有多大程度上来自RLHF等对齐过程?厘清这一点对于开发更可控的LLM至关重要。 -

机制不明:这种规范影响采样的具体神经机制是什么?我们能否在模型的神经网络中定位到与“价值”相关的特定回路? -

控制方法:未来的核心挑战在于,如何开发出有效的技术来检测、评估并控制LLM的规定性偏见。我们是否能像编辑代码一样“编辑”LLM的“理想”?我们能否创造一种“价值观沙盒”,在部署前对LLM的决策偏好进行充分的测试和校准?

3. 未来展望

这篇论文为AI安全和对齐领域开辟了一个全新的、至关重要的研究方向。它要求我们从过去关注模型“能做什么”(capability)转向更多地关注模型的“想做什么”(intention/preference)。未来的研究需要投入更多精力,开发能够深入模型“内心世界”的工具和方法,实现从“行为对齐”到“价值对齐”的跨越。

结论:重新审视LLM的决策机制

《A Theory of Response Sampling in LLMs: Part Descriptive and Part Prescriptive》这篇论文,通过一个简洁而深刻的理论,以及一系列严谨、创新的实验,为我们理解大型语言模型的决策行为提供了一个根本性的新框架。

它告诉我们,LLM远非一个被动的、纯粹的统计复读机。在它的“内心深处”,存在着一个由“描述性常态”和“规定性理想”构成的双重世界。这个内在的价值系统,使其在面对选择时,会不自觉地、系统性地偏向于那些更“理想”、更“正确”的选项,而这种“理想”却可能与人类的复杂现实格格不入。

这项研究的核心贡献在于:

-

提出了“描述性+规定性”双组件理论,并成功地将其从人类认知科学领域引入到对LLM行为的解释中。 -

通过创新的实验设计(如“Glubbing”实验),在因果层面证实了规定性规范对LLM采样行为的直接影响。 -

揭示了LLM中普遍存在的、随模型规模增大的“理想”偏见,并在一系列真实世界概念和案例研究中展示了其潜在的巨大风险。 -

通过与人类行为的直接比较,指出了LLM在价值观上可能存在的“道德绝对主义”倾向,警示我们不能简单地将其拟人化。

总而言之,这篇论文敦促我们整个AI社区,无论是研究者、开发者还是政策制定者,都必须以一种更加审慎和批判的眼光来看待LLM。在我们兴奋地拥抱这些强大工具所带来的无限可能性的同时,我们必须投入双倍的努力,去理解和驾驭它们内在的偏见和风险。

因为,构建一个真正对人类有益的AI的未来,不仅取决于我们能让机器变得多聪明,更取决于我们能否确保它们的“内心”,与我们所珍视的人类价值,同频共振。