在RLVR的框架下,模型的训练目标通常是最大化 pass@1 的性能。pass@1 指标衡量的是模型生成一次回答时,其正确率的期望值。为了提升 pass@1,模型会倾向于将概率质量高度集中在它最有信心的那条推理路径上。这种策略,虽然在单一答案生成的场景下表现出色,但却可能以牺牲 pass@K(K>1)性能为代价。pass@K 指标衡量的是模型生成 K 个不同答案时,其中至少有一个是正确的概率。一个高 pass@K 性能的模型,意味着它具备生成多样化且高质量解题路径的能力,这反映了其更强的探索能力和更全面的问题理解能力。

现有研究观察到,许多主流的 RLVR 方法在提升 pass@1 的同时,往往伴随着 pass@K 性能的下降。模型似乎陷入了一种“思维定式”,而忽略了对更广阔解题空间的探索。这种能力的退化,限制了模型在面对新颖或更复杂问题时的泛化能力和鲁棒性。

这个瓶颈的核心在于训练动态本身。RLVR 的更新机制,特别是像 GRPO(Group Relative Policy Optimization)这样的算法,系统性地引导模型将概率分布向最顶尖的候选者(top-1 candidate)倾斜。长此以往,概率质量会过度集中,导致其他同样有效但初始概率稍低的推理路径被抑制,甚至完全消失。这就解释了为什么 pass@K 性能会下降:模型已经“忘记”了如何生成那些非最优但同样正确的答案。

西湖大学的论文《SIMKO: SIMPLE PASS@K POLICY OPTIMIZATION》深入分析了 RLVR 训练过程中 token 级别的概率分布动态,并提出了一个名为 SimKO(Simple Pass@K Optimization)的新方法。SimKO 的设计目标明确:通过一种不对称的梯度调整策略,缓解概率过度集中的问题,从而在不牺牲 pass@1 的前提下,显著提升 pass@K 性能,鼓励模型进行更广泛的探索。

-

论文标题:SIMKO: SIMPLE PASS@K POLICY OPTIMIZATION -

论文链接:https://arxiv.org/pdf/2510.14807

1. RLVR 过度专注与探索能力下降

为了深入理解 RLVR 方法为何会抑制模型的探索能力,我们需要从其底层机制入手,审视 token 级别的概率分布在训练过程中的演变。

1.1 token 级别的概率分布视角

一个 LLM 在生成文本时,本质上是在每个时间步(decoding step)根据当前已经生成的上下文,预测下一个 token 的概率分布。这个分布覆盖了整个词汇表(vocabulary)。模型最终是探索多条不同的推理路径,还是收敛到单一的确定性轨迹,完全取决于这些概率分布的形态。

-

探索性强的分布:概率质量会相对均匀地分布在多个有潜力的候选 token 上。例如,在解一个数学题的某个步骤,可能有多种不同的公式或方法可以尝试,一个探索性强的模型会给这些选项都分配不可忽略的概率。 -

利用性强的分布:概率质量会高度集中在单一的、模型认为最优的 token 上。这种分布会导致模型的生成行为趋向于确定性,总是选择概率最高的那个选项。

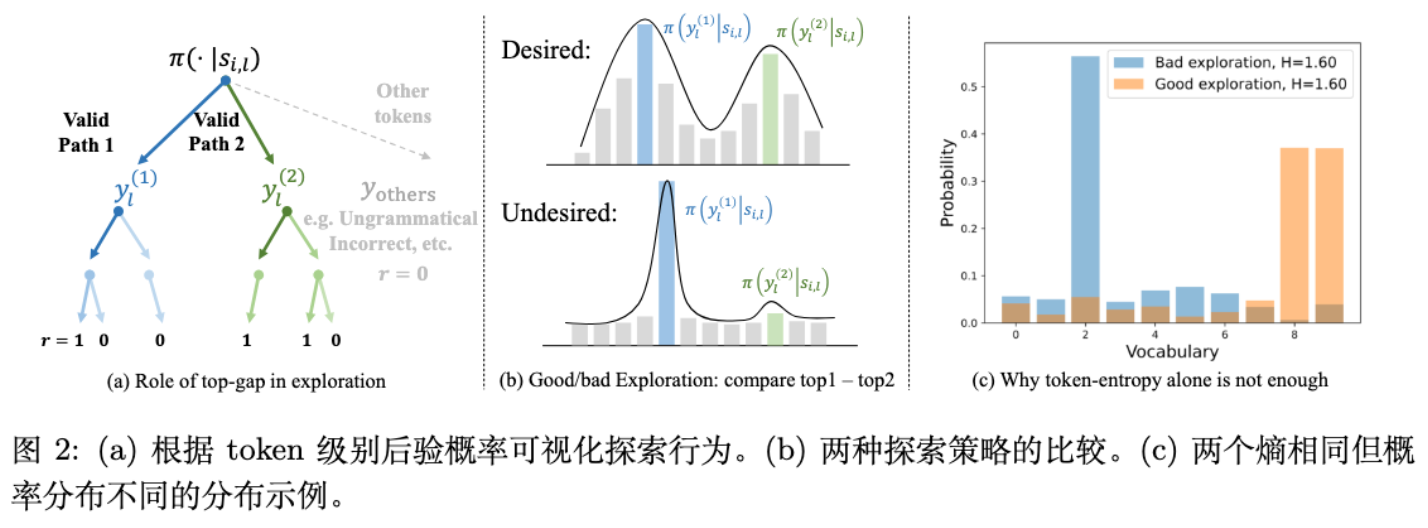

上图 (a) 和 (b) 描绘了理想的探索行为(Desired):当模型面临一个决策点,存在两条同样有效的推理路径(Valid Path 1, Valid Path 2)时,一个具备良好探索能力的模型会给这两条路径的起始 token 分配比较接近的概率,从而使得概率分布的顶端(top candidates)相对平坦。相反,不良的探索行为(Undesired)则会将概率过度集中在某一个选项上,形成尖锐的分布,从而抑制了其他可能路径的生成。

而上图 (c) 则揭示了一个更为深刻的问题:为什么仅仅依赖熵(entropy)这样的宏观指标来衡量探索是不够的。图中展示了两种概率分布,它们的熵值完全相同(H=1.60),但其探索潜力却截然不同。“好的探索”分布(蓝色)将概率主要分配给了少数几个顶尖的候选者,而“坏的探索”分布(橙色)虽然熵值一样,但它将概率高度集中于 top-1,然后将剩余的概率质量分散到大量几乎无关的 token 上。

这清晰地表明,仅依赖熵这样的单一标量指标来评估或控制探索是不足够的。我们需要一种更精细的方法来直接审视顶尖候选者之间的概率动态,而这也正是本文分析方法的核心出发点。

1.2 GRPO 训练动态下的概率集中效应

本文的作者通过实验,直接追踪了在 GRPO 训练过程中,模型对 top-K 候选 token 的平均对数概率(average log-probability)的变化。他们定义了一个度量指标 ,用于表示在整个生成过程中,排名第 k 的候选 token 的平均对数概率:

其中, 是生成的响应总数, 是第 个响应, 是在第 个解码步骤时,根据当前策略 排名第 的候选 token。

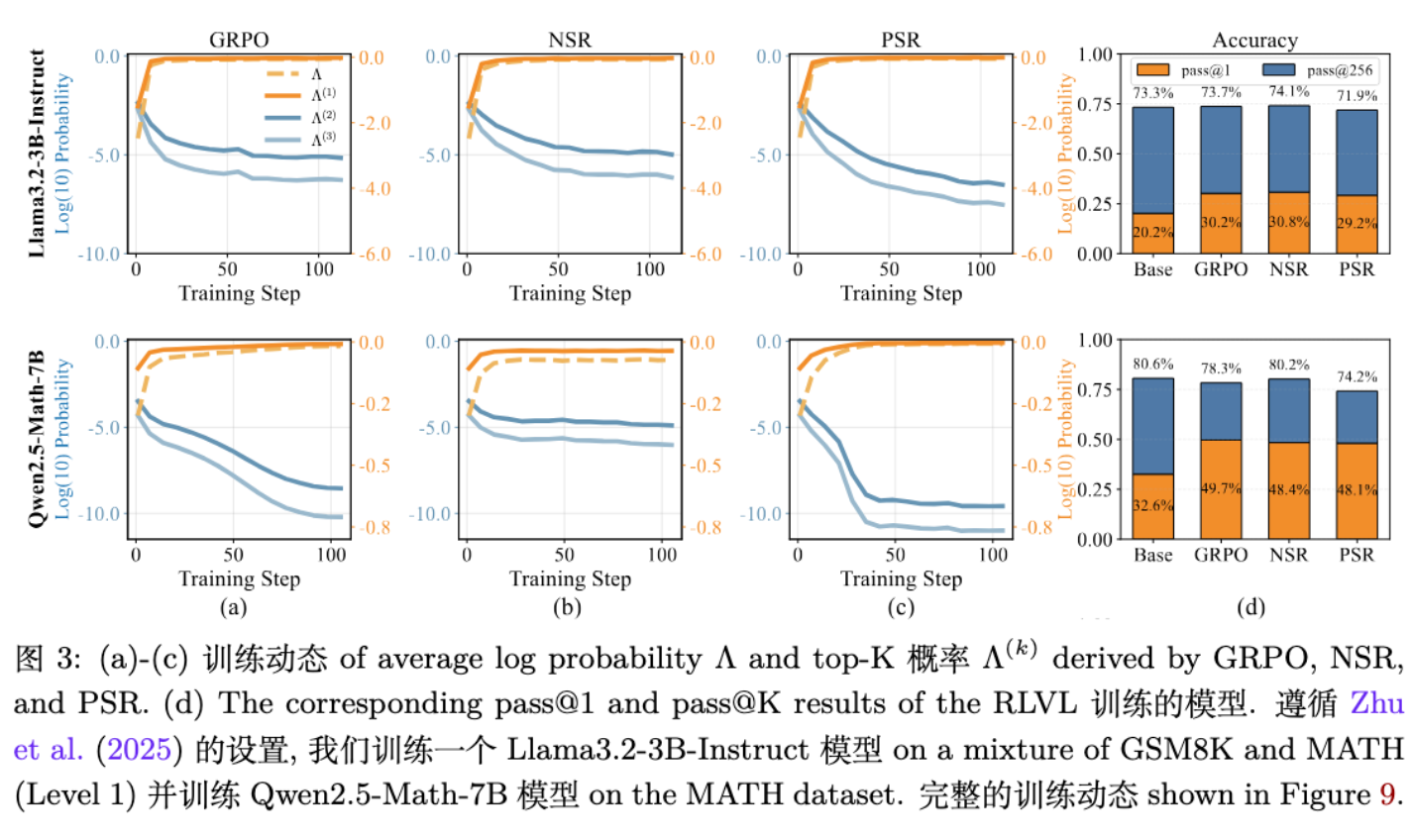

通过对不同模型(如 Llama3.2-3B, Qwen2.5-Math-7B)的训练过程进行追踪,作者发现了一个清晰且一致的模式(图3a-c):

-

GRPO 的影响:在使用标准 GRPO 算法进行训练时,排名第一的候选者()的概率 迅速接近于实际采样 token 的概率 ,并趋近于饱和(log 概率接近 0,即概率接近 1)。与此同时,其他排名靠后的候选者( 等)的概率则急剧下降,趋向于一个可以忽略不计的极小值。这表明,GRPO 倾向于将几乎所有的概率质量都堆积在 top-1 候选者上。 -

正负样本的解耦分析:为了进一步探究这种现象的成因,作者将 GRPO 的梯度更新分解为两部分:来自正确样本的正向梯度(Positive Sample Reinforce, PSR)和来自错误样本的负向梯度(Negative Sample Reinforce, NSR)。实验发现,PSR 过程极大地加剧了概率集中效应,而 NSR 过程虽然能在一定程度上缓解该问题,但效果有限。本质上,对正确答案的“奖励”过程是导致模型过度自信、放弃探索的主要驱动力。

1.3 概率集中与 pass@K 性能的负相关性

最为关键的发现是,概率分布的集中程度与模型的 pass@K 性能之间存在着明显的负相关关系。

图 3d 实验结果显示,当 top-1 候选者与其他候选者之间的概率差距越大时,模型的 pass@K 准确率就越低。这个观察结果为解决 RLVR 的探索困境指明了方向:如果我们能够设计一种机制,来主动地缓解这种过度集中的趋势,那么我们就有可能在提升模型探索能力的同时,改善其 pass@K 性能。

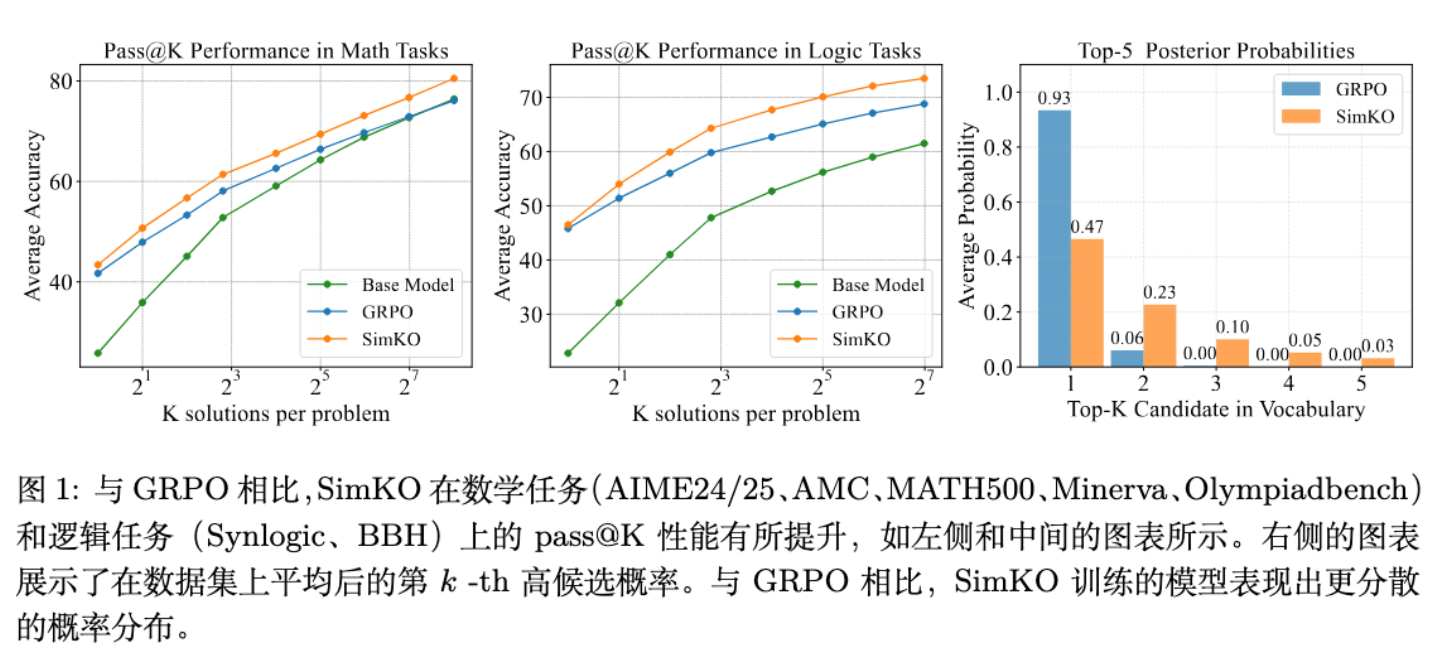

下图直观地总结了本文的核心发现与贡献:

这张图清晰地揭示了三个关键信息。首先,在左侧和中间的 Pass@K 性能图中,SimKO 在数学和逻辑推理任务上,于所有 K 值范围内均一致地优于标准的 GRPO 算法,证明了其在提升多样化推理路径生成能力上的有效性。其次,右侧的后验概率分布图揭示了这一性能优势背后的根本原因:与 GRPO 将绝大部分概率质量集中在 Top-1 候选者(蓝色条高达 0.93)不同,SimKO 采用的策略使得概率分布更为平缓,在降低 Top-1 概率的同时,为 Top-2 至 Top-5 的候选者保留了显著的概率质量。这种“去集中化”的分布形态正是 SimKO 能够鼓励模型进行更广泛探索的关键。这个核心洞察构成了 SimKO 算法的设计基础,我们将在下文详细阐述其具体机制。

2. SimKO

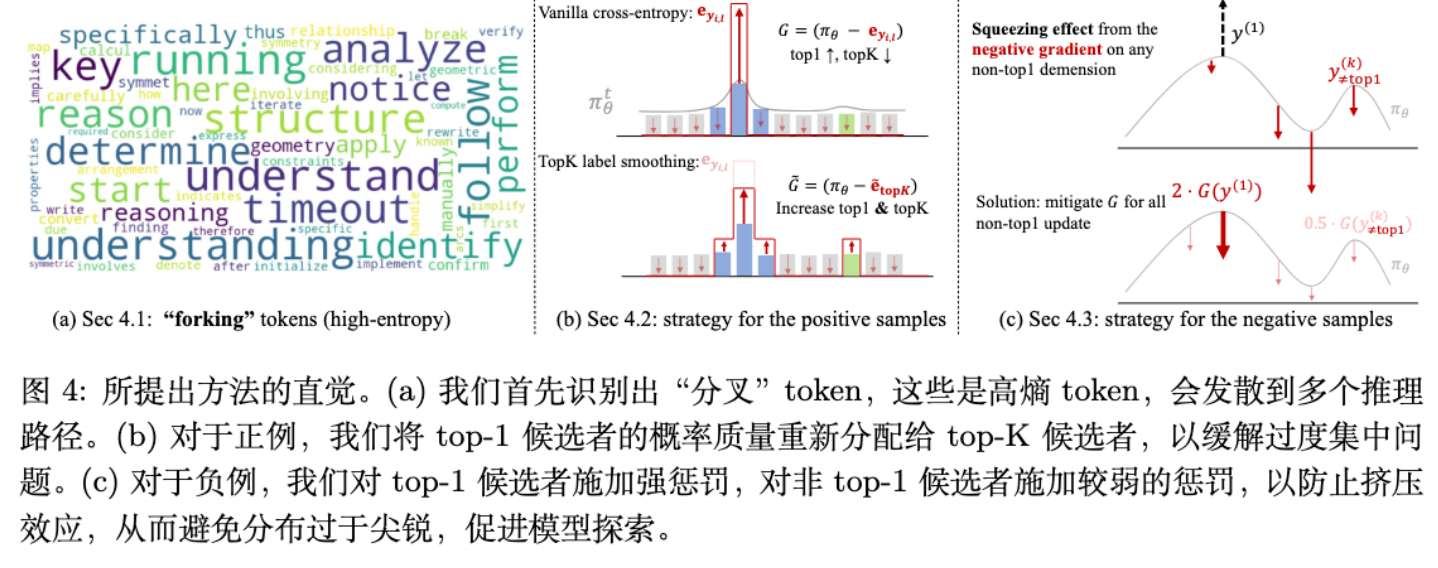

基于上述分析,SimKO 的核心思想是重新分配梯度更新的影响力,避免让 top-1 候选者独占所有的“功劳”,从而维持一个更加平坦、更利于探索的概率分布。SimKO 的实现包含三个关键步骤:

-

识别关键的“分叉”节点(Identifying "forking" tokens):并非序列中的所有 token 都对推理路径的选择同等重要。SimKO 专注于那些对推理走向具有决定性影响的“分叉”点。 -

为正向梯度引入 Top-K 标签平滑(Top-K label smoothing for positive gradients):对于来自正确答案的奖励信号,SimKO 不再将其完全归功于实际采样到的 token,而是将这份奖励“分享”给排名前 K 的其他高概率候选者。 -

强化对负向梯度中 Top-1 的惩罚(Strengthening rank-1 updates for negative gradients):对于来自错误答案的惩罚信号,SimKO 会对其中的 top-1 候选者施加更强的惩罚,迫使其让出概率质量给其他可能的选项。

这种非对称的设计,使得 SimKO 能够精准地在鼓励探索和保持利用之间取得平衡。

2.1 识别信息量大的“分叉” token

在一条完整的推理链中,许多 token 只是为了维持语法流畅性和格式正确性,而真正决定推理方向的,是少数关键的“分叉” token。在这些位置,模型面临多个逻辑上可能的选择,因此其输出的概率分布通常具有较高的熵(entropy)。

SimKO 正是利用了这一点。它只在那些 token 熵值超过一个预设阈值 的位置进行干预。这意味着 SimKO 的优化是有选择性的,它将计算资源集中在对探索行为影响最大的地方。通过这种方式,SimKO 可以被形式化地写为对原 GRPO 损失函数中优势项(advantage term)的修改:

其中,新的优势项 定义为:

这里 是在解码状态 时的策略熵, 是原始的优势值。 和 是 SimKO 针对正负样本设计的新的梯度计算方式。

2.2 正向梯度重分配:Top-K 标签平滑

对于一个来自正确推理路径()的高熵 token,传统的梯度更新会使其在反向传播时,将实际采样到的 token 视为唯一的“正确答案”(one-hot label),从而提升其概率,同时降低所有其他 token 的概率。如果 恰好是 rank-1 的候选者,这个过程就会不断加剧概率集中。

为了打破这个循环,SimKO 借鉴了标签平滑(label smoothing)的思想,但做出了关键的改进。传统的标签平滑会将一小部分概率质量均匀地分配给词汇表中的所有 token。然而,对于 LLM 巨大的词汇表来说,这样做会引入大量噪声,因为绝大多数 token 在当前上下文中都是无意义的。

SimKO 采用的是 Top-K 标签平滑。它只将概率重新分配给当前模型认为最可能的 K 个候选者。具体来说,它修改了梯度计算中的目标项。原始的 one-hot 目标 被替换为一个平滑后的目标 :

其中 是平滑系数, 是 top-K 候选者的索引集合。这种更新方式等价于一个新的损失函数,其对应的似然比 为:

这里 是 rank-k 候选者的似然比, 是停止梯度(stop-gradient)操作,用于保证重要性采样的无偏性。

直观地看,这个公式的作用是:在更新参数时,不仅要提升实际采样 token 的概率,还要以 的权重,同时提升 top-K 中所有候选者的概率。这会使得更新后的概率分布在顶端形成一个“平台”(plateau),而不是一个尖锐的“山峰”,从而为探索保留了更多的可能性。

2.3 负向梯度重定向:强化对 Top-1 的惩罚

对于来自错误推理路径()的高熵 token,传统的梯度更新会产生一个“挤压效应”(squeezing effect)。当模型试图降低采样到的错误 token 的概率时,它会不成比例地将这部分“释放”出来的概率质量,转移给当前概率最高的 rank-1 候选者。这无意中进一步强化了 rank-1 的主导地位,即便是在一条错误的路径上。(图 4c 负样本的策略)

为了解决这个问题,SimKO 采用了一种简单而有效的方法:当一个 rank-1 候选者出现在错误的路径上时,对其施加一个额外的惩罚。具体来说,当 是 rank-1 候选者时,其对应的似然比会被乘以一个大于 1 的超参数 :

通过放大对错误 rank-1 候选者的惩罚,SimKO 迫使模型将更多的概率质量从这个“错误的最优选”上移走,并分配给其他非 rank-1 的候选者。这有效地抑制了“挤压效应”,使得概率分布在受到负向反馈后,不会变得更加尖锐,反而有助于探索。

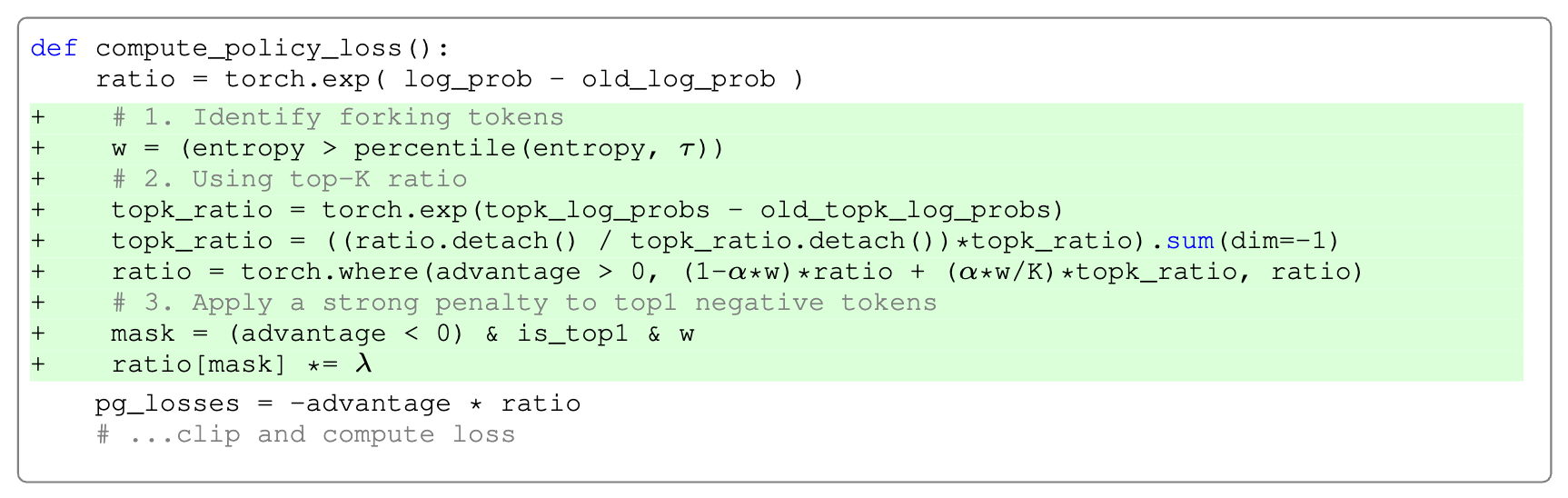

SimKO 的实现非常简洁,只需要在标准的策略梯度代码上修改几行即可,这使得它具有很高的实用性。

3. 实验

为了验证 SimKO 的有效性,作者在一系列数学和逻辑推理基准测试上,与多种基线方法进行了全面的比较。

3.1 实验设置

-

模型:实验涵盖了多种不同规模和架构的模型,包括 Qwen2.5-7B, Qwen2.5-Math-7B, 以及 Llama3.2-3B-Instruct。 -

数据集:训练数据集包括了数学领域的 MATH 和 GSM8K,以及逻辑推理领域的 Synlogic-easy。 -

评测基准:评估在多个广泛使用的基准上进行,包括数学领域的 MATH-500, Minerva Math, Olympiad-Bench, AMC, AIME,以及逻辑领域的 Synlogic-easy 和 BBH。 -

基线方法:比较对象包括基础模型(Base Model)、标准 GRPO、仅使用正样本的 PSR、仅使用负样本的 NSR、W-REINFORCE,以及其他旨在提升探索能力的方法,如 KL-Cov 和 Entropy-Adv。 -

评估指标:核心指标是 pass@K,其中 K 的取值范围从 1 到 256,以全面评估模型的利用和探索能力。

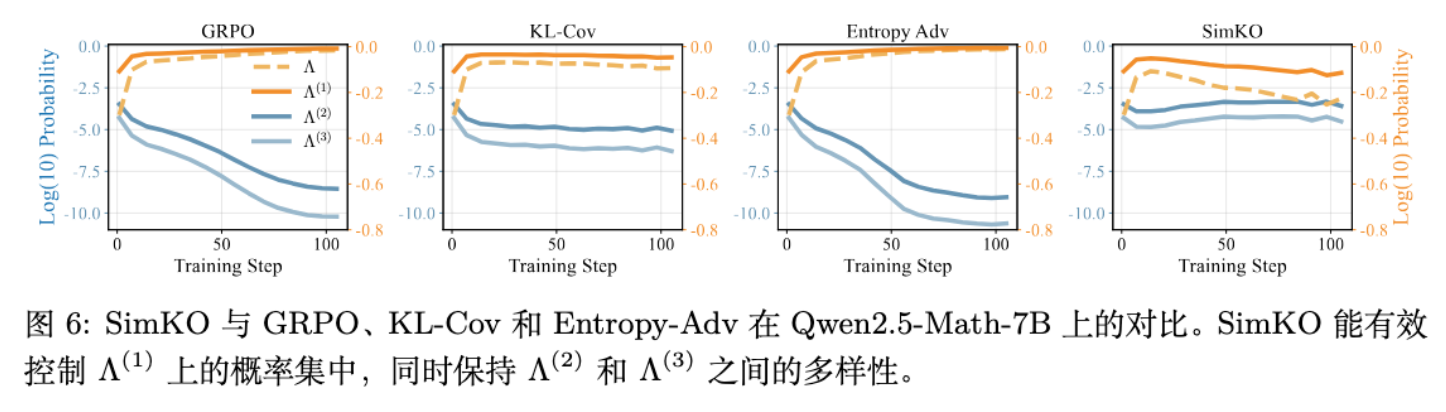

3.2 SimKO 对训练动态的影响

实验首先分析了 SimKO 对训练动态的影响。结果清晰地显示:

-

GRPO 导致了严重的过度集中, 迅速饱和,而 和 的概率急剧下降到接近于零。 -

KL-Cov 和 Entropy-Adv 等方法虽然尝试缓解这个问题,但效果有限,概率集中的趋势依然显著。 -

SimKO 在所有方法中,最有效地控制了概率的过度集中。其训练后的 值明显低于其他方法,而 和 则保持在较高的水平。

这表明 SimKO 成功地维持了 top-k 候选者之间的概率多样性,为模型的探索行为保留了潜力。

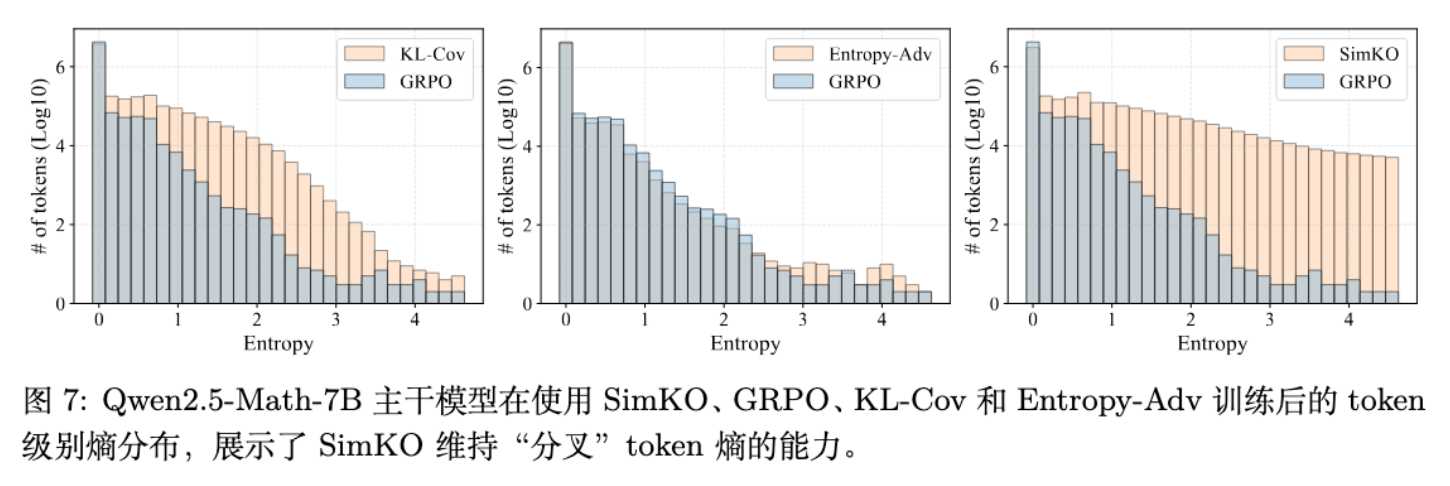

对 token 熵的直方图分析进一步证实了这一点。GRPO 的训练将绝大多数 token 的熵推向了零,而 SimKO 则能够保留大量高熵“分叉” token 的存在,这对于生成多样化的推理路径至关重要。

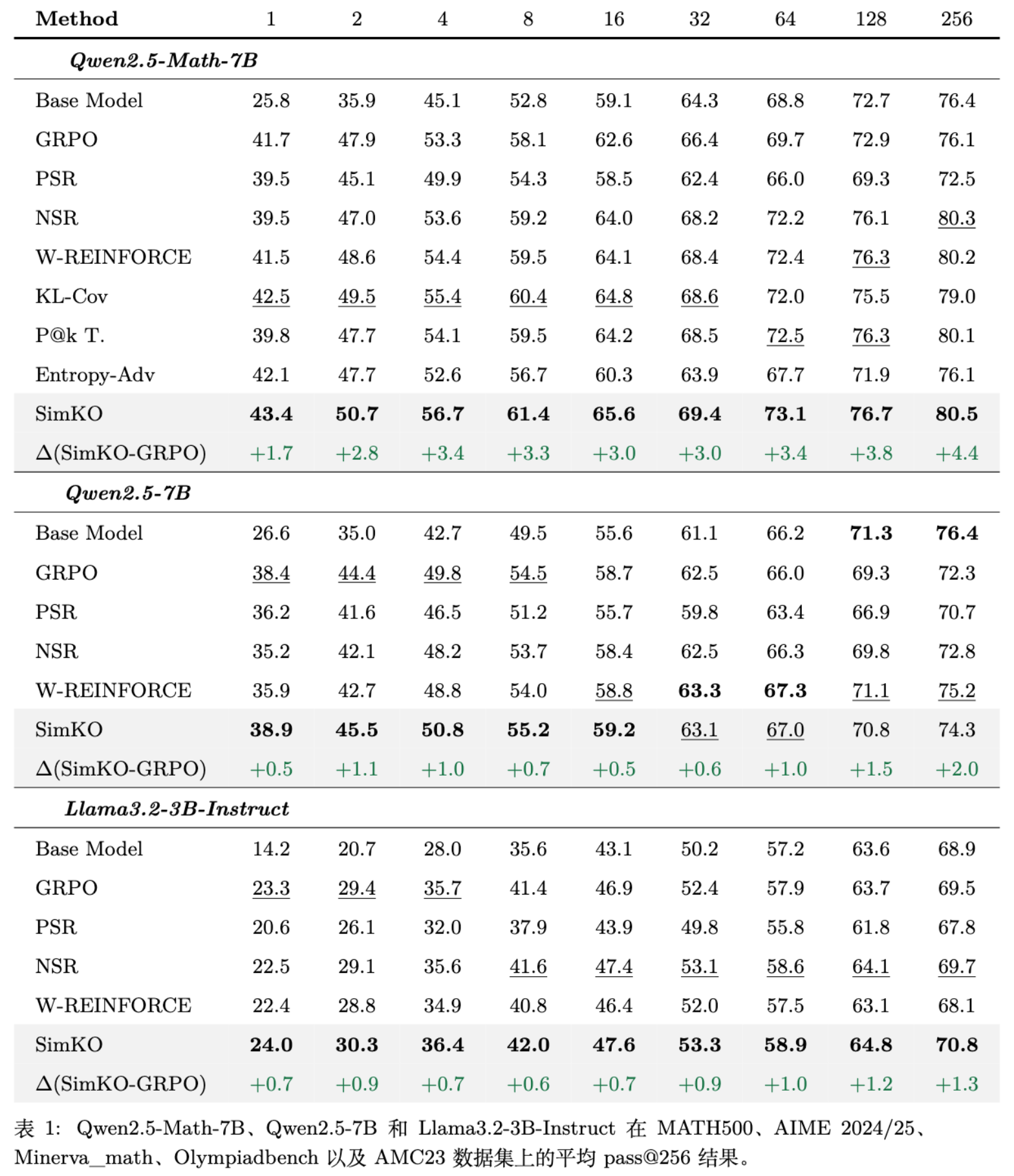

3.3 在数学推理基准上的表现

在跨越三个不同模型骨干的六个数学基准测试中,SimKO 展现出了一致且显著的优势。

-

与基础模型对比:SimKO 不仅提升了 pass@1 分数(例如,在 Qwen2.5-Math-7B 上提升了 17.6%),表明其利用能力得到加强;同时,它也提升了 pass@256 分数(提升了 4.1%),证明其探索能力和整体推理质量也得到了改善。 -

与 GRPO 及其变体对比:SimKO 在所有模型和所有 K 值上,都稳定地优于 GRPO、KL-Cov、Entropy-Adv 等方法。相较于 GRPO,SimKO 在 Qwen2.5-Math-7B 上的 pass@256 性能提升了 4.4%,在 Llama3.2-3B-Instruct 上提升了 1.3%,并且 pass@1 性能也更高。这说明 SimKO 实现了在不牺牲甚至增强“利用”能力的同时,大幅提升“探索”能力的目标。 -

平衡利用与探索:一些基线方法(如 NSR)虽然可能在 pass@256 上表现不错,但通常以牺牲 pass@1 为代价。SimKO 则在两者之间取得了更好的平衡,例如,在 Qwen2.5-Math-7B 上,SimKO 的 pass@1 (43.4%) 和 pass@256 (80.5%) 均优于 NSR (pass@1: 39.5%, pass@256: 80.3%)。

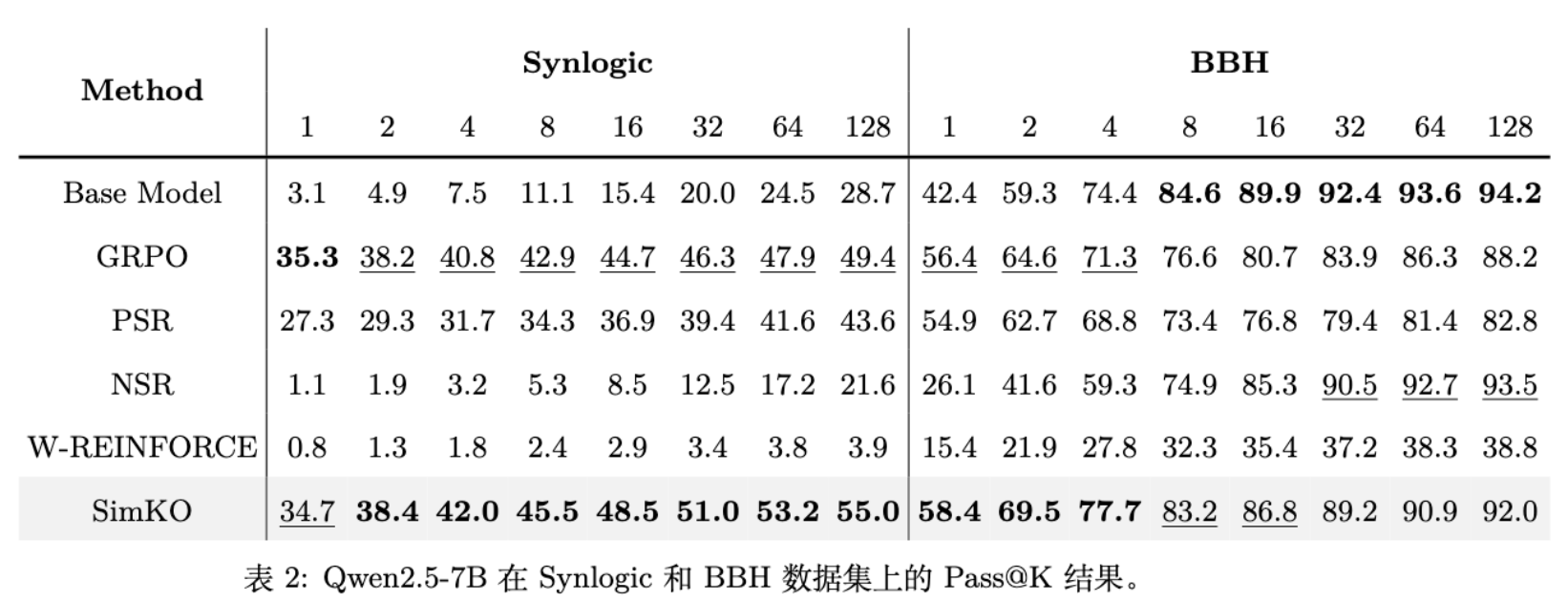

3.4 在逻辑推理任务上的泛化能力

为了测试 SimKO 的泛化能力,作者在两个逻辑推理任务上进行了评估,包括一个分布内任务(Synlogic)和一个分布外任务(BBH)。

-

Synlogic (In-distribution) :在这个任务上,基础模型表现很差。SimKO 带来了巨大的性能提升,pass@1 提升了 31.6%,pass@128 提升了 26.3%,并且显著优于 GRPO 和 PSR。相比之下,严重依赖负样本的 NSR 和 W-REINFORCE 在这个任务上几乎完全无法有效训练。 -

BBH (Out-of-distribution) :在这个任务上,SimKO 同样表现出色,将基础模型的 pass@1 从 42.4% 提升到 58.4%,并且在高 K 值时保持了性能的稳定性。相比之下,GRPO 和 PSR 的性能在 K 值增大时出现了明显下滑。

这些结果表明,单纯依赖负样本不足以在挑战性任务上提升 pass@K 性能。SimKO 通过其非对称的梯度调整策略,展现了强大的泛化能力和在困难任务上的有效性。

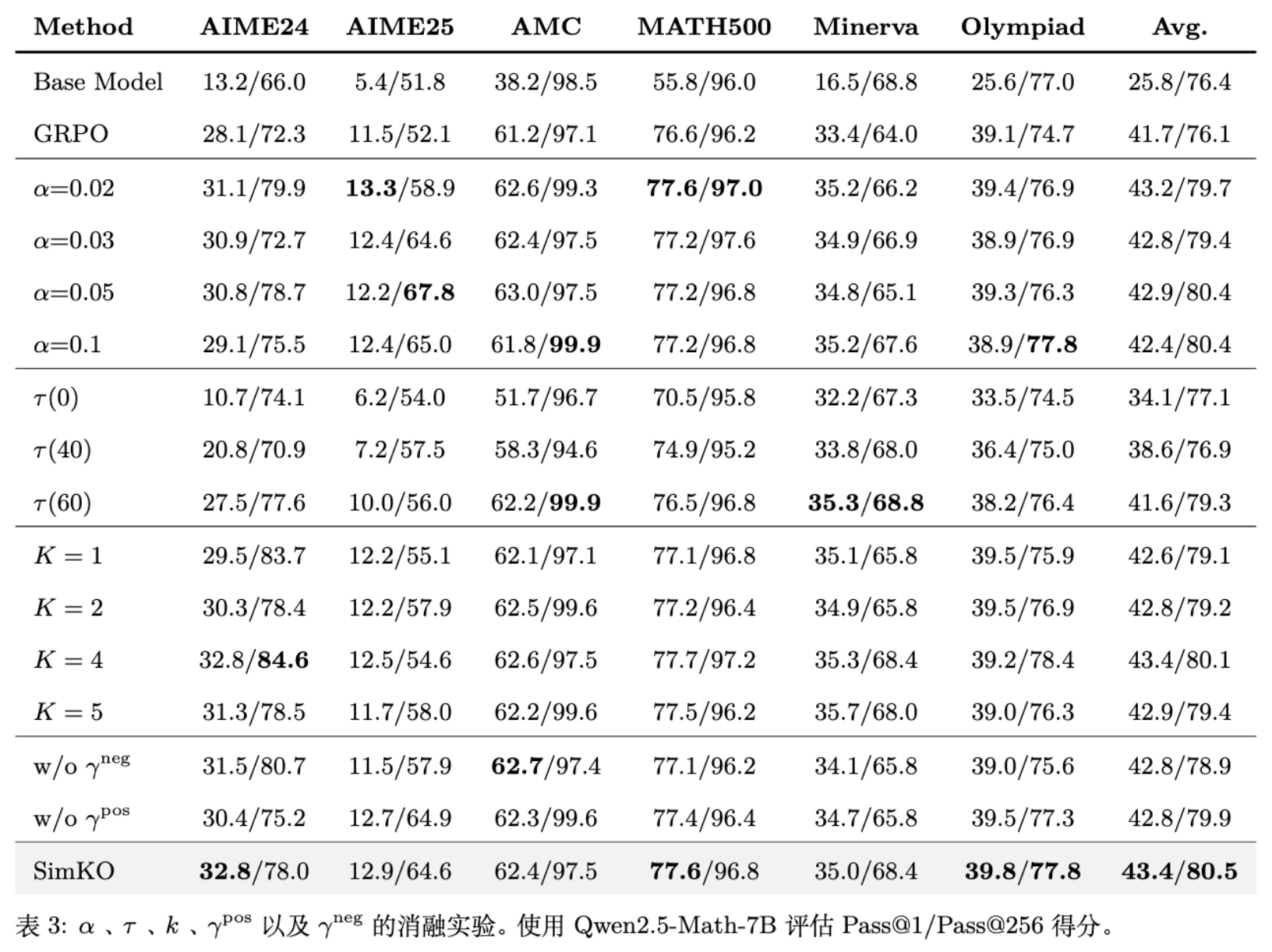

3.5 消融研究

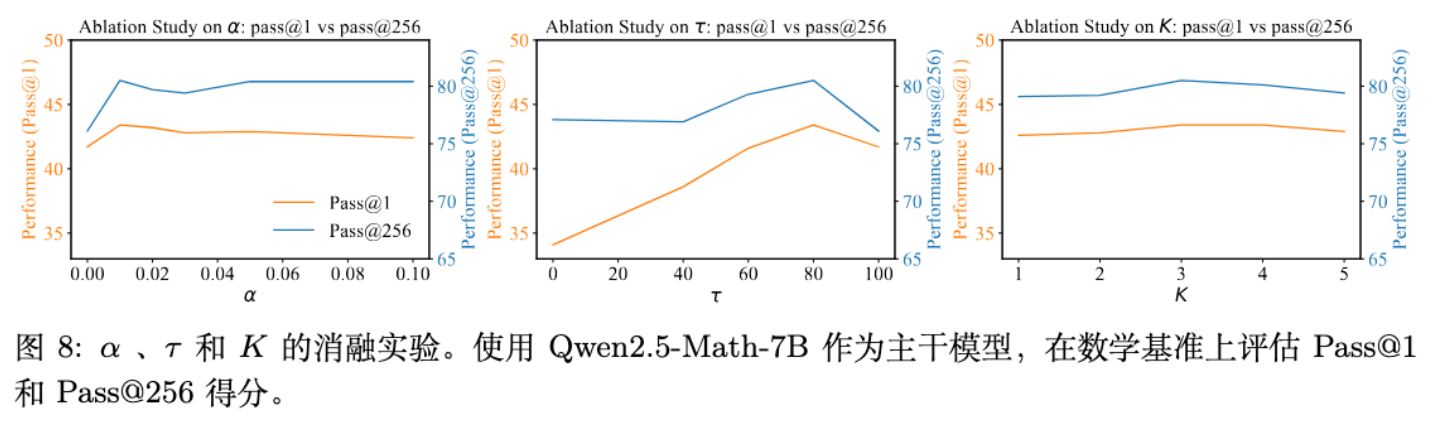

为了验证 SimKO 各个设计组件的必要性,作者进行了一系列消融实验:

-

平滑系数 的影响:随着 从 0(等价于 GRPO)增加,pass@256 性能单调提升。这证实了对正向梯度进行平滑是提升探索的关键。 -

熵阈值 的影响:实验表明,将 SimKO 的干预限制在高熵的“分叉” token 上(即 )比在所有 token 上都进行干预()能取得更好的 pass@1 性能。这说明了选择性优化的重要性。 -

Top-K 中 K 值的影响:实验发现,将 K 设置为一个较小的值(如 4 或 5)已经足够。过大的 K 值并不会带来持续的性能提升。 -

非对称更新的必要性:如果只对正样本或只对负样本应用 SimKO 的策略,模型的整体 pass@K 性能都会下降。这凸显了 SimKO 非对称设计的重要性,即同时温和地鼓励正确路径的多样性,并严厉地惩罚错误路径的“最优选”。

4. 总结

本文通过对 RLVR 训练动态的深入分析,揭示了当前方法中普遍存在的“过度专注”问题,即模型倾向于将概率质量过度集中在 rank-1 候选者上,从而抑制了探索能力并损害了 pass@K 性能。

为解决此问题,作者提出的 SimKO 算法,以其简洁而有效的设计,为平衡 LLM 推理中的利用与探索提供了新的思路。其核心贡献可以总结为:

-

新的分析视角:首次系统地采用追踪 top-K 候选者概率演变的方法,直观地揭示了 RLVR 中探索能力下降的根源,并建立了概率集中度与 pass@K 性能之间的负相关性。 -

简单而有效的算法:SimKO 通过识别高熵“分叉” token,并对其应用非对称的梯度调整策略(对正样本进行 top-K 标签平滑,对负样本强化 rank-1 惩罚),在不显著增加计算复杂度的前提下,有效缓解了概率过度集中的问题。 -

全面的性能提升:大量的实验证明,SimKO 在多种模型和任务上,都能在不牺牲 pass@1 的情况下,显著提升 pass@K 性能,超越了包括 GRPO 在内的多个基线方法,展现了更优的综合推理能力。

往期文章: