对于现代的大型语言模型(LLMs)而言,其核心挑战之一在于如何超越简单的文本生成,实现真正意义上的深度推理。目前,主流的推理增强方法,如思维链(Chain-of-Thought, CoT),主要在模型预训练完成后的微调或推理阶段介入。这种“后置”的推理模式,将推理过程视为一种通过显式文本生成来引导的“外挂”能力。它虽然在许多任务上取得了成功,但也暴露出根本性的局限:推理能力并未内建于模型的核心预训练阶段,导致模型在预训练过程中积累的海量数据和参数未被充分用于推理能力的塑造。 这种模式不仅效率偏低,而且推理过程往往是“事后归因”(post hoc)的合理化,而非真正驱动最终答案的因果路径。

我们能否将推理过程从预训练后的“附加件”转变为预训练阶段的“内生能力”?能否设计一种架构,让模型在学习语言模式的同时,就在其隐空间(latent space)中进行迭代式的、深度的计算与“思考”,从而在更根本的层面上构建其知识操控与推理能力?

来自字节 Seed 的论文《Scaling Latent Reasoning via Looped Language Models》,为解决这一问题提供了一个系统性的框架。他们提出并开源了一系列名为 Ouro(取义于衔尾蛇 Ouroboros 的递归意象)的预训练循环语言模型(Looped Language Models, LoopLM)。该工作不再将推理局限于显式的文本输出,而是通过在模型架构和训练目标上的创新,将迭代计算直接融入预训练过程。具体而言,Ouro 模型家族通过三大核心设计实现了这一目标:

-

隐空间中的迭代计算:通过一种参数共享的循环架构,模型可以在前向传播过程中对内部的隐状态(hidden states)进行多次、迭代的更新和精炼。这相当于在不增加模型参数量的前提下,极大地扩展了模型的计算深度。 -

用于学习深度分配的熵正则化目标:为了让模型能够根据输入内容的复杂性动态地决定需要进行多少次迭代计算,作者设计了一个熵正则化的训练目标。该目标鼓励模型学习一个“退出策略”(exit policy),为简单任务分配较少的计算资源,为复杂任务分配更多的计算资源,从而实现自适应计算。 -

扩展至 7.7T tokens 的大规模训练:为了验证 LoopLM 范式在真实世界规模下的有效性,研究团队在高达 7.7 万亿 tokens 的数据上对 Ouro 模型进行了预训练,并发布了 1.4B 和 2.6B 两种参数规模的模型。

-

论文标题:Scaling Latent Reasoning via Looped Language Models -

论文链接:https://arxiv.org/pdf/2510.25741

通过大量的实验,该研究系统地证明了 LoopLM 范式的优越性。Ouro 1.4B 和 2.6B 模型在众多基准测试中,其性能媲美甚至超越了参数量高达 12B 的主流 SOTA 模型。更重要的是,通过一系列对照实验,作者揭示了这种性能优势并非来源于知识存储容量的增加,而是源于一种根本上更强的知识操控(knowledge manipulation)能力。同时,LoopLM 所产生的推理轨迹,相比于显式的 CoT,与最终输出结果的因果关系更为紧密和忠实。这项工作为大模型推理能力的扩展,指明了一个与单纯增加参数量和数据量正交的、新的 scaling 方向。

1. LoopLM

为了理解 LoopLM 的工作方式,我们首先回顾标准的 Transformer 架构。一个标准的 层 Transformer 模型可以看作是 个不同函数(层)的顺序组合。它接收一个输入隐状态序列 ,并通过一系列由独立参数 参数化的层进行处理:

在这种结构中,计算图的深度与模型的层数(即参数量)是严格绑定的。增加计算深度意味着必须增加新的层和新的参数。

与之相对,LoopLM 的设计借鉴了 Universal Transformer 的思想,用对单个或一小组 Transformer 块的循环应用,来替代 个独立的层。假设我们有一个由参数 定义的 Transformer 块,LoopLM 的前向传播过程可以表示为对这个块进行 次重复更新:

这里的 被称为循环步数或循环深度。这种架构的核心思想是将计算深度()与参数量(由 决定)分离开来。模型可以在不增加任何新参数的情况下,通过增加循环次数 来深化其计算过程。

这套架构可以从两个互补的视角来理解:

作为参数共享的模型效率提升机制

从这个角度看,LoopLM 是一种极致的参数共享策略。一个或多个 Transformer 块(或其子模块,如注意力、FFN)在模型的深度方向上被重复使用。这种设计大幅减少了模型所需的总参数量,同时保持了计算图的深度。在 LLM 时代之前,参数共享在 ALBERT 等模型中被广泛用于压缩模型。随着模型规模的增长,参数共享的理念一度被淡化,但现在,为了在有限的硬件资源(尤其是在边缘设备上)部署 LLMs,它重新获得了关注。LoopLM 将这一理念推向了新的层次,实现了计算与参数的有效解耦。

作为潜在推理和迭代优化的过程

从这个角度看,LoopLM 的每一次循环迭代,都可以被视为一次在潜在空间中进行的非语言“思考”步骤。在每一步 ,模型都会基于前一步的隐状态 对其内部表征进行优化和提炼,从而生成新的隐状态 。整个过程 构成了一个潜在的思维链,它逐步地求解任务,而无需生成任何中间的文本。经验上,增加循环步数 能够提升模型在复杂推理任务上的性能。这种隐式的、在潜在空间中进行的迭代计算,与 CoT 等通过显式文本生成来进行推理的方式形成了对比。

综合来看,LoopLM 的设计旨在通过复用计算,在不增加参数量的前提下提升模型的推理能力,将扩展的重心从“规模”(scale)转向了“实质”(substance)。

2. 自适应计算

LoopLM 架构的一个核心优势在于其支持自适应计算(adaptive computation)的潜力。在实际应用中,并非所有的输入都需要同样深度的计算。简单的输入可能只需要少数几次循环就能处理,而复杂的输入则需要更多的迭代来提炼表征。如果能让模型根据输入的难度动态调整循环次数 ,就可以在保证性能的同时,优化计算资源的分配,实现效率的最大化。

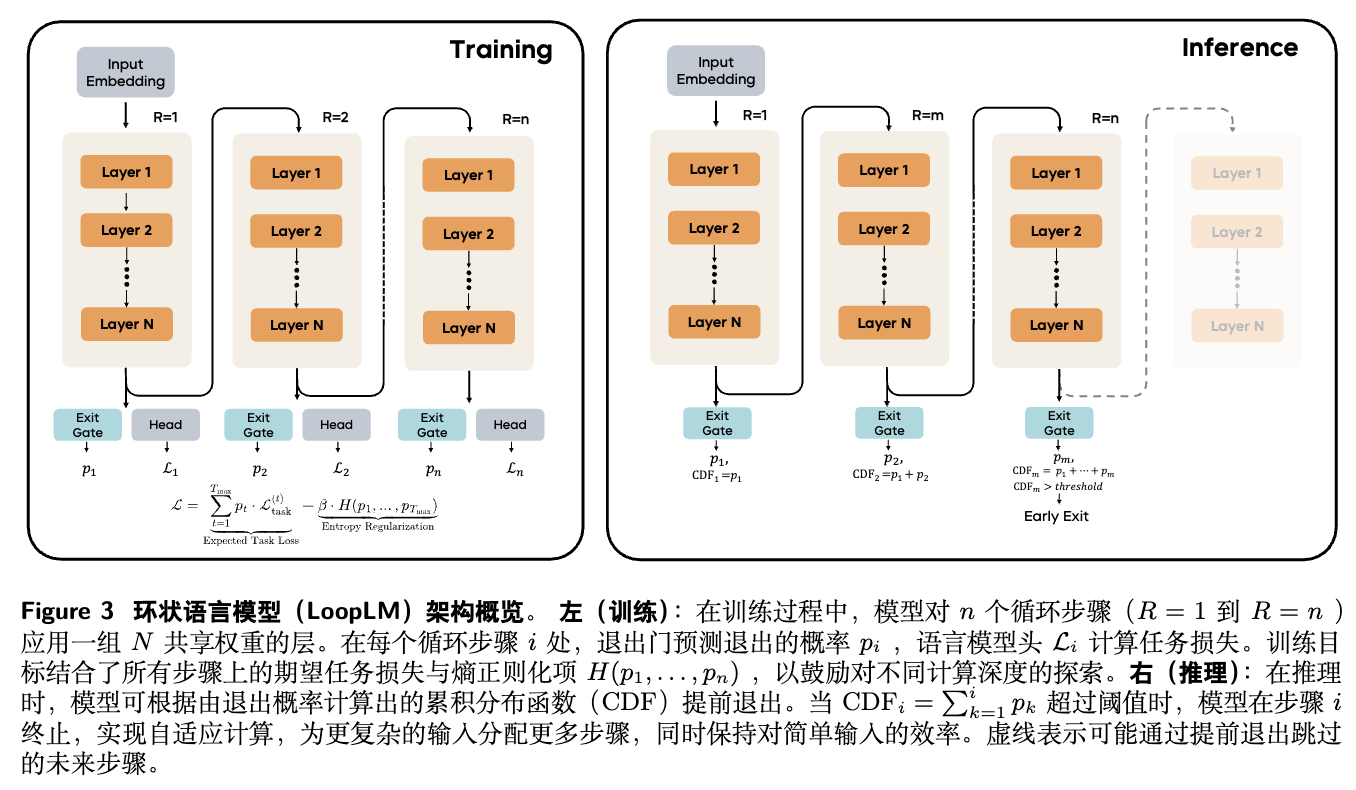

为了实现这一目标,Ouro 的设计中引入了一套学习自适应潜在推理的机制。其整体架构在训练和推理阶段的工作方式如图 3 所示。

3.1 LoopLM 架构形式化定义

我们首先形式化地定义 LoopLM。令 表示一个由参数 定义的因果 Transformer 层,其中 是隐藏维度, 是输入长度。 是语言模型头, 是词汇表, 是词嵌入层。

一个标准的 层 Transformer 模型 可以表示为:

而一个循环 步的 LoopLM 模型 定义为:

其中 是一个共享参数的 Transformer 块(在 Ouro 中包含 层)。给定一个输入序列 ,LoopLM 在第 步的预测损失为标准的交叉熵损失:

3.2 通过门控机制实现自适应计算

为了让模型自主决定循环次数,研究者们引入了一个门控机制。在每个循环步骤 ,一个退出门(exit gate)会根据当前的输入 和隐状态 预测一个退出的概率 。基于这一系列概率 ,模型可以计算出一个关于退出步骤的分布 ,并决定是继续循环还是终止计算并输出结果。

具体来说,Ouro 采用了基于累积分布函数(CDF)的 Q-exit 准则。在每个步骤 ,模型计算累积退出概率:

其中 表示在第 步精确退出的概率。当 超过一个预设的阈值 时,模型就在第 步退出:

这个阈值 成为了一个控制计算量与精度权衡的超参数。较低的 值会鼓励模型更早退出,而较高的 值则允许更深度的计算。门控函数 的学习分为两个阶段。

3.3 阶段一:学习熵正则化目标

为了训练出一个既能有效退出,又能保持高性能的 LoopLM,训练目标需要同时优化任务精度和计算效率。Ouro 的训练目标函数结合了所有循环步骤的期望任务损失和一个熵正则项:

其中 是退出分布的熵。超参数 控制着探索与利用的权衡:

-

较大的 会鼓励一个更均匀的退出分布(高熵),促使模型探索不同的计算深度。 -

较小的 则允许分布更集中,当模型对某个输入的最佳深度有较高置信度时,可以将概率质量集中在少数几步。

从变分推断的角度来看,这个目标等价于在一个以退出步骤为隐变量的模型中,最小化一个证据下界(ELBO),并且假设该隐变量的先验分布 是一个均匀分布。

当 时,最小化 KL 散度等价于最大化熵。

为何选择均匀先验?

这是一个关键的设计选择。以往的工作(如 PonderNet)通常采用几何分布或泊松对数正态分布作为先验。这些先验分布都内含了一个强烈的归纳偏置,即偏好浅层计算,将更多的概率质量分配给较早的退出步骤。作者认为,这种做法混淆了两个目标:1)根据输入难度学习何时退出;2)最小化平均计算成本。这种偏置可能会阻碍模型对深层计算的充分探索,从而无法完全释放循环架构的潜力,尤其是在复杂的推理任务中。

相比之下,均匀先验不对最佳退出深度做任何预设的假设。它平等地优化所有深度,让模型完全从数据中学习不同输入的计算需求。这对于需要深度推理的复杂任务尤为重要,因为最佳深度本身就是需要模型学习的一部分,而不应被先验所束缚。

3.4 阶段二:专注的自适应门控训练

传统的做法通常将门控机制视为一个辅助模块。Ouro 的第二阶段训练则直接优化退出门,使其能够根据实际的性能提升来做出终止决策。其核心思想是,如果增加一次循环带来的性能提升不大,模型就应该选择退出。

具体来说,在每个 token 位置 ,模型计算从步骤 到 的损失改进量 :

其中 表示损失计算时梯度被截断,以确保这个阶段只优化门控,而不影响语言模型本身的表征。

当 很小时,意味着性能改进已经停滞。模型基于此计算一个理想的继续概率 :

其中 是斜率(如 50.0), 是改进阈值(如 0.005)。当损失改进 时, 较大,模型倾向于继续;反之则倾向于退出。自适应退出损失 是一个加权的交叉熵,它使得在步骤 的门控预测 与理想的继续概率 相匹配:

这个损失函数同时惩罚两种错误:

-

思考不足 (Underthinking) :在应该继续时( 大)却选择停止( 大)。 -

思考过度 (Overthinking) :在应该停止时( 小)却选择继续( 小)。

通过这个两阶段的训练过程,Ouro 的门控机制学会了在计算效率和模型性能之间进行权衡。

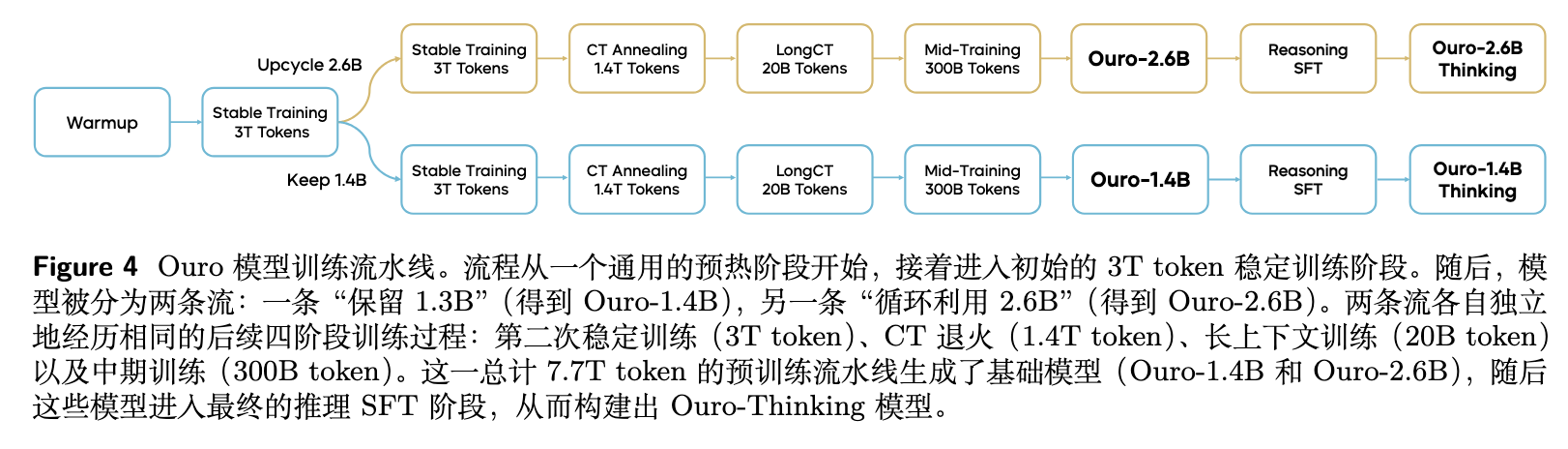

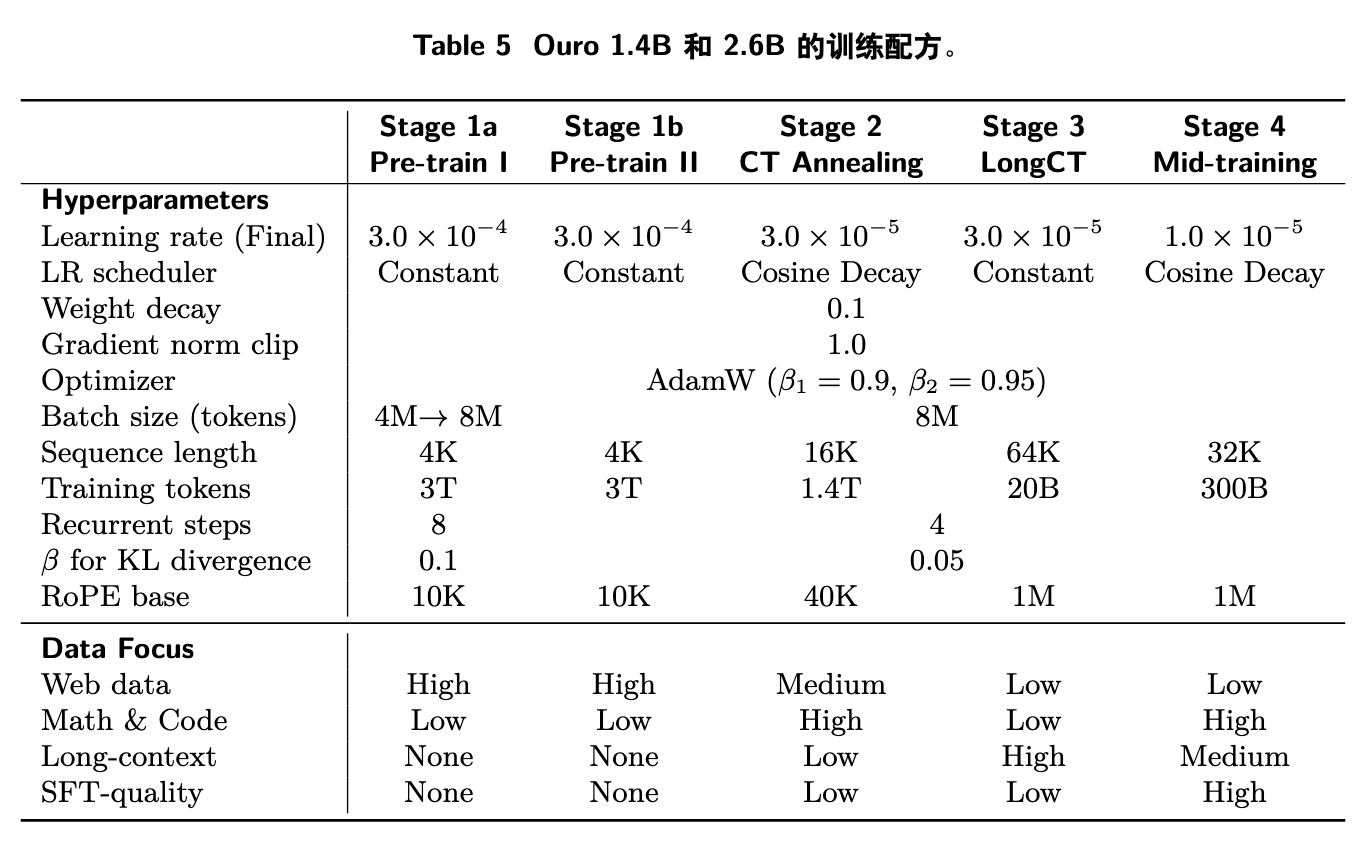

4. 训练细节与对齐探索

Ouro 模型的训练是一个复杂的多阶段流程,总计在 7.7T tokens 的数据上进行,旨在系统性地构建并优化其潜在推理能力。整个流程不仅包括了多阶段的预训练,还探索了监督微调(SFT)和强化学习(RL)等对齐技术。本节将对此进行详细解析。整个流程的概览如下图所示。

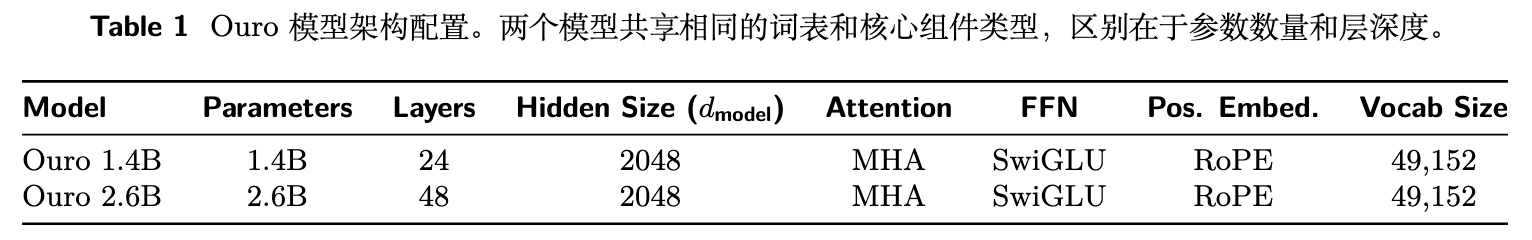

4.1 Transformer 架构

Ouro 模型基于标准的 decoder-only Transformer 架构,其核心是一个可被循环应用的 Transformer 块栈。为了确保深度循环计算的稳定性和效率,其架构进行了一些关键选择:

-

注意力机制:采用带有 Rotary Position Embeddings (RoPE) 的 Multi-Head Attention (MHA) 来处理序列顺序。 -

前馈网络:使用 SwiGLU 激活函数以提升计算效率。 -

归一化:采用了三明治归一化结构(sandwich normalization)。具体来说,在注意力子层和 FFN 子层之前都放置一个 RMSNorm 层。这种结构在以往的循环 Transformer 研究中被证明有助于提升深度循环计算的稳定性。

模型的具体配置见下表。两个模型(1.4B 和 2.6B)共享一个从 SmolM2 复用的,包含 49,152 个 token 的词汇表,该词汇表主要针对拉丁字母语言和代码进行了优化。

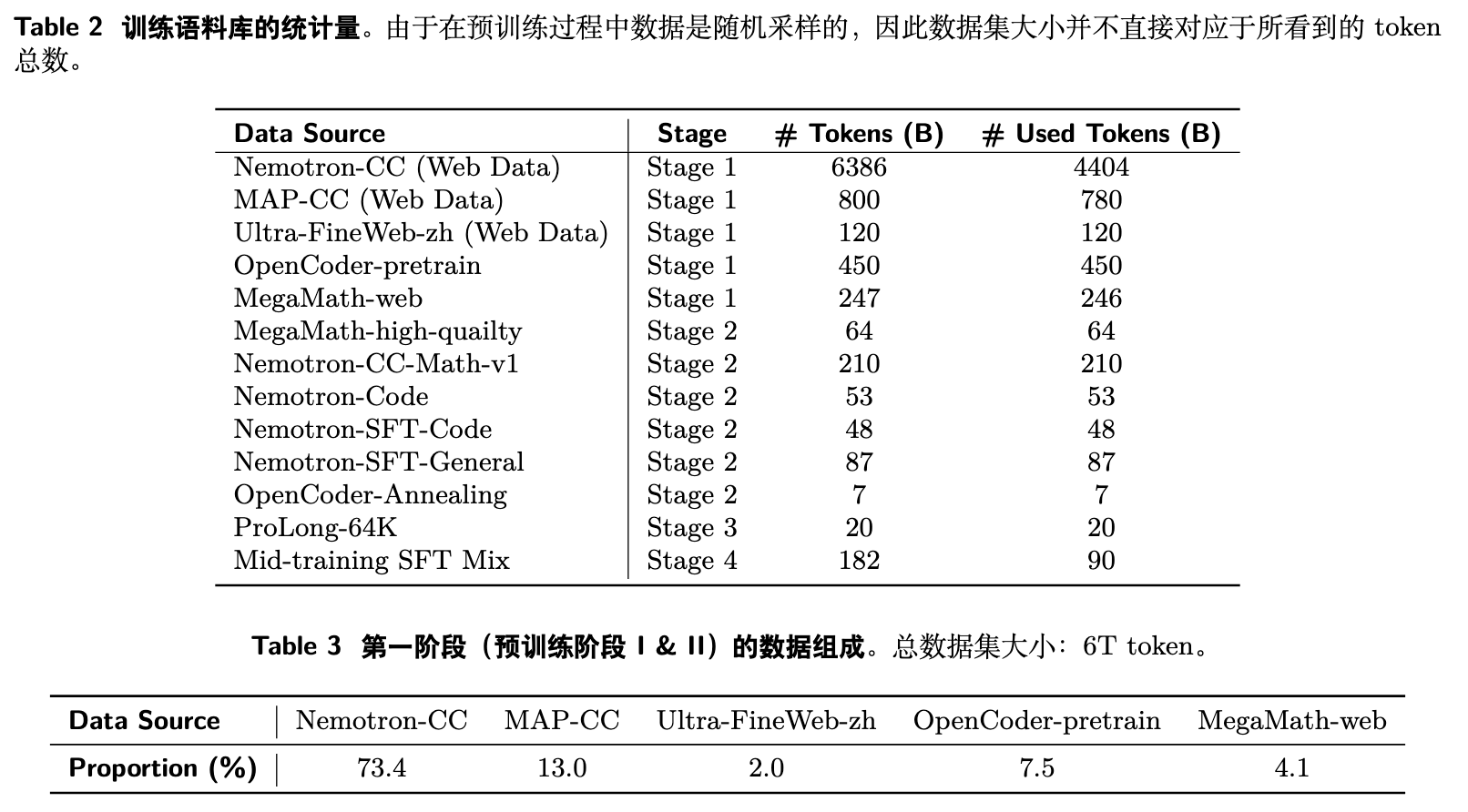

4.2 数据构成

为了保证可复现性,模型的训练语料库完全由开源数据集构成,根据训练目标的不同分为四个主要阶段。

-

阶段一 (预训练) :此阶段是训练的 warmup 和稳定阶段,数据总量为 6T tokens。主要由 Web 数据构成,包括 Nemotron-CC (73.4%) 和 MAP-CC (13.0%)。为了增强编码和数学能力,还引入了 OpenCoder-pretrain (7.5%) 和 MegaMath-web (4.1%)。此外,为了提供基础的中文能力,还包含了少量中文数据 Ultra-FineWeb-zh (2.0%)。具体构成见表 3。 -

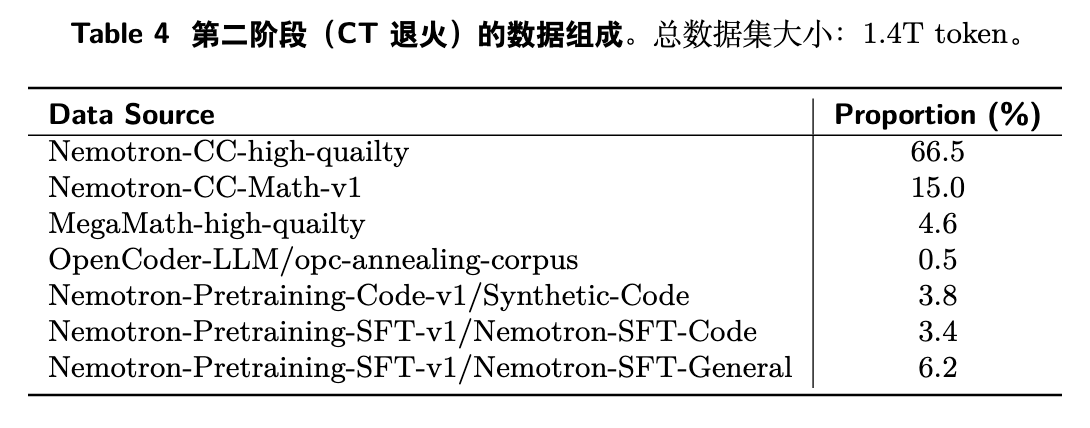

阶段二 (持续训练与退火) :在学习率退火阶段,模型使用更高质量的数据进行持续训练,数据总量为 1.4T tokens。数据源包括 Nemotron-CC 的高质量子集、数学和代码数据集等。具体构成见表 4。 -

阶段三 (长上下文训练) :此阶段使用 ProLong 数据集的 64K 长度子集(20B tokens)来扩展模型的长上下文处理能力。 -

阶段四 (中期训练) :此阶段使用一个包含 20 多个开源 SFT 数据集的混合体(总计 182B tokens,采样 90B tokens 进行训练),进一步提升模型的高级能力。

4.3 多阶段预训练流程

整个训练流程将稳定性置于优先地位,并针对循环架构的特点进行了调整。所有阶段的最大循环步数被设定为 4。

-

阶段 1a: 预训练 I (探索阶段)

-

在 3T tokens 的 web 数据上进行训练,初始设定最大循环步数为 8。 -

学习率采用 Warmup-Stable-Decay (WSD) 调度器。 -

序列长度为 4K,批次大小从 4M tokens 逐步增加到 8M tokens。 -

在此阶段,研究者观察到训练存在不稳定性,表现为损失尖峰和梯度振荡。他们推测这源于梯度在多次循环迭代中累积,放大了微小的扰动。这促使他们调整了架构。

-

-

阶段 1b: 预训练 II (稳定性驱动的架构调整与 Upcycling)

-

为解决稳定性问题,将最大循环步数从 8 减少到 4。作者发现这是计算深度和训练稳定性之间的一个平衡点。 -

模型在此被分为两个分支: -

变体 1: 1.4B 模型,保持 24 层,4 次循环。 -

变体 2: 2.6B 模型,通过层堆叠(layer stacking)创建,层数增加到 48 层,4 次循环。由于权重共享的循环特性,这种 upcycling 过程(在现有模型基础上增加层数)比标准 Transformer 更平滑,不易引入标准 Transformer upcycling 中常见的不稳定性。

-

-

两个变体都在额外的 3T tokens 数据上进行训练,配置更为稳定。

-

-

阶段 2: CT Annealing

-

在阶段 1b 的稳定基础上,引入更高质量的数据,并将学习率退火至 。 -

序列长度增加到 16K,以更好地利用高质量数据。

-

-

阶段 3: LongCT

-

在 20B tokens 的 ProLong-64K 数据集上训练,序列长度为 64K,批次大小 8M。 -

KL 散度系数 被降低到 0.05,以在长序列上保持稳定的训练动态。

-

-

阶段 4: Mid-training

-

利用 90B tokens 的高质量 SFT 数据进行训练,学习率进一步降低至 。

-

整个训练流程的超参数配置详见下表。

4.4 SFT

在多阶段预训练之后,生成的 Ouro-1.4B 和 Ouro-2.6B 基础模型会经过一个专门的 SFT 阶段,以创建最终的、面向推理任务的 Ouro-Thinking 模型。

-

数据构成:SFT 语料库包含约 8.3M 个高质量样本,覆盖四个关键领域:数学 (3.5M)、代码 (3.2M)、科学推理 (808K) 和对话 (767K)。 -

训练配置:使用 LlamaFactory 代码库进行训练,共 2 个 epoch,最大序列长度为 32K。采用 Adam 优化器,学习率为 ,并应用 cosine 衰减策略。

4.5 RL 探索

在 SFT 之后,许多先进的 LLM 会通过强化学习(如 RLHF)进行进一步对齐。Ouro 的研究者们也探索了这条路径,他们尝试使用 RLVR(Reinforcement Learning with Verifiable Rewards)框架下的 DAPO 和 GRPO 等算法,在 DAPO-17K 数据集上进行对齐实验。然而,这些尝试并未能在最终的 SFT checkpoint 基础上带来显著的性能提升。

研究者们将此归因于两个主要原因:

-

模型能力饱和 (Model Saturation) :Ouro 模型本身参数量较小(1.4B 和 2.6B),并且已经经过了大规模、多阶段的预训练和广泛的 SFT。这可能已经使其在特定能力维度上达到了饱和状态,为强化学习留下的可提升空间有限。

-

基础设施挑战 (Infrastructure Challenges) :这是更根本的技术障碍。LoopLM 独特的架构给现有的 RL 基础设施带来了挑战。研究团队的 RL 系统基于 vLLM,该系统在处理 LoopLM 的核心特性——动态提前退出(dynamic early exit)——时遇到了困难。

-

在 RL 的 rollouts(模型生成体验样本)阶段,vLLM-based 系统无法高效地处理每次输入都可能有不同循环深度的动态计算图。 -

更重要的是,系统无法将这种变化的深度信息有效地用于后续的更新步骤。 -

这迫使研究者们采取了折衷的方案来进行实验。

-

他们探索了两种具体的 RL 策略:

-

策略一:固定4轮循环的强化学习 (Fixed 4-Round RL)

-

方法:为了规避动态计算图的问题,研究者强制在 rollouts 和模型更新时都使用固定的 4 次循环。 -

结果:在这种设置下,模型的性能表现出正常的增长趋势,但最终未能超越 SFT checkpoint 的水平。这意味着 RL 过程有效,但没有带来额外的收益。 -

一个有趣的发现:即使在固定深度下进行训练,模型在推理时仍然可以利用较少的循环次数,表现出 RL 目标所激励的行为。这种泛化能力背后的原因尚不明确。

-

-

策略二:自适应强化学习 (Adaptive RL)

-

方法:尝试使用模型原生的自适应提前退出机制来进行 rollouts 和更新。 -

结果:该方法未能带来性能提升。研究者认为,这主要是由于基础设施在处理动态计算图时面临的挑战所致。

-

总而言之,对 RL 的探索实践表明,尽管 LoopLM 架构在参数效率上表现优异,但其动态计算的特性也对现有的对齐工具链(特别是 RL 框架)提出了新的要求。要为这类新型架构成功实施 RL 对齐,可能需要对底层的训练和推理基础设施进行相应的开发和适配。

5. 实验

论文对 Ouro 基础模型和经过 SFT 的 Ouro-Thinking 模型进行了全面的评估。

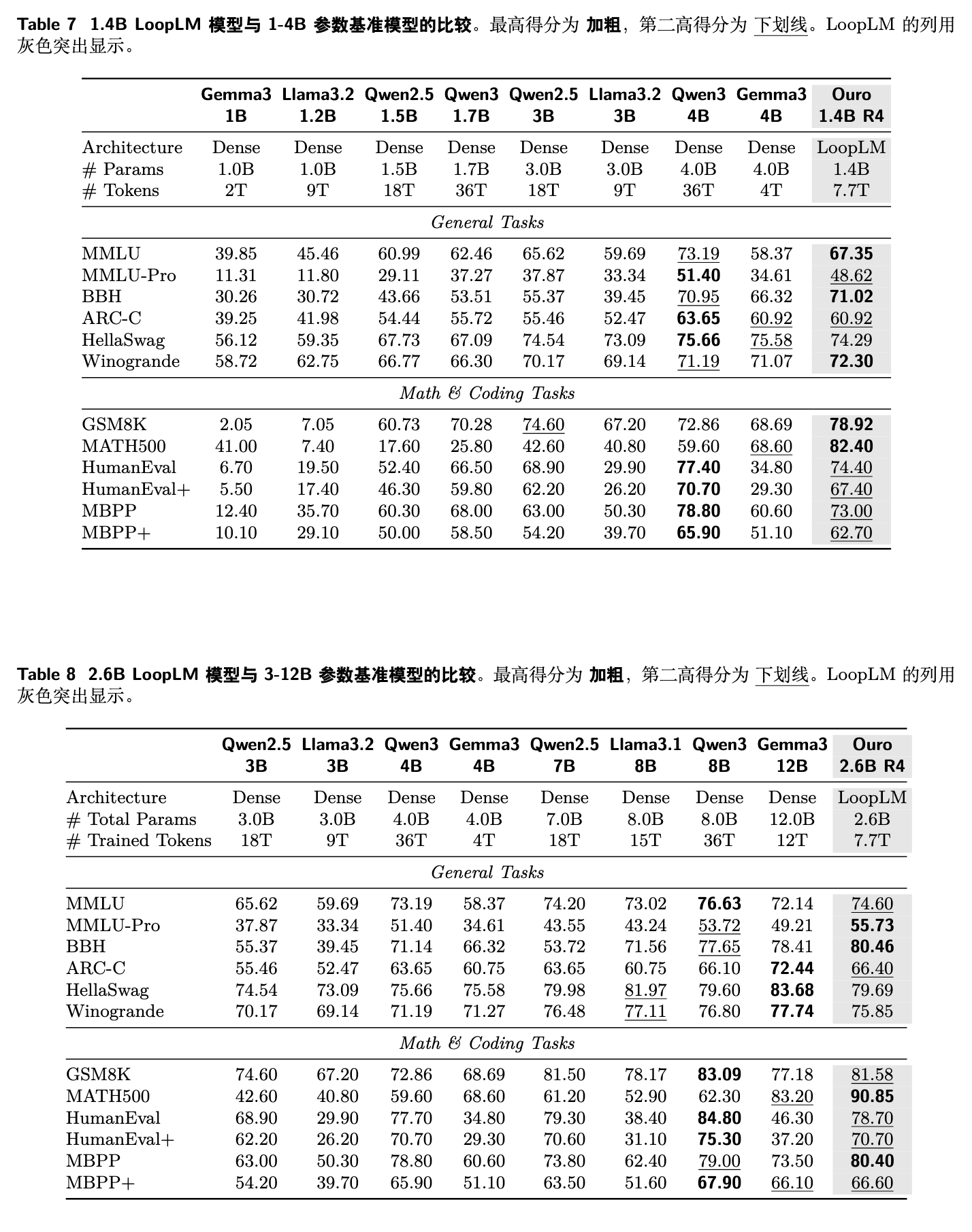

5.1 基础模型评估

评估的重点是 Ouro 模型与参数量更大、业界领先的开源基础模型(如 Qwen3, Gemma3, Llama3.2)的性能对比。

-

Ouro 1.4B R4 (4 次循环) vs. 1-4B 基线模型 (表 7)

-

Ouro 1.4B 的性能与 4B 参数的 Qwen3-Base 相当。 -

在需要深度推理的挑战性任务上,其表现尤为突出,例如在 BBH (71.02 vs 70.95), GSM8K (78.92 vs 72.86) 和 MATH500 (82.40 vs 59.60) 等基准上,其性能持平或超过了 4B 模型。

-

-

Ouro 2.6B R4 vs. 3-12B 基线模型 (表 8)

-

Ouro 2.6B 的性能超过了参数量高达 8B 的模型,尤其是在推理密集型基准上。 -

例如,它在 MMLU-Pro 上得分 55.73,BBH 上得分 80.46,MATH500 上得分 90.85,均超过了 8B 的 Qwen3-Base (得分分别为 53.72, 77.65, 62.30)。

-

这些结果清晰地表明,LoopLM 架构实现了显著的参数效率提升。通过迭代计算,小参数量的模型获得了与大参数量模型相匹敌甚至更强的推理能力。

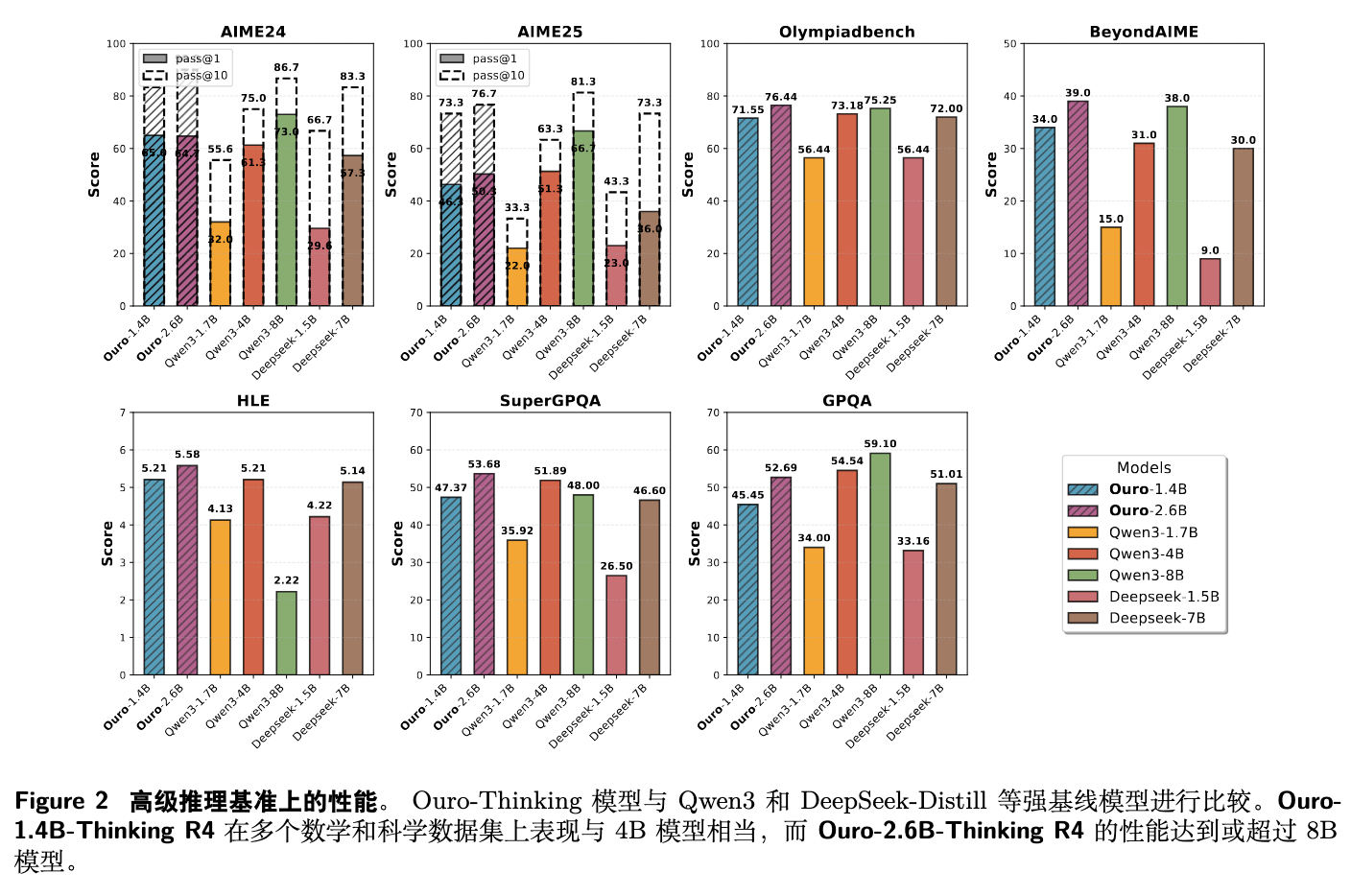

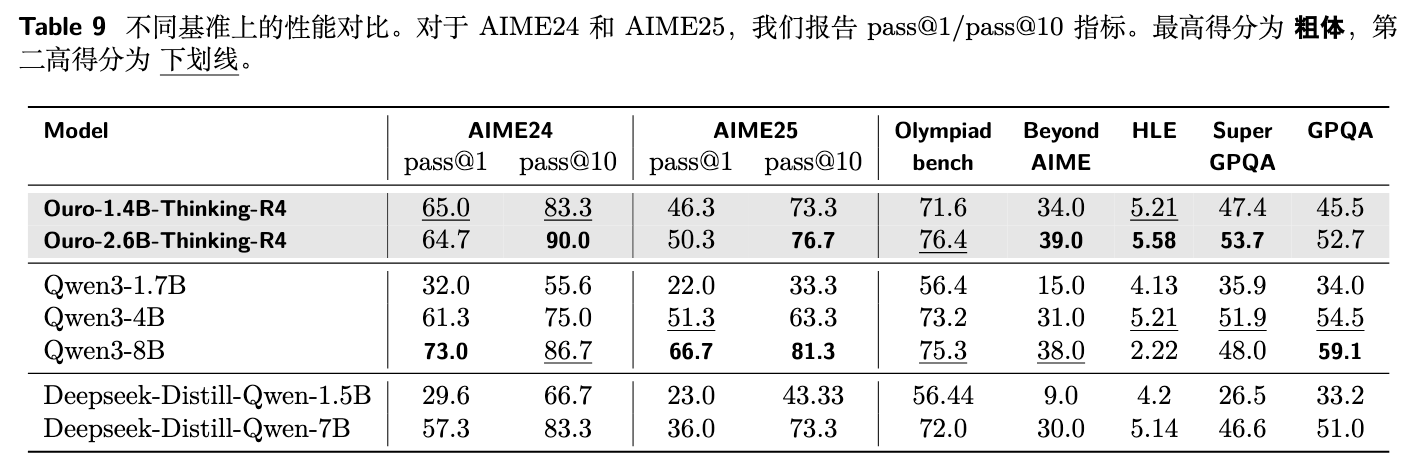

5.2 推理模型评估

Ouro-Thinking 模型在一系列高难度的数学和科学推理基准上进行了评估,包括 AIME 2024/2025, OlympiadBench, GPQA, SuperGPQA, BeyondAIME 和 HLE。结果如图 2 和表 9 所示。

结果显示,Ouro-Thinking 模型表现出很强的竞争力。例如,Ouro-1.4B-Thinking R4 的性能与 4B 的 Qwen3 模型相当,而 Ouro-2.6B-Thinking R4 的性能则能达到或超过 8B 模型的水平。这再次验证了循环架构在复杂推理任务上的优势。

5.3 按循环深度的性能分析与外推

为了探究循环深度对模型性能的动态影响,研究者们分析了模型在不同循环计算深度( 到 )下的表现。需要强调的是,由于模型训练时的最大循环深度被设定为 ,因此在 到 步的评估属于外推(extrapolation),即测试模型在训练时未曾见过的更深计算领域中的泛化能力。这一分析分别针对基础模型和经过 SFT 的推理模型进行。

-

基础模型性能分析

-

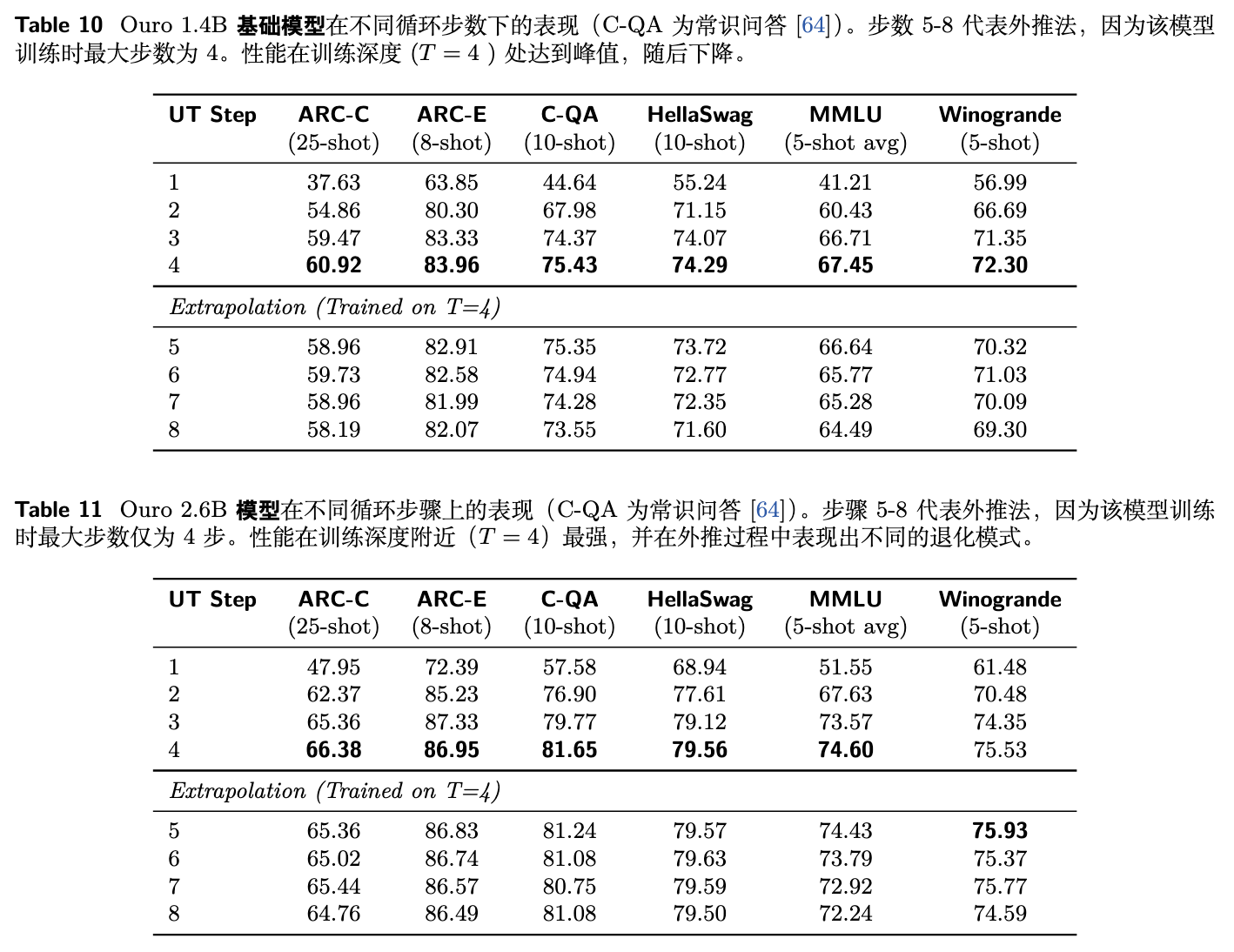

表 10、11 分别展示了 Ouro 1.4B 和 2.6B 两个基础模型的详细性能数据。两个模型表现出高度一致的规律: -

性能随深度提升:在标准基准(如 MMLU, ARC-C, HellaSwag)上,模型的性能通常随着循环步数的增加而显著提升,并在训练时设定的最大深度 附近达到峰值。例如,对于 Ouro 2.6B 模型(见表 11),MMLU 的平均 5-shot 准确率从 时的 51.55% 稳步增长到 时的 74.60%。这证明了迭代计算对于提升基础模型能力的核心作用。 -

外推性能下降:当外推到更深的 时,任务性能出现了一定程度的平缓下降。继续以 Ouro 2.6B 为例,其 MMLU 性能从 的峰值 74.60% 逐渐下降到 时的 72.24%。虽然性能有所回落,但仍远高于浅层计算(如 )时的水平。 -

这一现象清晰地表明,基础模型的性能被最优化到了其在训练期间所经历的计算深度范围。模型学会了在 4 次循环内有效解决问题,但并未能自动泛化到需要更多次迭代才能带来性能提升的场景。

-

-

SFT 推理模型性能分析

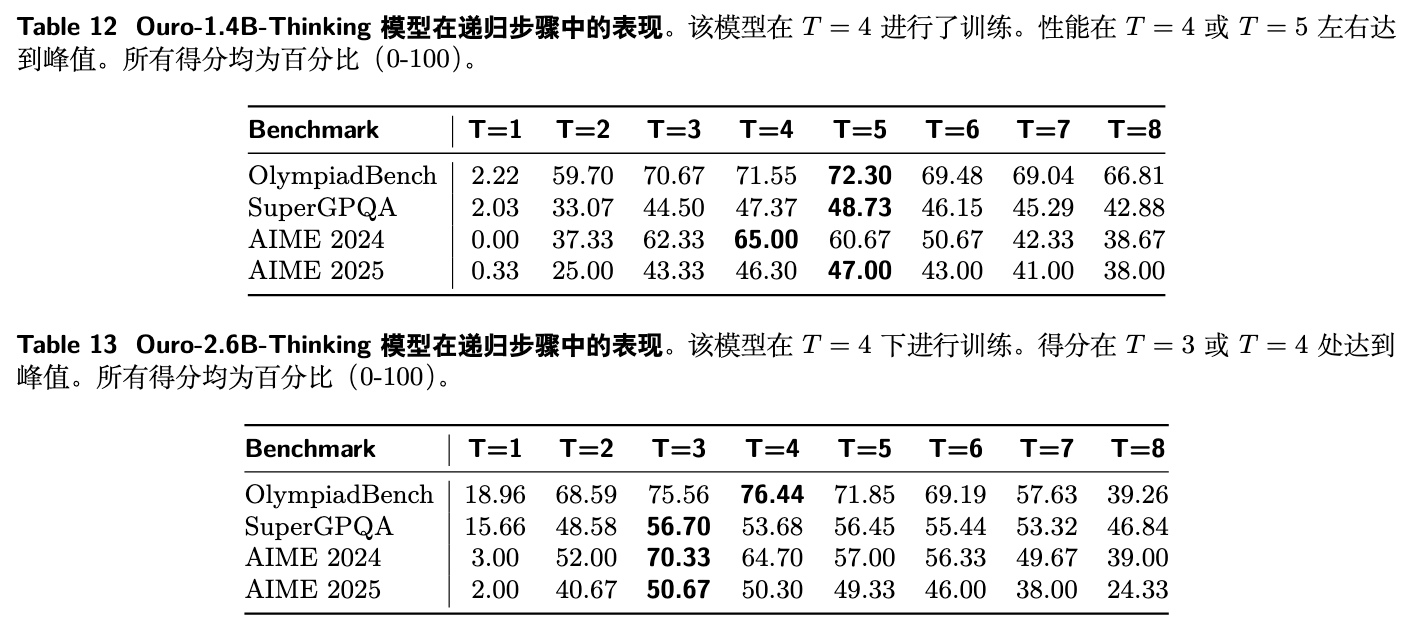

-

表 12、13 展示了 SFT 后的模型在专业推理任务上的表现。 -

迭代的必要性:对于 SFT 模型,在 时性能表现很低,这证实了对于复杂的、需要多步分解的推理任务,单次计算是不足够的,迭代优化过程是必不可少的。 -

峰值性能点:性能通常在 或 附近达到峰值,与基础模型的表现略有不同。例如,Ouro-2.6B-Thinking 模型在 AIME 2024 和 SuperGPQA 任务上均在 时达到最高分。这可能是因为推理任务的解码过程更长,允许模型在不同的循环深度上进行更主动的能力探索。 -

外推性能下降更显著:与基础模型相比,SFT 模型在外推到 时,性能下降得更为明显。这进一步印证了模型的性能被优化到了训练时所见的深度,对于需要精确推理的任务,偏离这个优化区域会导致能力下滑。

-

6. LoopLM 为何更擅长“操纵”知识而非“存储”知识?

Ouro 模型的优异表现引出了一个核心问题:为什么在参数量不变的情况下,增加循环次数能带来性能提升?这种优势的来源是什么?是为了模型提供了更大的知识存储容量,还是赋予了它更强的知识提取和组合能力?为了回答这个问题,论文设计了一系列基于可控合成任务的实验。

6.1 LoopLM 不增加知识容量

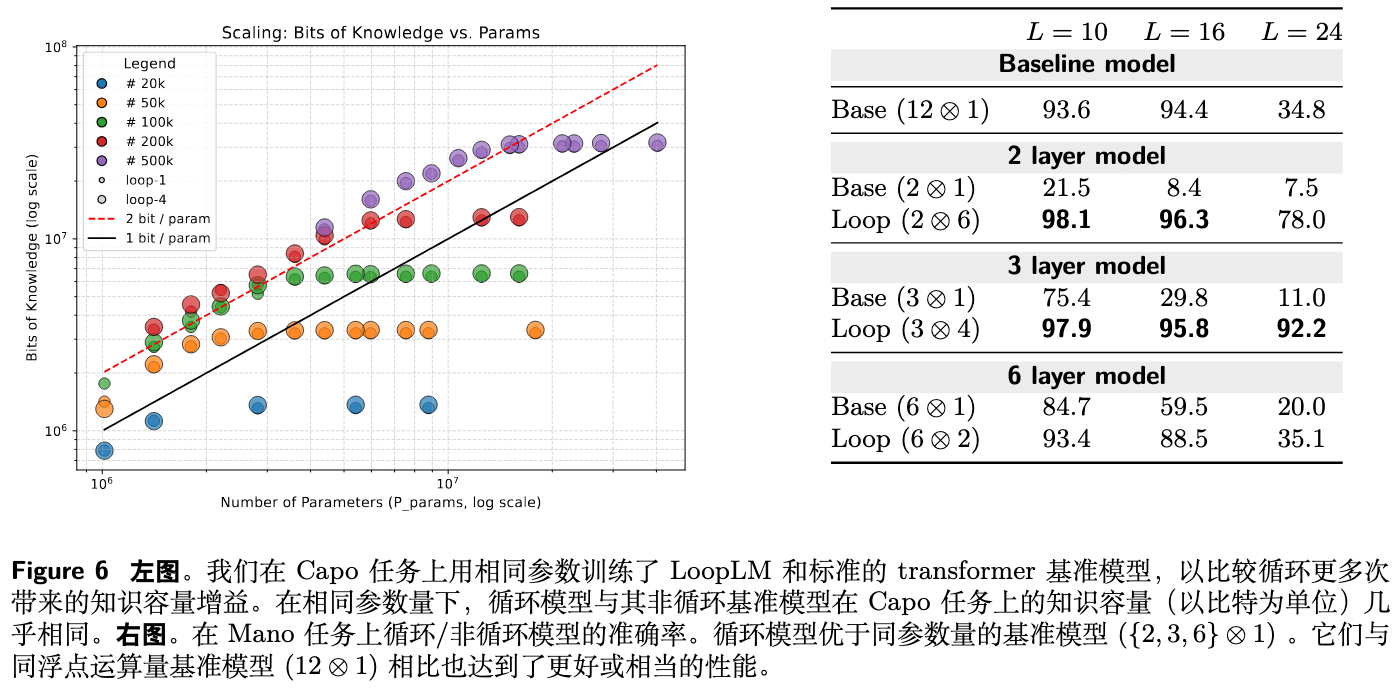

首先,研究者们探究了 LoopLM 的知识容量(knowledge capacity),即模型在参数中存储事实性知识的能力。他们采用了物理语言模型(Physics of language models)框架中的 Capo 任务设置。

-

任务设置:生成大量包含人名及其五个属性(性别、生日、大学等)的合成传记。然后训练一系列不同大小的 GPT-2 风格模型来记忆这些信息。模型的知识容量通过一个度量来衡量,即模型在预测这些属性时所能编码的信息量(以比特为单位),并将其归一化为每参数比特数(bits per parameter)。 -

实验对比:比较了标准模型(循环1次)和 LoopLM(循环4次)在不同参数规模下的知识容量。 -

实验结果 (图 6 左图):结果显示,循环不增加知识容量,也不改善容量的扩展性。无论是否循环,模型的容量比率都稳定在约 2 bits/parameter 左右。这表明,参数数量本身是知识容量的直接指标,单纯增加循环次数并不能帮助模型“记住”更多的东西。

这一发现排除了“LoopLM通过等效于更多参数来存储更多知识”的假设,将优势的来源指向了另一个方向:知识操纵。

6.2 LoopLM 增强知识操纵能力

自然语言任务不仅需要记忆事实,更需要在预测下一个词时组合、运用不同的知识片段,这一过程被称为知识操纵(knowledge manipulation)。为了验证循环是否有助于模型更灵活地使用已存储的知识,研究者们使用了两个合成任务:

-

Mano 任务:一个基于模运算的复杂树状结构算术任务。例如,输入 <bos> + * a b c <eos>要求模型直接输出 的结果,中间没有思维链。要解决此任务,模型需要:(1) 应用存储在参数中的模运算规则;(2) 解析输入的二叉树结构以正确组合运算。 -

多跳问答 (Multi-hop QA) 任务:一个基于合成事实的自然语言多跳推理任务。例如,给定事实“A 的导师是 B”和“B 的老师是 C”,回答问题“A 的导师的老师是谁?”。

-

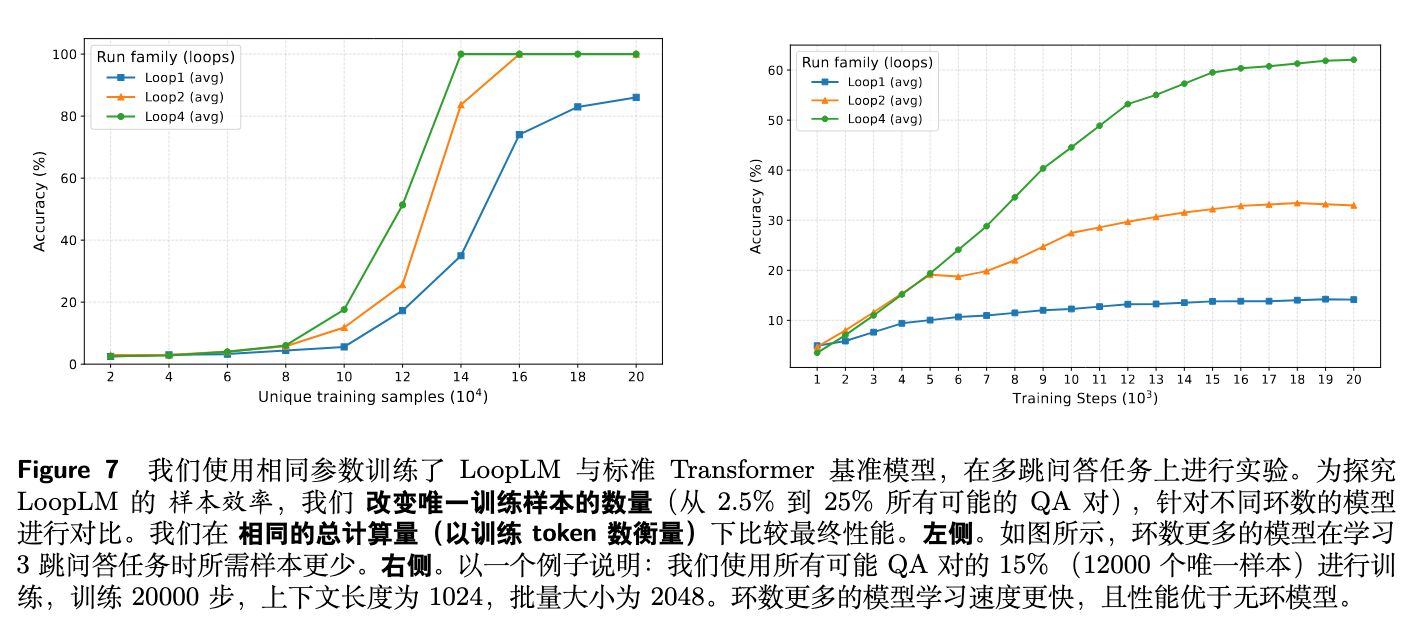

实验结果 (图 6 右图和图 7) -

在 Mano 任务中,给定相同的参数量,LoopLM 的性能始终优于其非循环的对应模型。 -

在多跳问答任务中,LoopLM 表现出更高的样本效率。与非循环模型相比,它只需要更少的训练样本就能学会三跳推理任务。在训练步数相同的情况下,循环次数越多的模型学习速度越快,最终性能也更高。

-

这些结果共同表明,LoopLM 拥有更好的知识操纵归纳偏置。在相同的训练和计算预算下,当任务需要操纵能力(如解析算术树)和有限的知识(如模运算规则)时,LoopLM 能达到相当甚至更好的性能。

7. 从图可达性看 LoopLM 的效率

论文进一步从理论上探讨了 LoopLM 在知识操纵任务上的效率来源。他们将推理过程抽象为一个在知识图上的搜索问题,其中部分图结构(事实)来自上下文,而大部分则编码在模型参数中。

研究者证明了一个非正式的定理:

定理 1 (非正式) :给定一个组合知识图 (直径为 ),存在一个单层 Transformer,通过 次循环,可以判断图中任意两个节点是否存在路径。

这个结果表明,Universal Transformer 能够利用其循环结构,通过类似于并行矩阵乘法的机制(重复平方),在探索所有节点对的连通性时最大化并行性,从而将所需的顺序计算步骤从传统的 或 指数级地减少到 。这种高效的潜在推理能力,可能解释了 LoopLM 在需要多步推理和知识组合的重推理任务上的优越性能。

8. 实用性、安全性与忠实性探讨

除了性能和效率,论文还探讨了 LoopLM 架构在部署时的一些重要特性。

-

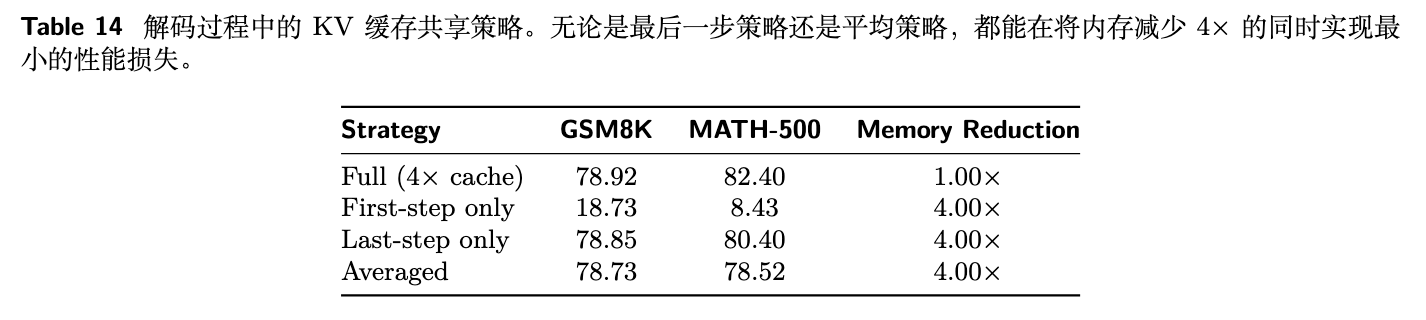

推理效率:KV 缓存共享 -

循环架构的一个潜在挑战是推理时的内存开销。朴素的实现中,每次循环都需要维护独立的 KV 缓存,对于一个 4 步模型,这意味着 4 倍的内存占用。 -

研究发现,在解码(自回归生成)阶段,KV 缓存的重用是可行的。实验表明,只保留最后一步的 KV 缓存,或使用所有步骤的平均 KV 缓存,可以在将内存需求降低 4 倍的同时,几乎不损失性能 (表 14)。这一发现使得 LoopLM 模型的部署在内存占用上与标准 Transformer 相当,解决了其实用性的一个关键障碍。

-

-

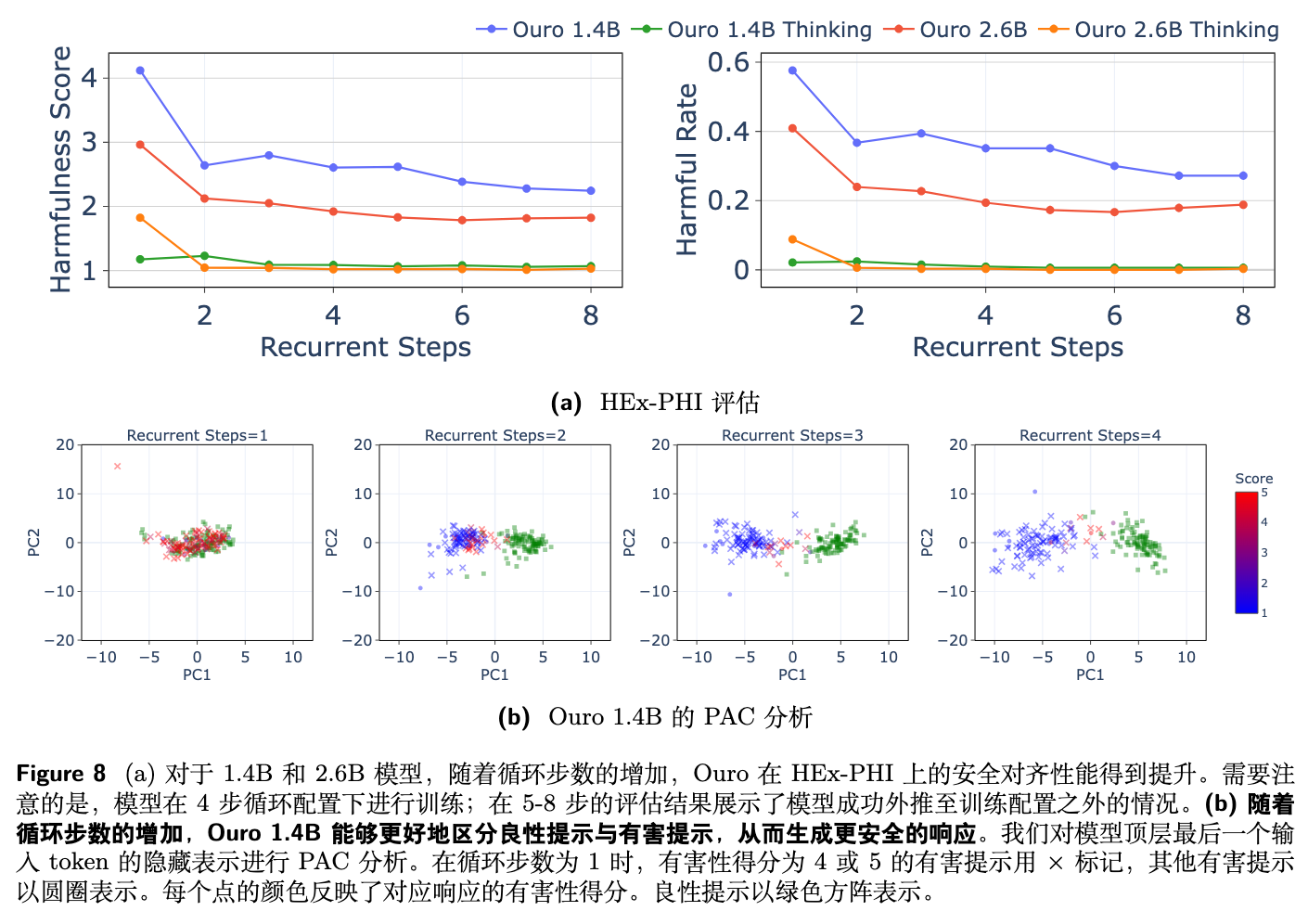

安全性 -

使用 HEx-PHI 数据集评估模型的安全性,分数越高表示越不安全。 -

结果 (图 8a) 显示,随着循环步数的增加,Ouro 模型的安全对齐性得到改善(有害性得分降低)。 -

一个值得注意的发现是,即使在外推到 的情况下,安全性的改善趋势依然持续。这与任务性能在外推时下降的现象形成鲜明对比,表明迭代优化过程持续增强了模型的安全对齐。

-

-

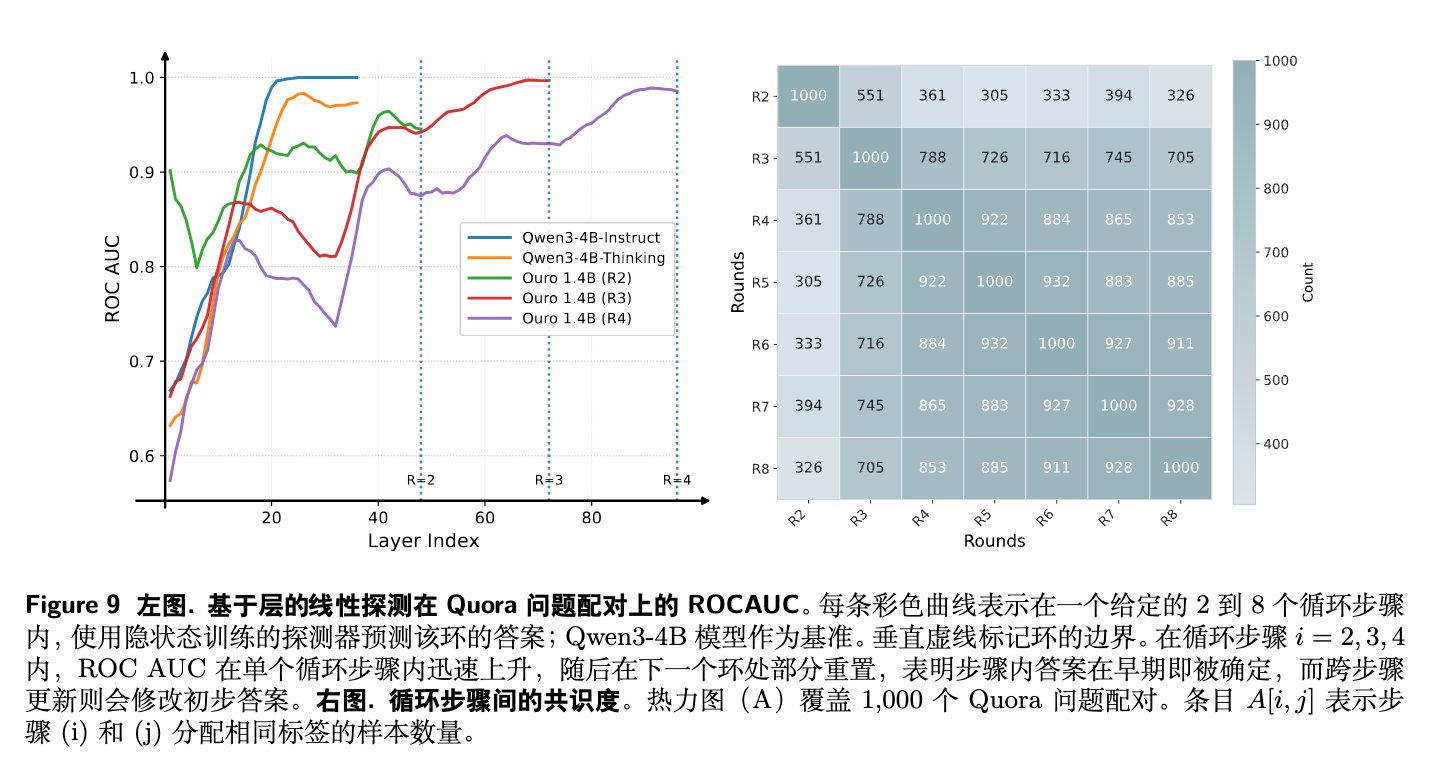

忠实性 (Faithfulness) -

一个忠实的推理过程,其推理步骤应该与最终答案存在因果关系。标准的 CoT 被发现存在“事后合理化”问题,即模型可能先确定答案,再生成一个看似合理的解释。 -

在 LoopLM 中,推理的基底是潜在状态序列 。由于每一步都受到任务损失的直接监督,其解码出的中间结果可以被视为内部状态的一个忠实快照。 -

通过在 Quora Question Pairs 数据集上进行实验 (图 9),研究者发现,随着循环步数的加深,模型对问题的判断会发生系统性的变化和修正,而非仅仅固守一个预先确定的答案。这表明 LoopLM 的潜在过程是一个真实的、决策不断被更新的推理过程,而不是对最终输出的“冰冻”合理化。

-

9. 总结

这篇论文系统地介绍了 Ouro,一个基于循环语言模型(LoopLM)架构的模型家族。通过将迭代计算和自适应深度直接整合到大规模预训练中,该工作展示了参数效率的一个新方向。其核心贡献可以总结为:

-

提出了迭代潜在计算作为模型扩展的第三个关键轴,超越了传统的参数和数据扩展。 -

实验证明,1.4B 和 2.6B 的 Ouro 模型在性能上可以达到或超过 4B 和 8B 的标准 Transformer,实现了 2-3 倍的参数效率提升。 -

通过一系列精心设计的合成任务,揭示了这种优势的根源在于卓越的知识操纵能力,而非知识存储容量的增加。 -

提出了一套实用的训练方法,包括使用均匀先验的熵正则化目标来学习自适应深度,并验证了高效的 KV 缓存共享策略,使 LoopLM 在真实部署中切实可行。 -

展示了 LoopLM 架构独特的优良特性:其安全对齐性会随着循环步数的增加(即使是外推)而单调提升,并且其潜在的迭代过程提供了一个比 CoT 更具因果忠实性的推理轨迹。

往期文章: