强化学习,特别是通过从结果中学习(outcome-based learning)的方法,在提升模型在数学、代码等短上下文、具有明确验证标准的任务上的推理能力方面取得了显著成功。其核心在于通过奖励信号引导模型探索更优的“思维链”(Chain-of-Thought, CoT)。然而,将这一范式直接迁移到长上下文推理任务中,会遇到两个核心障碍:

-

高质量训练数据的匮乏:有效的 RL 训练依赖于大量具有挑战性、无法仅通过简单检索解决、且答案可被清晰验证的问题。在长上下文领域,满足这些条件的公开数据集极为稀缺。构造这样的数据不仅成本高昂,而且难以保证其复杂度和真实性。 -

训练成本的挑战:RL 的“展开”(rollout)过程——即模型生成完整的解题轨迹以获得奖励——计算成本巨大。当上下文长度从短文本的数百或数千词元扩展到 128K 甚至更长时,每一次展开的计算和内存开销都会急剧增加,使得在标准计算资源下进行大规模 RL 训练变得不切实际。

我们如何在可控的计算成本下,为模型系统性地注入在长文本中进行高级推理的能力?

来自微软亚洲研究院的论文《LOONGRL: REINFORCEMENT LEARNING FOR ADVANCED REASONING OVER LONG CONTEXTS》中,为此问题提供了一个数据驱动的解决方案。他们提出的 LoongRL 方法,其核心思想并非直接在超长文本上进行昂贵的强化学习,而是通过一种名为 KeyChain 的数据合成方法,将现有的短上下文多跳问答(multi-hop QA)任务,转化为具有高度挑战性的长上下文推理任务。通过在这种精心构造的数据上进行 RL 训练,模型能够学习到一种“规划-检索-推理-复核”(plan-retrieve-reason-recheck)的 emergent reasoning pattern。研究表明,这种在新数据上学得的推理模式具备良好的泛化能力,使得在 16K 长度的上下文上训练的模型,能够有效地解决长达 128K 的推理任务,从而在保证效果的同时,显著降低了训练成本。

-

论文标题:LOONGRL: REINFORCEMENT LEARNING FOR ADVANCED REASONING OVER LONG CONTEXTS -

论文链接:https://arxiv.org/pdf/2510.19363

1. LoongRL

LoongRL 的成功离不开一个高质量的、专为长上下文推理设计的 RL 训练数据集。研究者认为,一个有效的数据集必须遵循三个原则:

-

真实性(Reliability):问题的题干和标准答案应来源于真实世界的数据集,以避免合成数据中常见的幻觉和偏差问题。 -

上下文依赖性(Context-Dependence):解决问题必须依赖于对提供的长篇上下文的理解和推理,而不能仅仅依赖模型自身的内部知识或简单的直接检索。 -

挑战性(Challenge):问题的难度应足以激发模型进行复杂的、多步骤的推理,从而为强化学习提供足够的信号来学习高级推理策略。

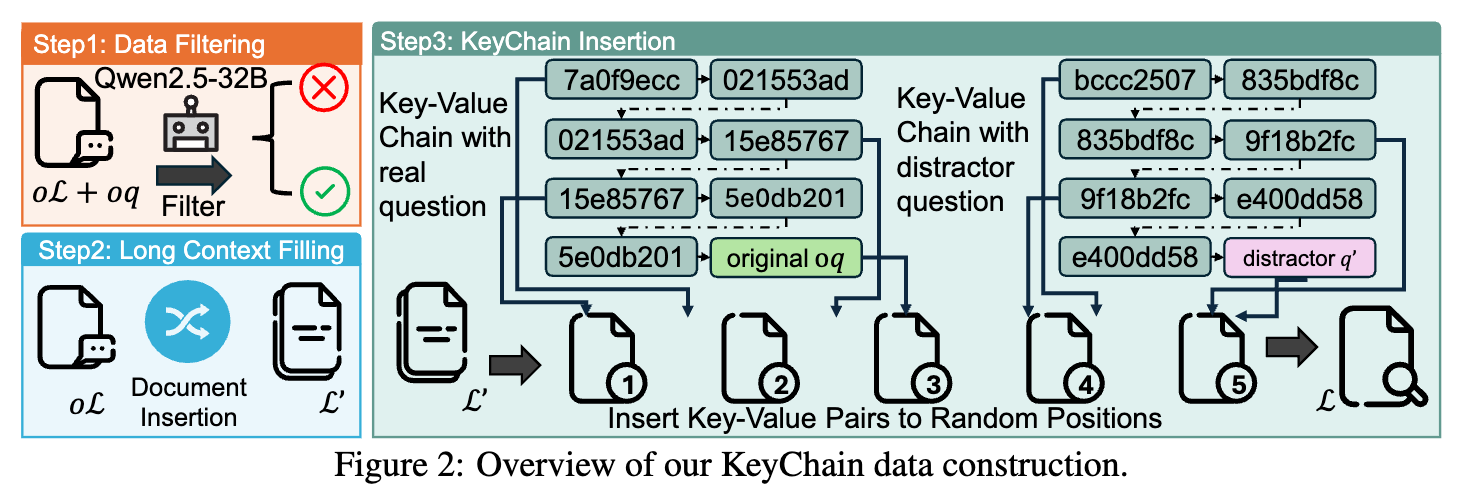

基于以上原则,研究者设计了 KeyChain 数据构建流程,该流程可概括为三个主要步骤,如下图所示。

1.1 步骤一:种子数据集筛选与上下文扩展

首先,作者从三个经典的、真实世界的多跳问答数据集中筛选种子数据,它们分别是 HotpotQA、MuSiQue 和 2WikiMultiHopQA。这些数据集的共同特点是,每个问题都需要模型结合上下文中的多个分散证据才能回答,天然具备多步推理的属性。

初始的数据集合包含约 27.7 万个问答对 ,其中 是原始的短上下文, 是原始问题, 是原始答案。为了确保 RL 训练的效率和有效性,研究者对这些数据进行了难度筛选。他们使用一个强大的基础模型(Qwen2.5-32B-Instruct)对每个问题进行多次回答,并排除了那些通过率为 0(过难)或 1(过易)的问题。这一步筛选出了约 7.2 万个难度适中的问题,为后续的改造提供了高质量的素材。

接下来是上下文扩展。对于每个筛选后的问答对,研究者通过插入大量从其他被过滤掉的问答对中抽取的、不相关的“干扰文档”,将其原始的短上下文 扩展成一个约 16K 词元长度的长上下文 。在这一过程中,原始问题 和答案 保持不变。这个步骤模拟了真实世界中信息检索的场景:关键信息往往淹没在海量的无关文本中,模型需要具备精准的检索能力才能继续下一步的推理。

1.2 步骤二:KeyChain 注入与问题转化

这是整个数据构建方法中最核心的一步。经过上下文扩展后,虽然文本变长了,但问题本身对于强大的 LLM 来说可能仍然过于直接。为了进一步提升任务的难度,迫使模型进行更深层次的、有规划的探索,找到要回答的问题,研究者引入了 KeyChain 机制。

具体而言,他们为每个样本 在其长上下文 中随机插入若干条线性的“键值链”(key-value chains)。这些链条由 UUID(通用唯一识别码)作为键和值构成,形成一个需要逐步追踪的路径。例如,一个键 UUIDA-1 对应的值是 UUIDA-2,UUIDA-2 的值是 UUIDA-3,依此类推。

研究者设计了两种类型的链条:

-

正确的问题链:只有一条链的最终值会指向原始的、需要被回答的那个问题 。 -

干扰链:其他所有链的最终值都指向一个从数据集中随机抽取的、不相关的“干扰问题”。

在插入这些键值对后,原始的长上下文 演变成了最终的训练上下文 。同时,原始的问题 被一个新的、引导性的问题 所取代。这个新问题 的内容大致如下:

请阅读以下文本。

<Document 0>

<original text> {"UUIDB-n": "distracting question"} <original text>

<Document 1>

{"UUIDA-1": "UUIDA-2"}

<Document 2>

{"UUIDB-1": "UUIDB-2"}

...

{"UUIDA-n": "correct question"}

...

在上面的文本中,有一个正确的问题需要回答。

这个问题只能通过追踪由 UUID 字符串编码的正确的、连续的键值对链条来找到,起始点是 "starting UUIDA-1"。

请先找到正确的问题,然后回答它。

通过这样的设计,一个原本的问答任务 被转化成了一个更为复杂的任务 ,其中 。为了解决这个新任务,模型必须:

-

追踪链条:从给定的起始 UUID( UUIDA-1)出发,在长达 16K 的文本中一步步地进行键值查找,直到找到链条的末端。 -

定位问题:从链条的末端恢复出那个被“隐藏”的真正问题 。 -

执行推理:在理解了真正的问题后,在整个长上下文 中检索相关的证据,并进行多跳推理,最终得出答案 。

这种构造方式确保了任务的难度和上下文依赖性。模型无法通过简单的关键词匹配或利用内部知识来“作弊”,它必须严格地遵循一个“先追踪、后推理”的复杂流程。

1.3 KeyChain 引发的 Emergent Reasoning Pattern

研究者观察到,经过 KeyChain 数据训练后,模型在解决长上下文问答任务时,会自发地展现出一种高度结构化的、类似人类的推理模式,他们称之为“规划-检索-推理-复核”(plan-retrieve-reason-recheck)。

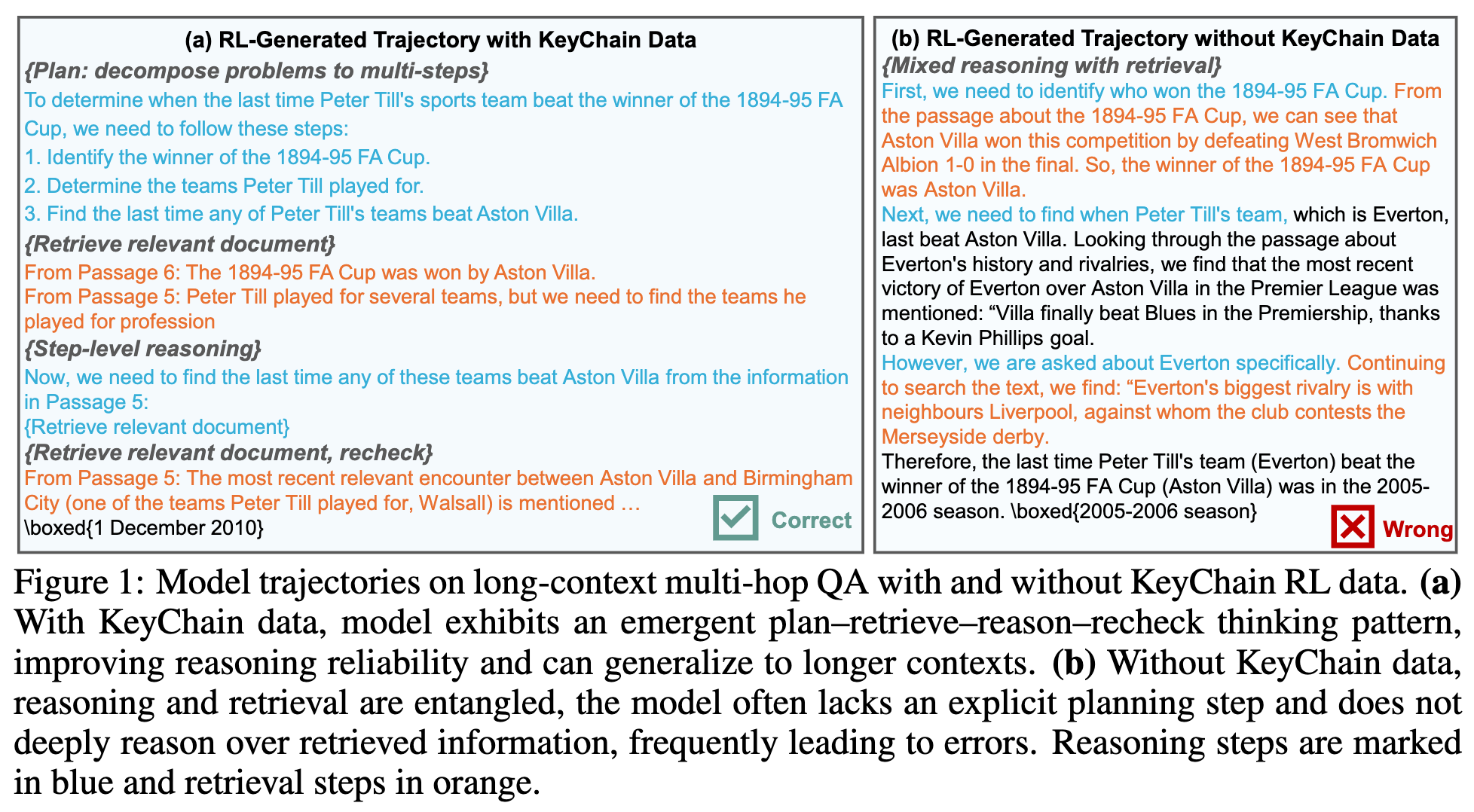

如上图 (a) 所示,在使用 KeyChain 数据训练后,模型在面对一个复杂问题时,其推理轨迹表现出清晰的层次结构:

-

规划(Plan):首先,模型会将复杂问题分解成多个子问题或步骤。例如,对于问题“彼得·蒂尔的球队上一次击败 1894-95 赛季足总杯冠军是在什么时候?”,模型会规划出三个步骤:1. 确定 1894-95 赛季足总杯的冠军。2. 确定彼得·蒂尔效力过的球队。3. 查找这些球队最近一次击败第一步中确定的冠军的时间。 -

检索(Retrieve):针对每一个子问题,模型会从长上下文中检索相关的信息片段。 -

推理(Reason):模型基于检索到的信息进行逻辑推理。 -

复核(Recheck):在推理过程中,如果遇到不确定或信息不足的情况,模型会主动地返回原文进行二次检索和核对,以确保信息的准确性。

相比之下,如上图 (b) 所示,未使用 KeyChain 数据、仅在常规长上下文问答数据上训练的模型,其推理过程则显得较为混乱。推理和检索步骤常常纠缠在一起,缺乏明确的规划阶段,并且很少进行信息的复核,因此更容易出错。

这种 emergent pattern 的出现,证明了 KeyChain 数据成功地迫使模型学习了更加鲁棒和可靠的推理策略。重要的是,这种在 16K 上下文长度上学到的推理模式,能够有效地泛化到更长的上下文(如 128K),这为解决超长上下文推理任务的训练成本问题提供了可行的路径。

2. 长上下文强化学习

在构建了高质量的 KeyChain 数据集之后,研究者设计了一套完整的长上下文强化学习流程,包括所采用的 RL 算法、奖励函数设计以及多阶段训练策略。

2.1 GRPO

训练采用了 GRPO 算法,这是一种策略优化算法。对于数据集 中的每一个样本 ,GRPO 首先从旧的策略 中采样一组(Group)共 条 rollout 轨迹 。然后,通过最大化以下目标函数来更新策略 :

其中:

-

是重要性采样比率。 -

是优势函数的估计值。 -

和 是超参数,分别控制重要性比率的裁剪范围和 KL 散度惩罚的权重,用于稳定训练过程。

优势函数的计算方式如下:

这里, 是轨迹 获得的奖励。优势函数的计算基于整个组的奖励,通过标准化处理,可以使得学习信号更加稳定。

2.2 基于规则的奖励设计

对于开放式的问答任务,设计一个精确的奖励函数是一个挑战,因为一个问题可能存在多种不同表述但含义正确的答案。使用 LLM-as-a-judge 的方法虽然灵活,但会引入额外的计算开销和潜在的偏见。

为了解决这个问题,研究者采用了一种简单而有效的基于规则的奖励设计。首先,他们在训练的 prompt 中明确要求模型将最终答案放在一个特定的盒子标签 \boxed{} 中,这样可以无歧义地抽取出最终答案。然后,他们设计了一个“双向子字符串精确匹配”(two-way substring exact match)的规则来计算奖励。具体来说,对于模型生成的答案 和标准答案 ,只要满足 或者 中的任意一个条件,该轨迹就会获得奖励 ,否则奖励为 0。

2.3 多阶段训练策略与数据混合

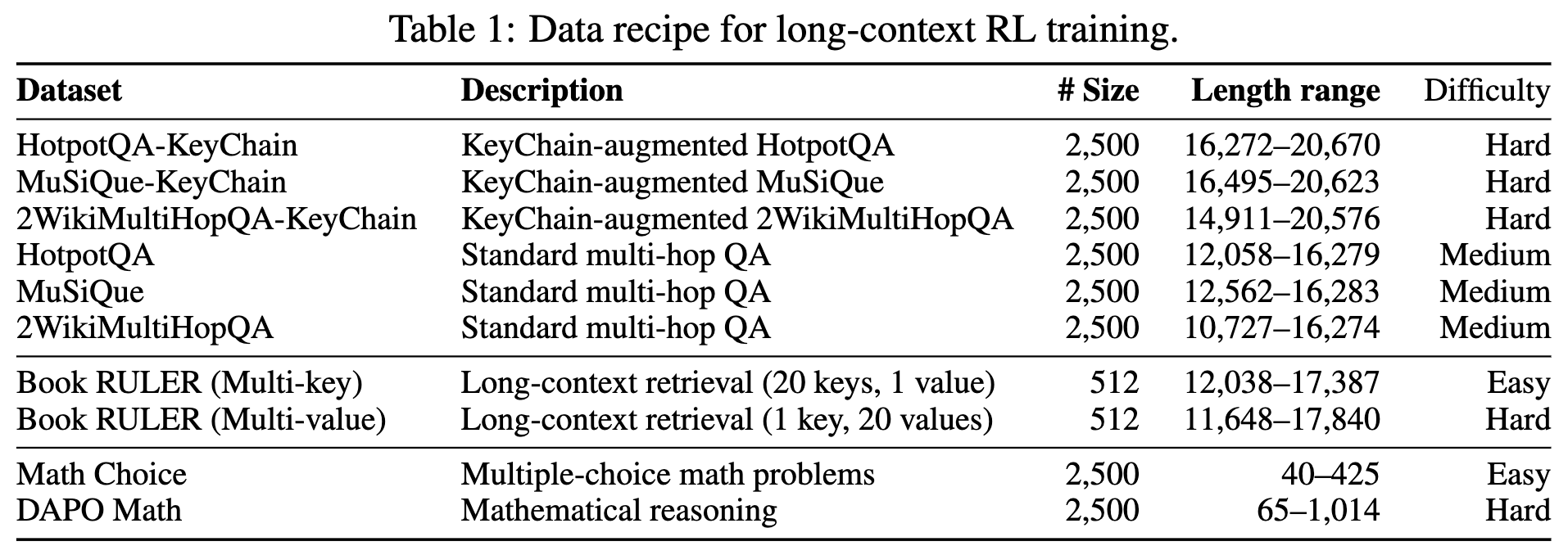

为了使模型能够逐步适应高难度的 KeyChain 任务,并同时保持其在其他任务上的通用能力,研究者设计了一个三阶段的课程学习(curriculum learning)策略,并搭配了训练数据。

训练数据由四部分组成:

-

高难度 KeyChain 数据:即前文描述的、从三个多跳问答数据集合成的 7500 个样本,用于引导模型学习高级推理模式。 -

中等难度多跳问答数据:不经过 KeyChain 改造的、标准的 7500 个长上下文多跳问答样本。这些数据对于较小的模型尤其重要,可以在早期帮助模型建立基础的推理能力。 -

长上下文检索数据:从 RULER 数据集中构造的 1024 个“大海捞针”任务,用于维持模型在长文本中的信息检索能力。 -

短上下文数学数据:包含 5000 个短上下文的数学问题,用于保持模型在通用推理任务(如数学)上的能力,防止在长上下文训练中发生能力退化。

基于这些数据,训练流程分为三个阶段:

-

阶段一:热身(Warm-up):模型首先在不包含 KeyChain 数据的混合数据集上进行一个周期的训练。这个阶段的目的是让模型先在相对容易的任务上提升其检索和基础推理能力,为后续挑战高难度任务打下基础。 -

阶段二:KeyChain 增强(KeyChain Augmentation):在热身阶段后,将 KeyChain 数据引入训练集。这个阶段是学习核心推理模式的关键,模型被激励去规划、检索、整合信息,以解决这些复杂的合成任务。 -

阶段三:难度聚焦训练(Difficulty-focused Training):在阶段二结束后,研究者使用当前最优的模型对每个训练样本进行多次(8次)rollout。那些在所有 rollout 中都能被正确解决的“简单”样本被移除,只保留至少有一次失败的“困难”样本(约占数据的 30-40%)。RL 训练在这些困难样本上继续进行,从而将模型的学习资源集中在最具挑战性的问题上,进一步提升模型能力的上限,同时避免在已经掌握的问题上过度训练。

3. 实验

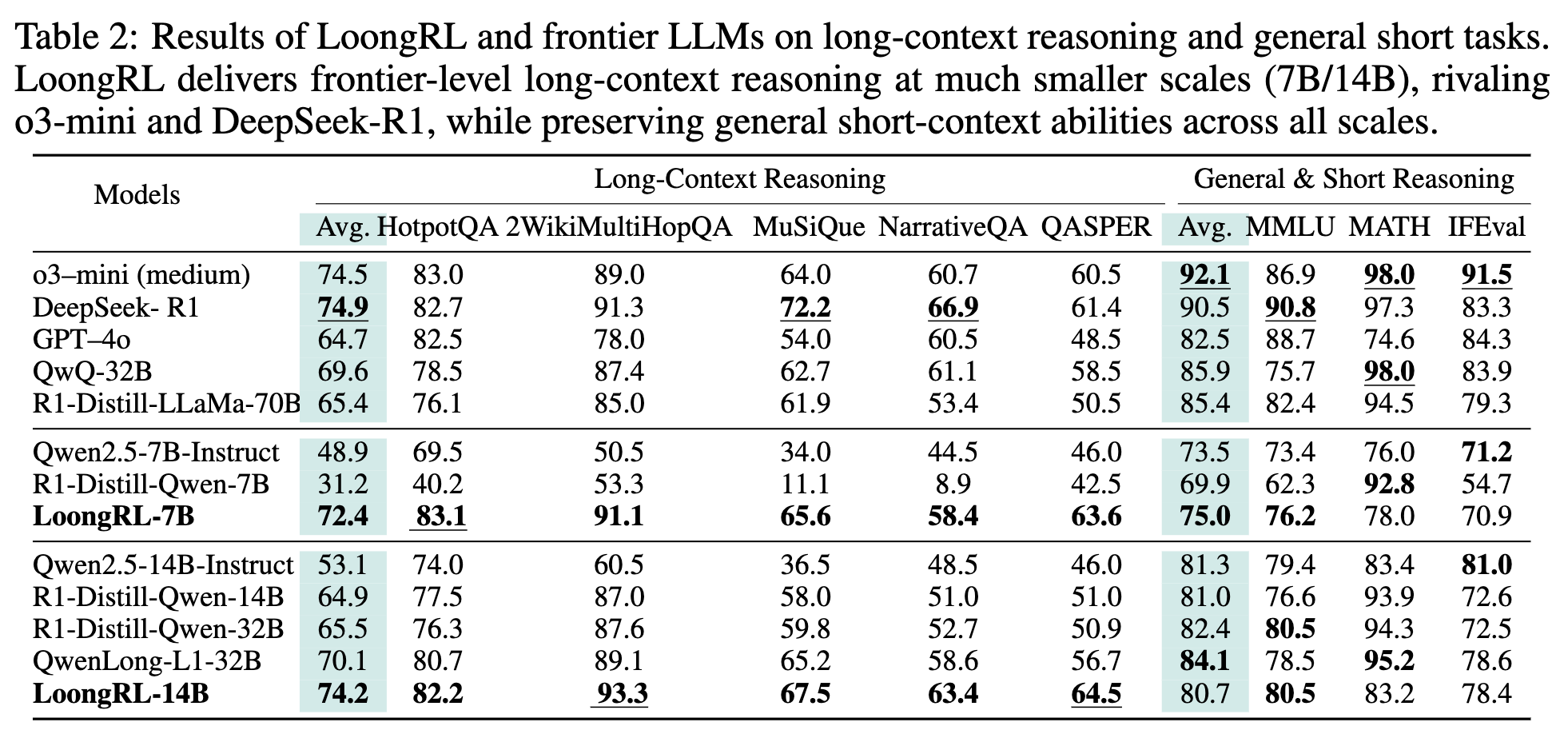

作者在 Qwen2.5-7B-Instruct 和 Qwen2.5-14B-Instruct 两个模型上进行了 LoongRL 训练,并与一系列当前领先的模型进行了全面的比较。

3.1 主要结果

实验结果揭示了 LoongRL 的显著优势:

-

在小模型上实现了前沿性能:LoongRL-14B 在长上下文推理基准 LongBench v1 上的平均分达到了 74.2,这个成绩不仅远超其基础模型(53.1),甚至可以与体量远大于它的 o3-mini(74.5)和 DeepSeek-R1(74.9)等模型相媲美。LoongRL-7B 的表现同样出色,其 72.4 的得分超过了所有 R1-distilled 模型和 QwenLong-L1-32B。这表明,通过数据驱动的 RL 方法,可以在参数规模较小的模型上实现顶级的长上下文推理能力。 -

KeyChain 驱动的 RL 效率高:与传统的长 CoT 数据蒸馏方法相比,LoongRL 的提升幅度十分显著。它将 Qwen2.5-7B 和 14B 模型的长上下文多跳问答准确率分别提升了 23.5% 和 21.1%。而 R1-distilled Qwen 模型在 14B 尺寸上仅有 11.8% 的提升,在 7B 尺寸上甚至出现了性能下降。这证明了 KeyChain 数据在引导有效推理模式方面的独到之处。 -

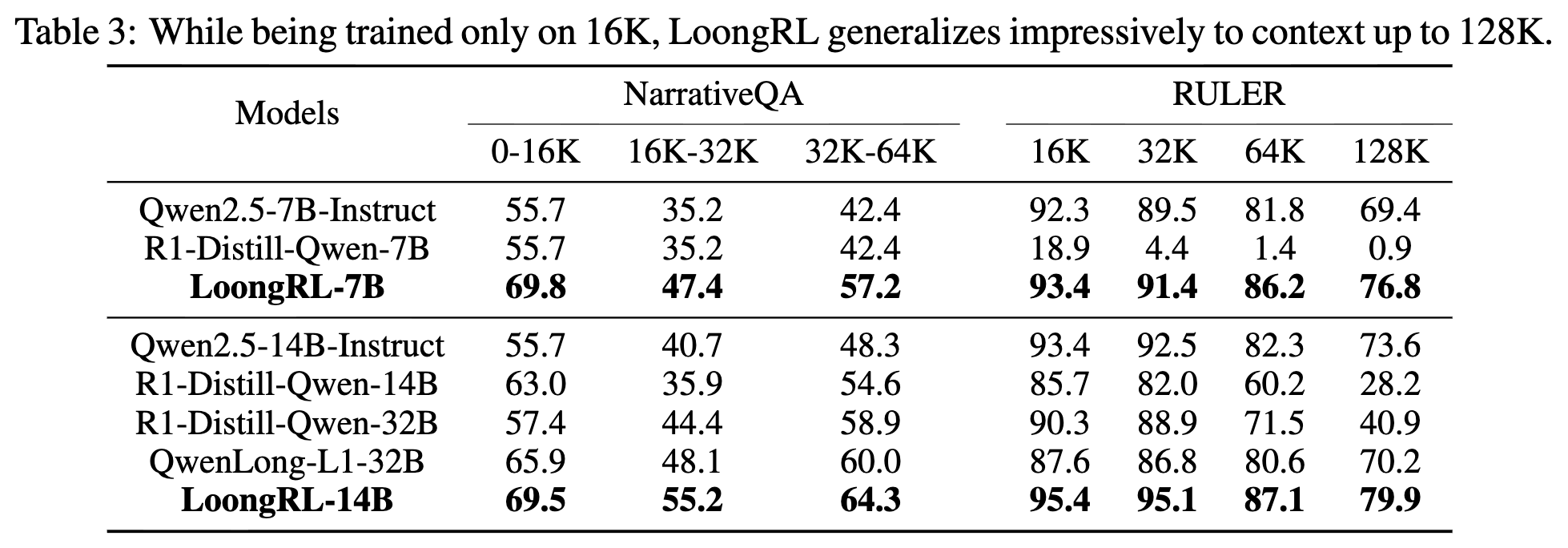

从短文本训练到长文本泛化的成功:LoongRL 模型仅在 16K 长度的上下文上进行训练,但其学到的“规划-检索-推理-复核”模式能够有效地泛化到更长的上下文任务中。

如上表所示,在 NarrativeQA(32K-64K)和 RULER(高达 128K)等需要更长上下文的基准测试上,LoongRL 模型相比于基线模型表现出更强的性能,并且性能随上下文长度增加的衰减速度更慢。这证明了其学习到的推理模式的鲁棒性和可扩展性,成功地用较低的训练成本实现了在超长上下文任务上的优异表现。

-

保持了通用短上下文能力:得益于数据混合策略,LoongRL 在提升长上下文能力的同时,有效保持了其在 MMLU、MATH 和 IFEval 等通用短上下文基准上的性能。相比之下,一些专注于推理蒸馏的 R1-distilled 模型在这些通用能力上出现了明显的下降。

-

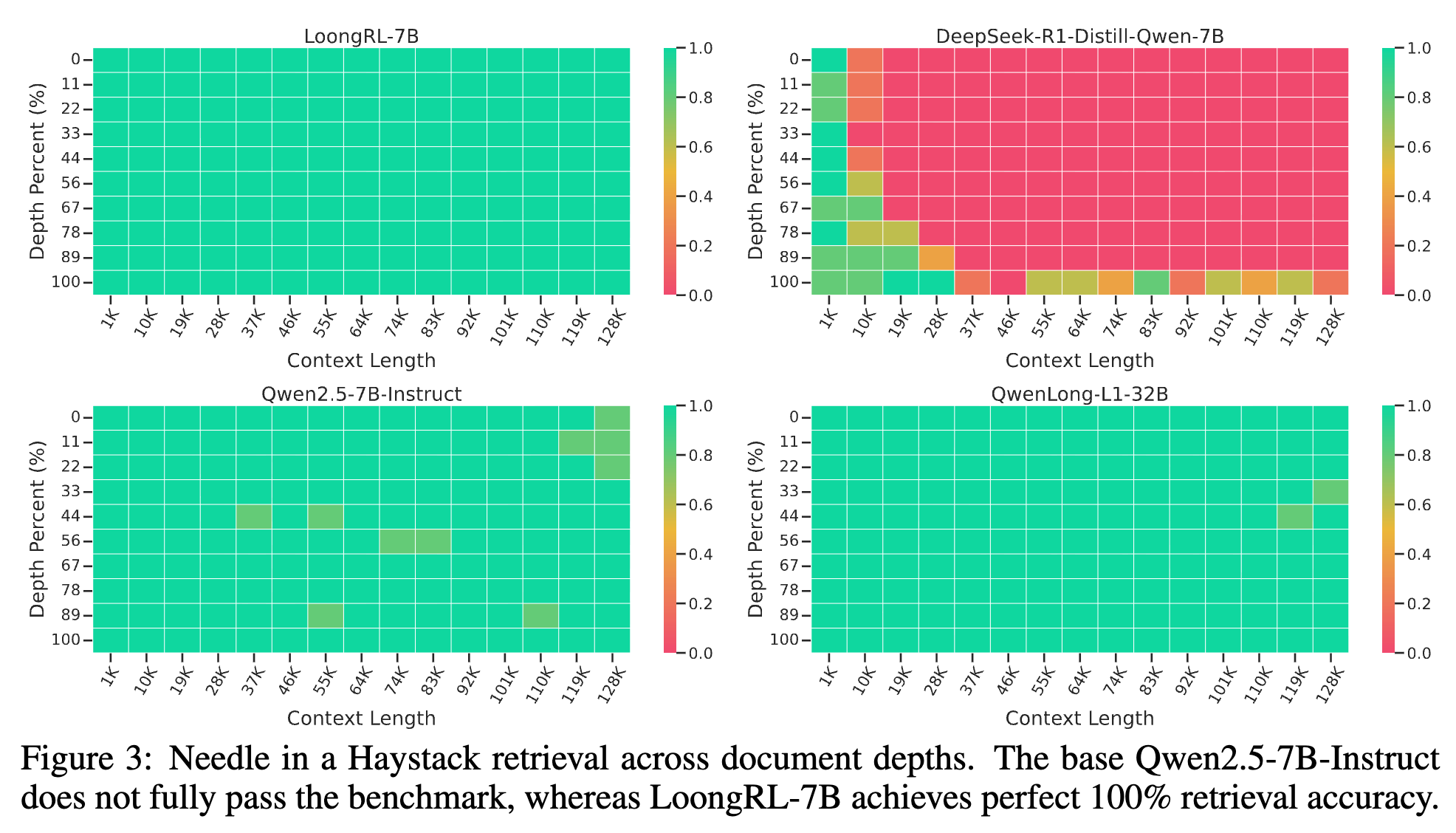

提升了长上下文检索能力:LoongRL 不仅推理能力更强,其基础的“大海捞针”能力也得到了改善。

在上图中,基础的 Qwen2.5-7B-Instruct 模型无法 100% 通过测试,而 LoongRL-7B 则可以在所有深度和长度上实现完美的检索。这表明,为解决 KeyChain 任务而进行的深度、反复的文本扫描,客观上也锻炼了模型的信息检索能力。

3.2 消融研究

-

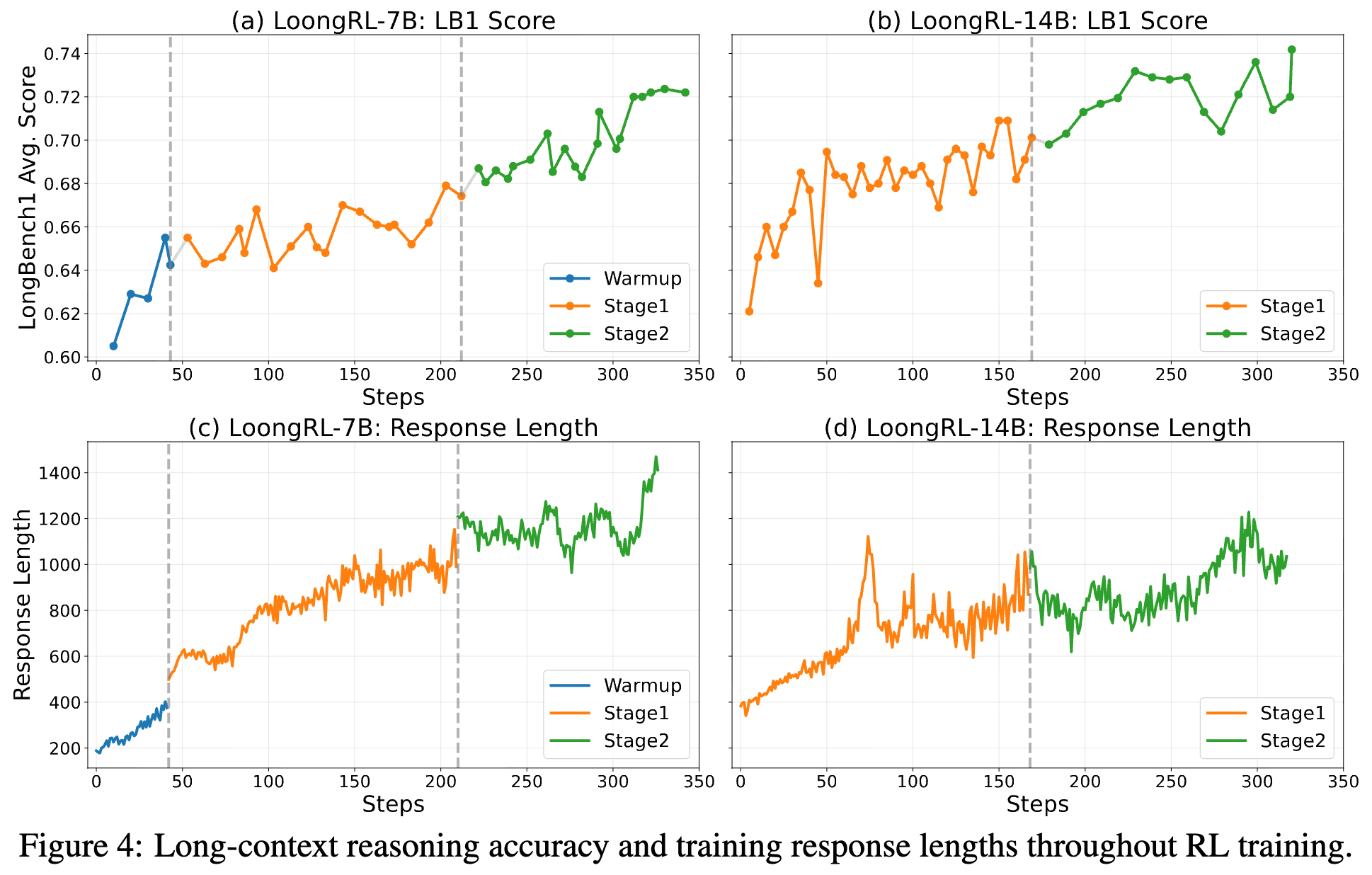

多阶段 RL 训练的有效性:作者报告了 7B 和 14B 模型在三个强化学习阶段中的逐步性能提升和平均训练时长。如图 4(c、d)所示,在整个训练过程中,平均响应长度稳步增加。图 4(a、b)呈现了长上下文推理准确率,该准确率在每个阶段都持续提升,这证明了多阶段强化学习课程的有效性。

-

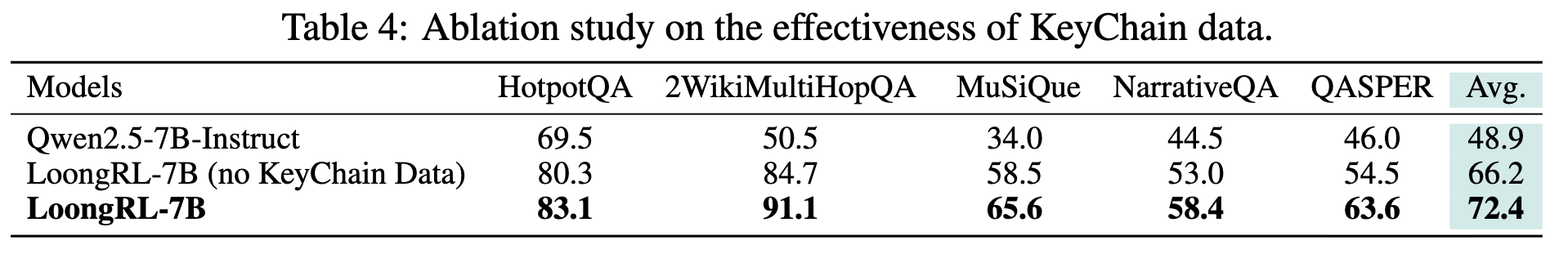

KeyChain 数据的关键作用:如上表所示,如果将 KeyChain 数据替换为等量的、不经改造的常规长上下文多跳问答数据进行 RL 训练,虽然模型性能也有提升(从 48.9 提升到 66.2),但远不及使用 KeyChain 数据所带来的飞跃(提升到 72.4)。这有力地证明了 KeyChain 数据是激发模型学习高级推理模式、实现性能突破的关键所在。

-

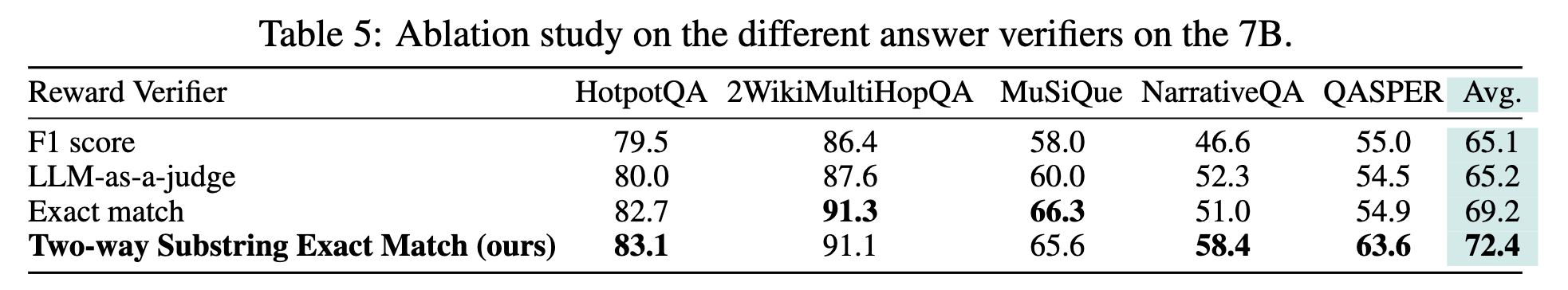

答案验证器的选择:上表比较了四种不同的奖励验证器:F1 score、LLM-as-a-judge、严格精确匹配以及 LoongRL 使用的双向子字符串匹配。实验结果显示,F1 score 和 LLM-as-a-judge 带来的提升有限;严格精确匹配虽然效果更好,但过于严苛;而双向子字符串匹配在保持高准确率的同时,给予了模型合理的灵活性,最终取得了最好的效果(72.4),证明了其作为 RL 奖励函数的实用性和可靠性。

4. 实践启示

-

数据合成是“高杠杆”投入:投入资源去设计和实现像 KeyChain 这样的程序化数据生成流水线,其带来的性能回报可能远超同等成本的、单纯增加模型尺寸或训练时长的投入。

-

从“教知识”到“教方法”:传统微调更多是向模型灌输特定领域的知识或问答模式。KeyChain 的思路则是设计一种“认知难题”,迫使模型在解题过程中自己学会一种通用的、结构化的“解题方法”(即 plan-retrieve-reason-recheck 模式)。这种方法论的学习远比知识点的学习更有价值,因为它具备泛化能力。

-

RL 训练成本可控:论文证明,我们不必在 128K 甚至更长的上下文上进行昂贵的 RL rollout。通过在 16K 这种中等长度的上下文上教会模型一种可扩展的推理模式,就能让它在更长的文本上表现出色。

-

降低微调门槛:这个思路为拥有中等计算资源(例如几十到上百张 A100/H100)的团队,提供了微调出具备顶级长文本推理能力模型的可能性。他们无需直接对标头部厂商在超长文本上的训练规模,而是可以专注于在中等长度上把“数据质量”做到极致。

往期文章: